1.8k Star!RAGApp:在任何企业中使用 Agentic RAG 的最简单方法!

原文链接:(更好排版、视频播放、社群交流、最新AI开源项目、AI工具分享都在这个公众号!)

1.8k Star!RAGApp:在任何企业中使用 Agentic RAG 的最简单方法!

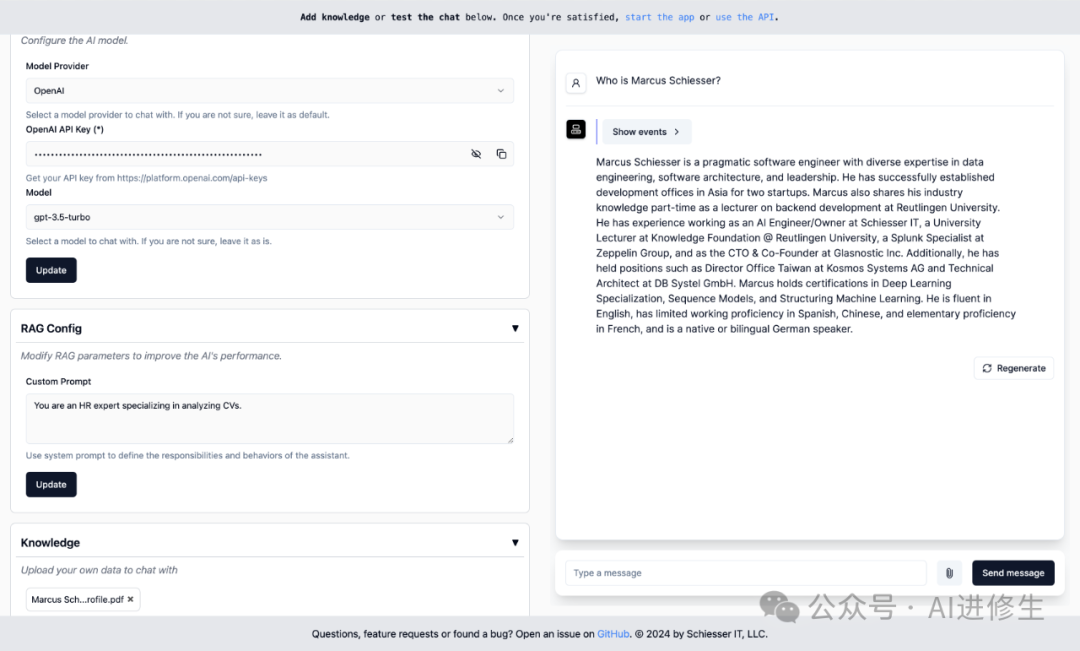

🌟在任何企业中使用 Agentic(代理的) RAG 的最简单方法!配置起来与OpenAI 的自定义GPTs一样简单。

嘿,欢迎来到Aitrainee的频道。今天我要给大家介绍一个非常酷的新应用——RAGApp。

** RAGApp ** ,顾名思义,就是一个开源的 RAG 应用程序,可以让你和 PDF、DOC、电子表格等文档聊天。你可以用它来创建各种 RAG

代理,比如财务代理、股票代理、编码代理、一般聊天代理等等。使用它就像 ChatGPT 一样简单,几秒钟就能上手,而且它比 ChatGPT 更强大。

RAGApp 兼容多种平台,包括 Ollama(适用于本地模型) 、OpenAI、Groq、HuggingFace、Gemini

等等。你还可以用它连接 GPT-4O、Gemini 1.5 Pro 和 Gemini 1.5 Flash,以及 Mistral AI 的 Mixtral

8x22b、LLaMa、Gemini 和 OpenAI API。

配置起来与OpenAI 的自定义GPTs一样简单,但可以使用 Docker 在你自己的云基础架构中部署。使用LlamaIndex( LLM

应用程序的数据框架 开源项目 )构建。

▲ 配置起来与OpenAI 的自定义 GPT一样简单

教程&演示视频: 人工智能自动完成代码以免费创建软件!

油管博主: AlCodeKing / 字幕译:Aitrainee, 链 接在 这里 :

https://www.youtube.com/watch?v=V2tQVzyQiiY

开始使用

要运行 RAGapp,请使用镜像启动一个 Docker 容器:

docker run -p 8000:8000 ragapp/ragapp

启动容器后,在浏览器中访问 http://localhost:8000/admin 来配置 RAGapp。可以选择使用 OpenAI 或 Gemini

的托管 AI 模型,或者使用 Ollama 的本地模型。

端点

Docker 容器暴露以下端点:

-

管理 UI: http://localhost:8000/admin

-

聊天 UI: http://localhost:8000

-

API 文档: http://localhost:8000/docs

注意 : 聊天 UI 和 API 仅在 RAGapp 配置完成后才可用。

为了确保 RAGapp 的安全,建议在云环境中保护 /admin 路径,因为 RAGapp 本身不包含任何认证层。

部署

使用 Docker Compose

提供了一个 docker-compose.yml 文件,使得在自己的基础设施中轻松部署 RAGapp,并与 Ollama 和 Qdrant

一起使用。

可以通过 MODEL 环境变量指定要使用的模型,例如 llama3 :

MODEL=llama3 docker-compose up

如果未指定 MODEL 变量,将默认使用模型 phi3 ,该模型比 llama3 略弱,但下载速度更快。

注意 :

docker-compose.yml文件中的setup容器将把选定的模型下载到ollama

文件夹中,这个过程可能需要几分钟。

还可以通过 OLLAMA_BASE_URL 环境变量指定要使用的 Ollama 主机。如果未指定 OLLAMA_BASE_URL

变量,默认指向 Docker Compose 启动的 Ollama 实例 ( http://ollama:11434 )。

如果使用的是本地 Ollama 实例,可以通过将 OLLAMA_BASE_URL 变量设置为 http://host.docker.internal:11434 来连接到 RAGapp:

MODEL=llama3 OLLAMA_BASE_URL=http://host.docker.internal:11434 docker-compose up

对于 macOS 用户,这是必要的,因为 Docker for Mac 不支持 GPU 加速。

Kubernetes

可以轻松地在自己的云基础设施中部署 RAGapp。定制的 Kubernetes 部署描述符即将推出,敬请期待。

开发

要进行开发,请按照以下步骤操作:

poetry install --no-root

make build-frontends

make dev

注意 : 在开发过程中查看管理 UI,请访问 http://localhost:3000/admin。

Github:https://github.com/ragapp/ragapp/

知音难求,自我修炼亦艰

抓住前沿技术的机遇,与我们一起成为创新的超级个体

(把握AIGC时代的个人力量)

**

**

** 点这里 👇 关注我,记得标星哦~ **

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见 ~

预览时标签不可点

微信扫一扫

关注该公众号

轻触阅读原文

AI进修生

收藏