k8s教程

1. k8s框架

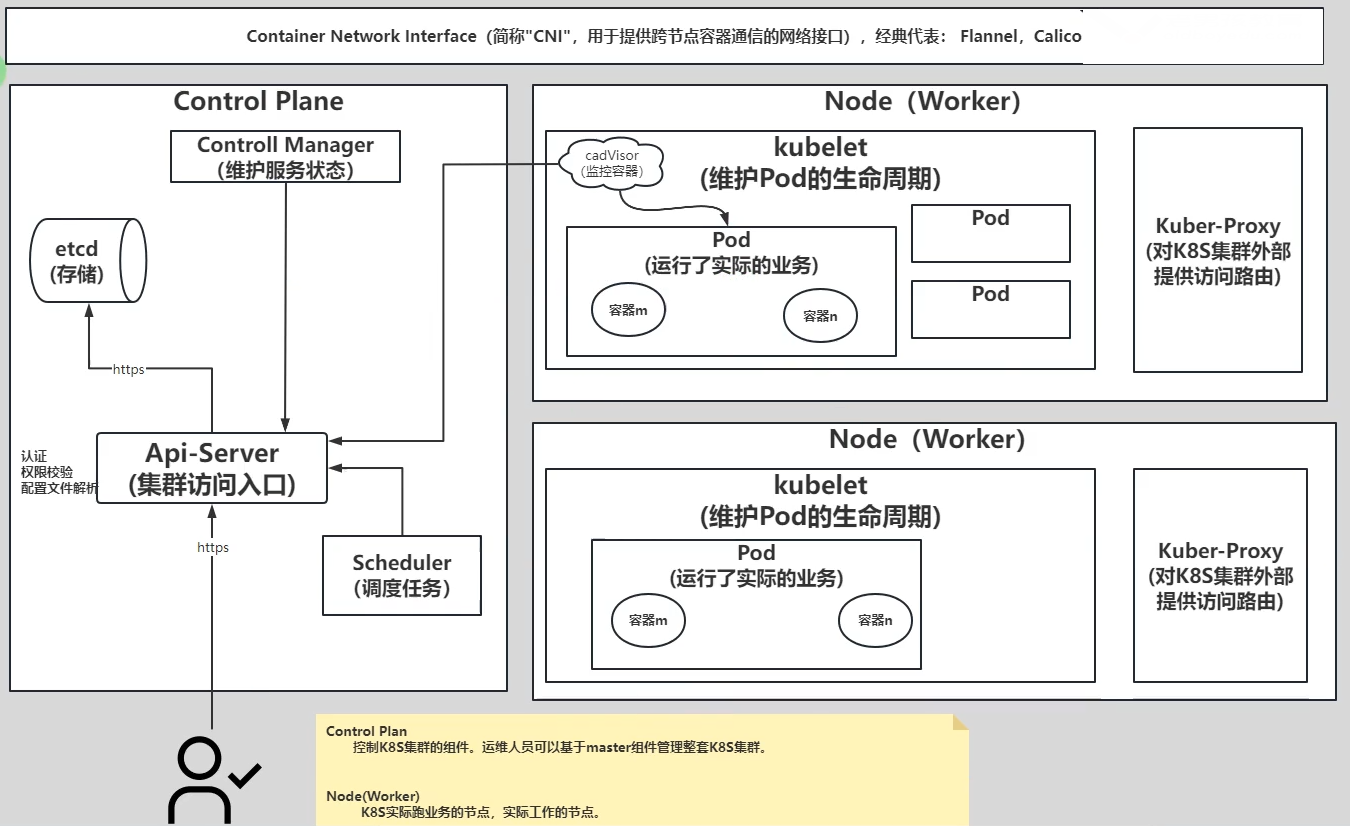

- kubernetes的架构- Control Plane: 控制K8S集群的组件。- Api Server: 集群的访问入口。- etcd: 存储集群的数据。一般情况下,只有API-SERVER会访问.- Control Manager: 维护集群的状态。- Scheduler: 负责Pod的调度功能。- Worker Node: 实际运行业务的组件。- kubelet: 管理Pod的生命周期,并上报Pod和节点的状态。- kube-proxy: 对K8S集群外部提供访问路由。底层可以基于iptables或者ipvs实现。- Kubernetes的常见术语- CNI:Container Network Interface容器网络插件,主要用于跨节点的容器进行通信的组件。- CRI: Container Runtime Interface容器运行接口,主要用于kubelet调用容器的生命周期管理相关即可。docker-shim ---> cri-dockerd,在K8S 1.24已经弃用!若更高版本想要使用docker,需要单独部署docker-shim组件即可。2. kubernetes集群部署方式介绍

kubernetes集群部署方式:

目前生产环境部署kubernetes集群主要由两种方式:- kubeadm:kubeadm是一个K8S部署工具,提供kubeadm init和kubejoin,用于快速部署kubernetes集群。你可以使用kubeadm工具来创建和管理Kubernetes集群,适合在生产环境部署。该工具能够执行必要的动作并用一种用户友好的方式启动一个可用的、安全的集群。推荐阅读:https://kubernetes.io/zh/docs/setup/production-environment/tools/kubeadm/https://kubernetes.io/zh/docs/setup/production-environment/tools/kubeadm/install-kubeadm/https://kubernetes.io/zh/docs/setup/production-environment/tools/kubeadm/create-cluster-kubeadm/- 二进制部署:从GitHub下载发行版的二进制包,手动部署每个组件,组成kubernetes集群。除了上述介绍的两种方式部署外,还有其他部署方式的途径:- yum: 已废弃,目前支持的最新版本为2017年发行的1.5.2版本。- kind安装:kind让你能够在本地计算机上运行Kubernetes。 kind要求你安装并配置好Docker。推荐阅读:https://kind.sigs.k8s.io/docs/user/quick-start/- minikube:适合开发环境,能够快速在Windows或者Linux构建K8S集群。参考链接:https://minikube.sigs.k8s.io/docs/- rancher:基于K8S改进发行了轻量级K8S,让K3S孕育而生。参考链接:https://www.rancher.com/- KubeSphere:青云科技基于开源KubeSphere快速部署K8S集群。参考链接:https://kubesphere.com.cn- kuboard:也是对k8s进行二次开发的产品,新增了很多独有的功能。参考链接: https://kuboard.cn/- kubeasz:使用ansible部署,扩容,缩容kubernetes集群,安装步骤官方文档已经非常详细了。参考链接: https://github.com/easzlab/kubeasz/- 第三方云厂商:比如aws,阿里云,腾讯云,京东云等云厂商均有K8S的相关SAAS产品。- 更多的第三方部署工具:参考链接:https://landscape.cncf.io/3. harbor服务器准备(方便快速拉取镜像)

--------------------harbor(81) 准备docker-ce,docker-compose----------------

#1.安装相关依赖.

yum install -y yum-utils device-mapper-persistent-data lvm2

#2.下载官方的docker yum源文件

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

#3.替换yum源地址

sed -i 's+download.docker.com+mirrors.aliyun.com/docker-ce+' /etc/yum.repos.d/docker-ce.repo

#4.安装docker-ce

yum makecache fast

yum -y install docker-ce docker-compose

systemctl enable --now docker

#检查

docker versionsystemctl disable --now firewalld

sed -i 's/^SELINUX=enforcing$/SELINUX=disabled/' /etc/selinux/config #开启镜像下载加速

mkdir -p /etc/docker

cat > /etc/docker/daemon.json <<EOF

{"exec-opts": ["native.cgroupdriver=systemd"],"registry-mirrors": ["https://docker.1panel.live"]

}

EOF

systemctl daemon-reload

systemctl restart docker--------------------harbor(81) 下载harbor包,安装----------------

harbor]# mkdir -p /app/tools/

harbor]# cd /app/tools/

harbor]# wget https://github.com/goharbor/harbor/releases/download/v2.11.0/harbor-offline-installer-v2.11.0.tgz

harbor]# tar -xvf harbor-offline-installer-v2.11.0.tgz

harbor]# cd harbor

harbor]# tree .

.

├── common.sh

├── harbor.v2.11.0.tar.gz

├── harbor.yml.tmpl #临时配置文件 正式配置文件叫harbor.yml

├── install.sh #每次修改配置 需要执行下

├── LICENSE

└── prepareharbor]# cp harbor.yml.tmpl harbor.yml

harbor]# vim harbor.yml

#修改域名

hostname: harbor.tom.cn#修改登录密码

harbor_admin_password: admin--------------------harbor(81) 证书配置--------------------------------

(1)创建证书的工作目录

[root@harbor ~]# mkdir -pv /app/tools/harbor/certs/{ca,server,client}(2)生成自建CA证书#2.1 进入证书目录

[root@harbor ~]# cd /app/tools/harbor/certs/#2.2 生成CA私钥

[root@harbor certs]# openssl genrsa -out ca/ca.key 4096#2.3 生成ca的自签名证书

[root@harbor certs]# openssl req -x509 -new -nodes -sha512 -days 3650 \-subj "/C=CN/O=example/CN=tom.com" \-key ca/ca.key \-out ca/ca.crt(3)生成harbor服务器的证书及客户端证书#3.1 生成harbor主机的私钥

[root@harbor certs]# openssl genrsa -out server/harbor.key 4096#3.2 生成harbor主机的证书申请

[root@harbor certs]# openssl req -sha512 -new \-subj "/C=CN/CN=tom.com" \-key server/harbor.key \-out server/harbor.csr #3.3 生成x509 v3扩展文件

[root@harbor certs]# cat > v3.ext <<-EOF

authorityKeyIdentifier=keyid,issuer

basicConstraints=CA:FALSE

keyUsage = digitalSignature, nonRepudiation, keyEncipherment, dataEncipherment

extendedKeyUsage = serverAuth

subjectAltName = @alt_names[alt_names]

DNS.1=tom.com

DNS.2=harbor.tom.com

DNS.3=harbor.tom.com

EOF#3.4 使用"v3.ext"给harbor主机签发证书

[root@harbor certs]# openssl x509 -req -sha512 -days 3650 \-extfile v3.ext \-CA ca/ca.crt -CAkey ca/ca.key -CAcreateserial \-in server/harbor.csr \-out server/harbor.crt #3.5 将crt文件转换为cert客户端证书文件

[root@harbor certs]# openssl x509 -inform PEM -in server/harbor.crt -out server/harbor.cert#3.6 准备docker客户端证书

[root@harbor certs]# cp server/harbor.{cert,key} client/

[root@harbor certs]# cp ca/ca.crt client/

[root@harbor certs]# ll client/

-rw-r--r-- 1 root root 2033 Apr 12 10:09 ca.crt

-rw-r--r-- 1 root root 2122 Apr 12 10:09 harbor.cert

-rw-r--r-- 1 root root 3247 Apr 12 10:09 harbor.key#3.7 查看所有证书文件结果

[root@harbor certs]# tree

.

├── ca

│ ├── ca.crt

│ ├── ca.key

│ └── ca.srl

├── client

│ ├── ca.crt

│ ├── harbor.cert

│ └── harbor.key

├── server

│ ├── harbor.cert

│ ├── harbor.crt

│ ├── harbor.csr

│ └── harbor.key

└── v3.ext(4)配置harbor服务器使用证书4.1 切换工作目录

[root@harbor certs]# cd /app/tools/harbor/4.2 修改配置文件

[root@harbor harbor]# vim harbor.yml

...

hostname: harbor.tom.com

https:port: 443certificate: /app/tools/harbor/certs/server/harbor.crtprivate_key: /app/tools/harbor/certs/server/harbor.keyharbor_admin_password: Admin

...

--------------------harbor(81) 安装--------------------------------

./install.sh

#注意要检查80是否被占用

提示successfully

? ----Harbor has been installed and started

successfully.----

成功

需要安装docker和docker-compose

4. K8S服务器需求

三台服务器: k8s节点:10.0.0.231-233,3G/2C/30G

5. k8s v1.23安装(基于kubeadm)

- kubeadm: 快速构建K8S集群,需要单独安装docker,kubectl,kubeadm,kubelet。

本文介绍2个版本的k8s的安装,v1.23,v1.26

5.1. k8s所有节点环境准备

- K8S所有节点环境准备(1)虚拟机操作系统环境准备

参考链接:https://kubernetes.io/zh/docs/setup/production-environment/tools/kubeadm/install-kubeadm/(2)系统配置2.1 临时关闭

swapoff -a && sysctl -w vm.swappiness=02.2 基于配置文件关闭

sed -ri '/^[^#]*swap/s@^@#@' /etc/fstab2.3 启用IPv4转发echo "net.ipv4.ip_forward=1" >> /etc/sysctl.confsysctl -p(3)确保各个节点MAC地址或product_uuid唯一

ifconfig eth0 | grep ether | awk '{print $2}'

cat /sys/class/dmi/id/product_uuid 温馨提示:一般来讲,硬件设备会拥有唯一的地址,但是有些虚拟机的地址可能会重复。 Kubernetes使用这些值来唯一确定集群中的节点。 如果这些值在每个节点上不唯一,可能会导致安装失败。(4)检查网络节点是否互通

简而言之,就是检查你的k8s集群各节点是否互通,可以使用ping命令来测试。(5)允许iptable检查桥接流量

cat <<EOF | tee /etc/modules-load.d/k8s.conf

br_netfilter

EOFcat <<EOF | tee /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system(6)检查端口是否被占用

参考链接: https://kubernetes.io/zh/docs/reference/ports-and-protocols/(7)检查docker的环境

参考链接: https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG/CHANGELOG-1.15.md#unchanged7.1 配置docker源

curl -o /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo

curl -o /etc/yum.repos.d/docker-ce.repo https://download.docker.com/linux/centos/docker-ce.repo

sed -i 's+download.docker.com+mirrors.tuna.tsinghua.edu.cn/docker-ce+' /etc/yum.repos.d/docker-ce.repo

yum list docker-ce --showduplicates7.2 安装指定的docker版本

yum -y install docker-ce-20.10.24 docker-ce-cli-20.10.24

yum -y install bash-completion

source /usr/share/bash-completion/bash_completion7.3 配置docker优化

cat > /etc/docker/daemon.json <<EOF

{"exec-opts": ["native.cgroupdriver=systemd"],"registry-mirrors": ["https://docker.1panel.live"]

}

EOF

7.4 将harbor服务器的客户端证书拷贝到k8s集群 *****7.4.1 k8s所有节点创建自建证书目录

mkdir -pv /etc/docker/certs.d/harbor.tom.com7.4.2 登录harbor服务器将自建证书拷贝到K8S集群的所有节点

[root@harbor ~]# scp /app/tools/harbor/certs/client/* root@10.0.0.231:/etc/docker/certs.d/harbor.tom.com

[root@harbor ~]# scp /app/tools/harbor/certs/client/* root@10.0.0.232:/etc/docker/certs.d/harbor.tom.com

[root@harbor ~]# scp /app/tools/harbor/certs/client/* root@10.0.0.233:/etc/docker/certs.d/harbor.tom.com7.5 配置docker开机自启动

systemctl enable --now docker

systemctl status docker(8)禁用防火墙

systemctl disable --now firewalld(9)禁用selinux

sed -i 's/^SELINUX=enforcing$/SELINUX=disabled/' /etc/selinux/config

grep ^SELINUX= /etc/selinux/config(10)配置host解析

cat >> /etc/hosts <<'EOF'

10.0.0.231 k8s231.tom.com

10.0.0.232 k8s232.tom.com

10.0.0.233 k8s233.tom.com

10.0.0.81 harbor.tom.com

EOF

cat /etc/hosts(11)验证是否能够登录harbor仓库

[root@k8s231 ~]# docker login -u admin -padmin harbor.tom.com

5.2. k8s所有节点安装kubeadm,kubelet,kubectl

- 所有节点安装kubeadm,kubelet,kubectl(1)配置软件源

cat > /etc/yum.repos.d/kubernetes.repo <<EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=0

repo_gpgcheck=0

EOF(2)查看kubeadm的版本(将来你要安装的K8S时请所有组件版本均保持一致!)

yum -y list kubeadm --showduplicates | sort -r(3)安装kubeadm,kubelet,kubectl软件包

yum -y install kubeadm-1.23.17-0 kubelet-1.23.17-0 kubectl-1.23.17-0(4)启动kubelet服务(若服务启动失败时正常现象,其会自动重启,因为缺失配置文件,初始化集群后恢复!此步骤可跳过!)

systemctl enable --now kubelet

systemctl status kubelet(5)添加kubectl的自动补全功能

echo "source <(kubectl completion bash)" >> ~/.bashrc && source ~/.bashrc

参考链接: https://kubernetes.io/zh/docs/tasks/tools/install-kubectl-linux/5.3. master节点(k8s231)-集群初始化control plane

- 初始化control plan节点(k8s231)(1)使用kubeadm初始化master节点

[root@k8s231 ~]# kubeadm init --kubernetes-version=v1.23.17 \

--image-repository registry.aliyuncs.com/google_containers \

--service-cidr=10.100.0.0/16 \

--pod-network-cidr=10.200.0.0/16 \

--service-dns-domain=tom.com相关参数说明:--kubernetes-version:指定K8S master组件的版本号。--image-repository:指定下载k8s master组件的镜像仓库地址。--pod-network-cidr:指定Pod的网段地址。--service-cidr:指定SVC的网段--service-dns-domain:指定service的域名。若不指定,默认为"cluster.local"。使用kubeadm初始化集群时,可能会出现如下的输出信息:

[init] 使用初始化的K8S版本。[preflight] 主要是做安装K8S集群的前置工作,比如下载镜像,这个时间取决于你的网速。[certs] 生成证书文件,默认存储在"/etc/kubernetes/pki"目录哟。[kubeconfig]生成K8S集群的默认配置文件,默认存储在"/etc/kubernetes"目录哟。[kubelet-start] 启动kubelet,环境变量默认写入:"/var/lib/kubelet/kubeadm-flags.env"配置文件默认写入:"/var/lib/kubelet/config.yaml"[control-plane]使用静态的目录,默认的资源清单存放在:"/etc/kubernetes/manifests"。此过程会创建静态Pod,包括"kube-apiserver","kube-controller-manager"和"kube-scheduler"[etcd] 创建etcd的静态Pod,默认的资源清单存放在:""/etc/kubernetes/manifests"[wait-control-plane] 等待kubelet从资源清单目录"/etc/kubernetes/manifests"启动静态Pod。[apiclient]等待所有的master组件正常运行。[upload-config] 创建名为"kubeadm-config"的ConfigMap在"kube-system"名称空间中。[kubelet] 创建名为"kubelet-config-1.22"的ConfigMap在"kube-system"名称空间中,其中包含集群中kubelet的配置[upload-certs] 跳过此节点,详情请参考”--upload-certs"[mark-control-plane]标记控制面板,包括打标签和污点,目的是为了标记master节点。[bootstrap-token] 创建token口令,例如:"kbkgsa.fc97518diw8bdqid"。如下图所示,这个口令将来在加入集群节点时很有用,而且对于RBAC控制也很有用处哟。[kubelet-finalize] 更新kubelet的证书文件信息[addons] 添加附加组件,例如:"CoreDNS"和"kube-proxy”(2)拷贝授权文件,用于管理K8S集群

[root@k8s231 ~]# mkdir -p $HOME/.kube

[root@k8s231 ~]# sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

[root@k8s231 ~]# sudo chown $(id -u):$(id -g) $HOME/.kube/config (3)查看集群节点

[root@k8s231 ~]# kubectl get componentstatuses

[root@k8s231 ~]# kubectl get cs5.4. worker节点(k8s232,k8s233)加入集群

- 配置所有worker节点加入k8s集群(1)所有节点加入K8S集群(命令来自主节点初始化结果最后一行,需要复制新生成的)

[root@k8s232 ~]# kubeadm join 10.0.0.231:6443 --token yd1dlg.yxadkryuok54wafx \

--discovery-token-ca-cert-hash sha256:0126bdf649181b08b57e12ecfb3310ba570368ac51bcf5062b9391d279059c77[root@k8s233 ~]# kubeadm join 10.0.0.231:6443 --token yd1dlg.yxadkryuok54wafx \

--discovery-token-ca-cert-hash sha256:0126bdf649181b08b57e12ecfb3310ba570368ac51bcf5062b9391d279059c77(2)查看现有的节点

[root@k8s231 ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8s231.tom.com NotReady control-plane,master 4m24s v1.23.17

k8s232.tom.com NotReady <none> 2m52s v1.23.17

k8s233.tom.com NotReady <none> 37s v1.23.175.5. master节点(k8s231)安装CNI网络插件flannel

- 安装网络插件并验证连通性(1)下载flannel的资源清单

[root@k8s231 ~]# wget https://github.com/flannel-io/flannel/releases/latest/download/kube-flannel.yml(2)安装flanne(podCIDR如果不是10.244.0.0/16,需要修改配置文件)

[root@k8s231 ~]# grep "\bNetwork" kube-flannel.yml"Network": "10.200.0.0/16",

[root@k8s231 ~]# kubectl apply -f kube-flannel.yml (3)检查flannel组件是否正常,均处于"Running"状态!

[root@k8s231 ~]# kubectl get pods -A -o wide| grep kube-flannel

kube-flannel kube-flannel-ds-c94t8 1/1 Running 0 16s 10.0.0.233 k8s233.tom.com <none> <none>

kube-flannel kube-flannel-ds-kzxs7 1/1 Running 0 16s 10.0.0.231 k8s231.tom.com <none> <none>

kube-flannel kube-flannel-ds-zjbhz 1/1 Running 0 16s 10.0.0.232 k8s232.tom.com <none> <none>---------------编写ds资源清单,测试跨节点Pod之间的通信------------

(4)编写ds资源清单

[root@k8s231 ~]# cat > test-ds.yaml <<EOF

kind: DaemonSet

apiVersion: apps/v1

metadata:name: test-ds

spec:selector:matchLabels:class: testtemplate:metadata:labels:class: testspec:containers:- image: alpinestdin: truename: c1

EOF(5)创建ds资源

[root@k8s231 ~]# kubectl apply -f test-ds.yaml

daemonset.apps/test-ds created[root@k8s231 ~]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

test-ds-6l8dc 1/1 Running 0 20s 10.200.1.2 k8s232.tom.com <none> <none>

test-ds-vlbtf 1/1 Running 0 20s 10.200.2.2 k8s233.tom.com <none> <none>(6)测试跨节点Pod之间的通信

[root@k8s231 ~]# kubectl exec test-ds-6l8dc -- ping -c 3 10.200.2.2

PING 10.200.2.2 (10.200.2.2): 56 data bytes

64 bytes from 10.200.2.2: seq=0 ttl=62 time=1.087 ms

64 bytes from 10.200.2.2: seq=1 ttl=62 time=0.762 ms

64 bytes from 10.200.2.2: seq=2 ttl=62 time=1.028 ms--- 10.200.2.2 ping statistics ---

3 packets transmitted, 3 packets received, 0% packet loss

round-trip min/avg/max = 0.762/0.959/1.087 ms(7)删除ds资源

[root@k8s231 ~]# kubectl delete -f test-ds.yaml

daemonset.apps "test-ds" deleted6. pod资源

6.1. 资源清单的创建,查看,删除,修改

K8S资源清单apiVersion:指的是Api的版本。kind:资源的类型。metadata:资源的元数据。比如资源的名称,标签,名称空间,注解等信息。spec:用户期望资源的运行状态。staus:资源实际的运行状态,由K8S集群内部维护。实战案例:

#获取pod书写用法指导

kubectl explain pod (1)创建工作目录

[root@k8s231 ~]# mkdir -pv /manifests/pods/ && cd /manifests/pods/(2)编写资源清单

[root@k8s231 pods]# cat > 01-nginx.yaml <<EOF

# 指定API的版本号

apiVersion: v1

# 指定资源的类型

kind: Pod

# 指定元数据

metadata:# 指定名称name: 01-nginx

# 用户期望的资源状态

spec:# 定义容器资源containers:# 指定的名称- name: nginx# 指定容器的镜像image: nginx:1.14.2

EOF(3)创建资源清单

[root@k8s231 pods]# kubectl create -f 01-nginx.yaml

pod/web created(4)查看资源

[root@k8s231 pods]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

01-web 1/1 Running 0 9s 10.200.1.3 k8s232.tom.com <none> <nonekubectl get pods -o wide相关字段说明:NAME 代表的是资源的名称。READY 代表资源是否就绪。比如 0/1 ,表示一个Pod内有一个容器,而且这个容器还未运行成功。STATUS 代表容器的运行状态。RESTARTS 代表Pod重启次数,即容器被创建的次数。AGE 代表Pod资源运行的时间。IP 代表Pod的IP地址。NODE 代表Pod被调度到哪个节点。其他: "NOMINATED NODE和"READINESS GATES"暂时先忽略哈。[root@k8s231 pods]# ]# curl -I 10.200.1.3

HTTP/1.1 200 OK

Server: nginx/1.14.2

Date: Sat, 03 Aug 2024 05:22:26 GMT

Content-Type: text/html

Content-Length: 612

Last-Modified: Tue, 04 Dec 2018 14:44:49 GMT

Connection: keep-alive

ETag: "5c0692e1-264"

Accept-Ranges: bytes (5)删除资源

[root@k8s231 pods]# kubectl delete -f 01-nginx.yaml

pod "web" deleted

-----------------------------------------------------------------------

K8S的Pod资源运行多个容器案例(1)编写资源清单

[root@k8s231 pods]# cat > 02-nginx-tomcat.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: 02-nginx-tomcat

spec:containers:- name: nginximage: nginx:1.23.4-alpine- name: tomcatimage: tomcat:jre8-alpine

EOF(2)创建资源清单

[root@k8s231 pods]# kubectl create -f 02-nginx-tomcat.yaml(3)查看Pod状态

]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

02-nginx-tomcat 2/2 Running 0 65s 10.200.2.3 k8s233.tom.com <none> <none>#显示pod详细信息

[root@k8s231 pods]# kubectl describe pod 02-nginx-tomcat (4)删除Pod

[root@k8s231 pods]# kubectl delete pod 02-nginx-tomcat

pod "02-nginx-tomcat" deleted--------------------------------------------------------------------------

故障排查方法:1.加入一条命令hold住容器,然后连接容器,运行容器内服务看报错(1)资源清单

[root@k8s231 pods]# cat > 03-nginx-alpine.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: 03-nginx-alpine

spec:# 使用宿主机网络,相当于"docker run --network host"hostNetwork: truecontainers:- name: nginximage: nginx:1.23.4-alpine- name: linuximage: alpine# 给容器分配一个标准输入,默认值为false# stdin: true# 给容器分配一个启动命令,修改Dockerfile的CMD指令# args: ["tail","-f","/etc/hosts"]# 也可以修改command字段,相当于修改Dockerfile的ENTRYPOINT指令# command: ["sleep","15"]# args也可以和command命令搭配使用,和Dockfile的ENTRYPOINT和CMD效果类似command:- "tail"args:- "-f"- "/etc/hosts"

EOF(2)创建Pod

[root@k8s231 pods]# kubectl apply -f 03-nginx-alpine.yaml

pod/nginx-alpine created----------------------------------

#把项目推送到私人harbor仓库,然后从私人仓库创建资源清单

(1)把项目推送到私人仓库

docker tag ilemonrain/h5ai:full harbor.tom.com/library/h5ai:v1

docker push harbor.tom.com/library/h5ai:v1(2)资源清单

[root@k8s231 pods]# cat > 04-h5ai.yaml <<EOF

apiVersion: v1

kind: Pod

metadata: name: 04-h5ai

spec:# 将Pod调度到指定节点,注意,该node名称必须和etcd的数据保持一致nodeName: k8s232.tom.comhostNetwork: truecontainers:- name: h5ai image: harbor.tom.com/library/h5ai:v1 volumeMounts:- name: my-volumemountPath: /h5aivolumes:- name: my-volumehostPath:path: /pantype: DirectoryOrCreate

EOF(3)创建Pod

[root@k8s231 pods]# kubectl apply -f 04-h5ai.yaml

[root@k8s231 pods]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

04-h5ai 1/1 Running 0 13s 10.0.0.232 k8s232.tom.com <none> <none>(4)访问测试windows访问10.0.0.232,可以看到文件清单6.2. 排查pod故障常用命令:

常用命令:(1)pod中容器和宿主机之间拷贝文件(cp)

[root@k8s231 pods]# kubectl get pods

NAME READY STATUS RESTARTS AGE

game-008 1/1 Running 0 4m15s

#将Pod的的文件拷贝到宿主机

[root@k8s231 pods]# kubectl cp game-008:/start.sh /tmp/1.sh

#将Pod的的目录拷贝到宿主机

[root@k8s231 pods]# kubectl cp game-008:/etc /tmp/2222#将宿主机的文件拷贝到Pod的容器中

[root@k8s231 pods]# kubectl cp 01-nginx.yaml game-008:/

#将宿主机的目录拷贝到Pod的容器中

[root@k8s231 pods]# kubectl cp /tmp/2222/ game-008:/(2)连接到Pod的容器(exec)

[root@k8s231 pods]# kubectl get pods

NAME READY STATUS RESTARTS AGE

nginx-tomcat 2/2 Running 0 63s#查看pod中的容器名称方式,查看清单文件中containers字段中的name字段

[root@k8s231 pods]# cat 02-nginx-tomcat.yaml

apiVersion: v1

kind: Pod

metadata:name: 02-nginx-tomcat

spec:containers:- name: nginximage: nginx:1.23.4-alpine- name: tomcatimage: tomcat:jre8-alpine[root@k8s231 pods]# kubectl exec -it 02-nginx-tomcat -- sh # 默认连接到第一个容器

[root@k8s231 pods]# kubectl exec -it 02-nginx-tomcat -c nginx -- sh # 连接nginx容器

[root@k8s231 pods]# kubectl exec -it 02-nginx-tomcat -c tomcat -- sh # 连接tomcat容器(3)查看Pod的日志(logs)

#使用"kubectl logs"查看的是容器的标准输出或错误输出日志,

#如果想要使用该方式查看,需要将日志重定向到/dev/stdout或者/dev/stderr。

#查看nginx容器的全部日志

[root@k8s231 pods]# kubectl logs 02-nginx-tomcat -c nginx

#查看nginx容器的1小时内日志

[root@k8s231 pods]# kubectl logs 02-nginx-tomcat -c nginx --since=1h

#查看nginx容器的从某个时间点之后的日志

[root@k8s231 pods]# kubectl logs 02-nginx-tomcat -c nginx --since-time="2023-12-22T02:00:00+00:00"

#查看nginx容器上一个挂掉的容器的日志 -p

[root@k8s231 pods]# kubectl logs 02-nginx-tomcat -c nginx -p6.3. 镜像下载策略,pod容器重启策略

一.镜像下载策略:

spec:containers:- name: nginximage: harbor.tom.com/web/web:v0.1 imagePullPolicy: Always|IfNotPresent|Never

# Always: 默认值,表示始终拉取最新的镜像。

# IfNotPresent: 如果本地有镜像,则不去远程仓库拉取镜像,若本地没有,才会去远程仓库拉取镜像。

# Never: 如果本地有镜像则尝试启动,若本地没有镜像,也不会去远程仓库拉取镜像。二. Pod中容器重启策略:(K8S所谓的重启指的是重新创建容器)

spec:restartPolicy: Always|OnFailure|Never

# Always: 当容器退出时,始终重启。

# OnFailure: 当容器正常退出时不会重启容器,异常退出时,会重启容器。

# Never: 当容器退出时,始终不重启。6.4. 向容器传递环境变量的方式

向容器传递环境变量的两种方式:

[root@k8s231 pods]# cat > 05-nginx-env.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: 05-nginx-env

spec:nodeName: k8s232.tom.comcontainers:- name: nginximage: nginx:alpine# 向容器传递环境变量env:

#方式1: 使用自定义的变量值# 指定的变量名称- name: SCHOOL# 指定变量的值value: "qinghua"- name: CLASSvalue: "104"#方式2:不适用自定义的变量值,而是引用别处的值- name: PODN-AME valueFrom:# 值引用自某个字段fieldRef:# 指定字段的路径 fieldPath: "metadata.name"- name: NODE-NAMEvalueFrom:fieldRef:fieldPath: "spec.nodeName"- name: HOST-IPvalueFrom:fieldRef:fieldPath: "status.hostIP"- name: POD-IPvalueFrom:fieldRef:fieldPath: "status.podIP"

EOF

[root@k8s231 pods]# kubectl apply -f 05-nginx-env.yaml [root@k8s231 pods]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

05-nginx-env 1/1 Running 0 8s 10.200.1.6 k8s232.tom.com <none> <none>[root@k8s231 pods]# kubectl exec 05-nginx-env -- env

PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin

HOSTNAME=05-nginx-env

POD-IP=10.200.1.6

SCHOOL=qinghua

CLASS=104

PODN-AME=05-nginx-env

NODE-NAME=k8s232.tom.com

HOST-IP=10.0.0.2327. volume资源

存储的资源,包括volumes和persistent volume(pv)(后面的章节讲解)

Volume可以提供多种类型的资源存储(可持久或不持久),但是它定义在Pod上的,是属于"资源对象"的一部分

7.1. k8s支持的volumes类型:

使用kubectl explain pod.spec.volumes 查看k8s支持的存储类型

volume常用类型:

- emptyDir: (临时目录)Pod删除,数据也会被清除,用于数据的临时存储,只能单个pod内部容器共享数据。

- hostPath: (宿主机目录映射)

- 本地的SAN (iSCSI,FC)、NAS(nfs,cifs,http)存储

- 分布式存储(glusterfs,rbd,cephfs)

- 云存储(EBS,Azure Disk)

k8s要使用存储卷,需要2步:

1)在pod定义volume,并指明使用哪个存储设备

2)在容器使用volume mount进行挂载

7.2. emptyDir类型volume: 同pod内容器共享数据

emptyDir volumes特点:

- emptyDir volume在某个节点上刚创建时,它的初始内容为空,并且无须指定宿主机上对应的目录文件,因为这是Kubernetes自动分配的一个目录。

- 同一pod中的容器都可以读写这个目录,这个目录可以被挂在到各个容器相同或者不相同的的路径下。

- 当一个pod因为任何原因被移除的时候,这些数据会被永久删除。

- 一个容器崩溃了不会导致数据的丢失,因为容器的崩溃并不移除pod.

emptyDir 磁盘的用途:

- 临时空间,例如用于某些应用程序运行时所需的临时目录,且无须永久保留。

- 长时间任务的中间过程CheckPoint的临时保存目录。

- 一个容器需要从另一个容器中获取数据的目录(多容器共享目录)

#数据持久化之emptyDir实战案例:

#我们在一个pod定义了2个容器,2个容器都挂载同一个emptyDir volume,2个容器挂载目录的数据是相同的

[root@k8s231 pods]# cat > pod-volumes-emptyDir.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: volume-emptydir

spec: volumes: - name: data01emptyDir: {} containers:- name: webimage: nginx:alpine volumeMounts: - name: data01 mountPath: /usr/share/nginx/html- name: busyboximage: busybox:latest volumeMounts:- name: data01mountPath: /datacommand: ['tail','-f','/etc/hosts']

EOF[root@k8s231 pods]# kubectl apply -f pod-volumes-emptyDir.yaml

[root@k8s231 pods]# kubectl get pod -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

volume-emptydir 2/2 Running 0 13s 10.200.1.64 k8s232.tom.com <none> <none>[root@k8s231 pods]# kubectl exec -it volume-emptydir -c busybox -- sh -c "echo 1 > /data/index.html"

[root@k8s231 pods]# curl 10.200.1.64

1

[root@k8s231 pods]# kubectl exec -it volume-emptydir -c busybox -- sh -c "echo 2 > /data/index.html"

[root@k8s231 pods]# curl 10.200.1.64

2[root@k8s232 ~]# docker ps|awk -F'_' '/busybox/{print $(NF-1)}'

ad63d319-3809-4468-8c5d-f5b6765594a6

[root@k8s232 ~]# tree /var/lib/kubelet/pods/ad63d319-3809-4468-8c5d-f5b6765594a6/volumes/kubernetes.io~empty-dir/

/var/lib/kubelet/pods/ee925cb5-a35a-40ad-a434-c36423549e60/volumes/kubernetes.io~empty-dir/

└── data01└── index.html7.3. hostPath类型volume:同节点的不同POD共享数据

hostPath volumes特点:

- hostPath volume只能为同一个node节点上不同pod提供数据共享服务(不同pod使用hostPath的时候需要指定相同的node节点)

- 容器被删除,或者pod被删除,数据不会丢失

- node节点故障则会导致数据丢失

数据持久化之hostPath实战案例:

[root@k8s231 pods]# cat > volumes-hostPath.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: volume-hostpath

spec:nodeName: k8s232.tom.comvolumes:- name: data01# 指定类型为宿主机存储卷,该存储卷只要用于容器访问宿主机路径的需求。 hostPath:# 指定存储卷的路径path: /k8s/volume/hostpathcontainers:- name: webimage: nginx:alpinevolumeMounts:- name: data01mountPath: /usr/share/nginx/html

---

apiVersion: v1

kind: Pod

metadata:name: volume-hostpath-002

spec:nodeName: k8s232.tom.comvolumes:- name: data01hostPath:path: /k8s/volume/hostpathcontainers:- name: linuximage: nginx:1.20.1-alpinestdin: truevolumeMounts:- name: data01mountPath: /data-test

EOF7.4. nfs类型volume:可以在不同节点的不同POD共享数据

nfs环境准备

- 部署nfs server(1)所有节点安装nfs相关软件包

yum -y install nfs-utils(2)k8s231节点设置共享目录

mkdir -p /k8s/volume/

cat > /etc/exports <<'EOF'

/k8s/volume/ *(rw,no_root_squash)

EOF(3)k8s231节点配置nfs服务开机自启动

systemctl enable --now nfs(4)服务端检查NFS挂载信息

exportfs(5)客户端节点手动挂载测试

mount -t nfs k8s231.tom.com:/k8s/volume/ /mnt/

umount /mnt

----------------------------------------------------

- 数据持久化之nfs实战案例

[root@k8s231 pods]# cat > volumes-nfs.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: volume-nfs-web

spec:nodeName: k8s232.tom.comvolumes:- name: data# 指定存储卷类型是nfsnfs:# 指定nfs服务器的地址server: 10.0.0.231# 指定nfs对外暴露的挂载路径path: /k8s/volume/nfscontainers:- name: webimage: nginx:1.20.1-alpinevolumeMounts:- name: datamountPath: /usr/share/nginx/html

---apiVersion: v1

kind: Pod

metadata:name: volume-nfs-linux

spec:nodeName: k8s233.tom.comvolumes:- name: datanfs:server: 10.0.0.231path: /k8s/volume/nfscontainers:- name: linuximage: alpine:lateststdin: truevolumeMounts:- name: datamountPath: /tom-data

EOF7.5. volumeMounts[*].subPath

7.5.1. 目的1:同pod内多容器挂载同一个volume,但是有每个容器自己的目录

有时候,在单个 Pod 中多个container使用同一个volume。 volumeMounts.subPath 属性可用于指定所引用的卷内的子路径,而不是其根路径。

[root@k8s231 pods]# cat > volumemounts-subpath.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: volumemounts-subpath-pod

spec:nodeName: k8s232.tom.comvolumes:- name: data hostPath: path: /k8s/volume/hostpathcontainers:- name: webimage: nginx:alpinevolumeMounts:- name: datamountPath: /usr/share/nginx/htmlsubPath: html- name: busyboximage: busybox:lateststdin: truevolumeMounts:- name: datamountPath: /datasubPath: log

EOF

#232上创建共享目录

[root@k8s232 ~]# mkdir -p /k8s/volume/hostpath

[root@k8s231 ~]# kubectl apply -f volumemounts-subpath.yaml

[root@k8s231 pods]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

volumemounts-subpath-pod 2/2 Running 0 10s 10.200.1.76 k8s232.tom.com <none> <none>[root@k8s232 ~]# tree /k8s/volume/hostpath

/k8s/volume/hostpath

├── html

└── log7.5.2. 目的2:将 config/secret 作为文件挂载到容器中的某个目录下,而不覆盖挂载目录下的文件

[root@k8s231 pods]# cat > configmap-subpath-pod.yaml <<EOF

apiVersion: v1

kind: ConfigMap

metadata:name: configmap-subpath

data:config.ini: "hello"config.conf: "world"

---

apiVersion: v1

kind: Pod

metadata:name: pod-configmap-subpath

spec:containers:- name: testimage: busyboxcommand: ["/bin/sh","-c","sleep 3600s"]volumeMounts:- name: vm-testmountPath: /etc/config.ini # 最终在容器中的文件名subPath: config.ini #要挂载的confmap中的key的名称- name: vm-testmountPath: /etc/config.conf subPath: config.conf volumes:- name: vm-testconfigMap:name: configmap-subpath

EOF[root@k8s231 pods]# kubectl apply -f configmap-subpath-pod.yaml

configmap/configmap-subpath-pod created

pod/configmap-subpath created[root@k8s231 pods]# kubectl get pod -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

pod-configmap-subpath 1/1 Running 0 33s 10.200.1.77 k8s232.tom.com <none> <none>[root@k8s231 pods]# kubectl exec pod-configmap-subpath -- sh -c "cat -n /etc/config.ini;cat -n /etc/config.conf;"1 hello1 world8. port端口映射

prots的端口映射案例

[root@k8s231 configMap]# cat > web-port.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: web-port

spec:nodeName: k8s232.tom.comcontainers:- name: webimage: nginx:alpine# 指定容器的端口映射相关字段ports:# 指定容器的端口号- containerPort: 80# 绑定主机的IP地址hostIP: "0.0.0.0"# 指定绑定的端口号hostPort: 88# 给该端口起一个别名,要求唯一name: game# 指定容器的协议protocol: TCP

9. 容器资源请求,资源限制

requests 表示创建pod时预留的资源,limits 表示pod 能够使用资源的最大值;

requests 值可以被超过,limits 值不能超过;

如果是内存使用超过limits 会触发oom 然后杀掉进程,如果是 cpu 超过limits 则会压缩cpu 的使用率

容器的资源限制实战案例:

[root@k8s231 pods]# cat > 12-requests.yaml <<EIF

apiVersion: v1

kind: Pod

metadata:name: pod-requests

spec:nodeName: k8s233.tom.comcontainers:- name: pod-requestsimage: nginx:alpine# 对容器进行资源限制resources:# 期望目标节点有的资源大小,若不满足,则无法调度,Pod处于Pedding状态。# 若满足调度需求,调度到节点后也不会立刻使用requests字段的定义的资源。requests:# 要求目标节点有256M内存memory: 256M# 指定CPU的核心数,固定单位: 1core=1000mcpu: 500m# 配置资源的使用上限limits:memory: 500Mcpu: 1.5

EOF10. configMap资源

k8s可以使用ConfigMap来实现对容器中应用的配置进行管理(应用的conf文件内容写到cm里)。

可以把ConfigMap看作是一个挂载到pod中的存储卷

推荐阅读:

Volumes | Kubernetes

ConfigMaps | Kubernetes

10.1. 创建configMap

创建configmap,支持的数据类型: (1)键值对; (2)多行数据;

[root@k8s231 configMap]# cat > configmap-01.yaml <<EOF

apiVersion: v1

kind: ConfigMap

metadata:name: cm-01

# 定义cm资源的数据

data:# 键值对name: tomage: "18"# 定义多行数据my.cfg: |datadir: "/var/lib/mysql"basedir: "/usr/share/mysql"socket: "/tmp/mysql.sock"

EOF[root@k8s231 pods]# kubectl apply -f configmap-01.yaml

configmap/cm-01 created

]# kubectl get cm cm-01

NAME DATA AGE

cm-01 3 2m41s

[root@k8s231 pods]# kubectl describe cm cm-01

Name: cm-01

Namespace: default

Labels: <none>

Annotations: <none>Data

====

age:

----

18

my.cfg:

----

datadir: "/var/lib/mysql"

basedir: "/usr/share/mysql"

socket: "/tmp/mysql.sock"name:

----

tomBinaryData

====Events: <none>10.2. Pod引用configmap资源的两种常见的方式

10.2.1. 方式1-pod基于env环境变量引入cm资源:

pod基于env环境变量引入cm资源:

[root@k8s231 configMap]# cat > pod-configmap-env.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: pod-cm-env

spec:nodeName: k8s232.tom.comcontainers:- name: gameimage: nginx:alpineenv:- name: env_cm_agevalueFrom:# 指定引用的configMap资源configMapKeyRef:# 指定configMap的名称name: cm-01# 指定configMap的KEYkey: age- name: env_cm_mycfgvalueFrom:configMapKeyRef:name: cm-01key: my.cfg

EOF[root@k8s231 pods]# kubectl apply -f pod-configmap-env.yaml

pod/pod-cm-env created[root@k8s231 pods]# kubectl get pods

NAME READY STATUS RESTARTS AGE

pod-cm-env 1/1 Running 0 4s[root@k8s231 pods]# kubectl exec pod-cm-env -- env

PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin

HOSTNAME=pod-cm-env

env_cm_age=18

env_cm_mycfg=datadir: "/var/lib/mysql"

basedir: "/usr/share/mysql"

socket: "/tmp/mysql.sock"10.2.2. 方式2-pod基于存储卷的方式引入cm资源

在Kubernetes中,要挂载nginx.conf配置文件到Nginx Pod中,你可以使用ConfigMap来管理配置文件,并将其作为卷挂载到Pod中。

10.2.2.1. 挂载nginx配置方式1:把nginx配置文件写在configmap的文件里,然后再用到挂载

1.创建一个名为nginx-configmap.yaml的ConfigMap文件:

cat > nginx-configmap.yaml <<EOF

apiVersion: v1

kind: ConfigMap

metadata:name: nginx-configmap

data:nginx.conf: |-user nginx;worker_processes 1;error_log /var/log/nginx/error.log warn;pid /var/run/nginx.pid;events {worker_connections 1024;}http {include /etc/nginx/mime.types;default_type application/octet-stream;server{listen 80;server_name _;root /usr/share/nginx/html; }}

EOF2.应用ConfigMap到Kubernetes集群:

kubectl apply -f nginx-configmap.yaml3.创建Pod(nginx-pod.yaml)并挂载ConfigMap作为卷:

cat > nginx-pod.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: nginx-pod

spec:containers:- name: nginximage: nginx:latestvolumeMounts:- name: config-volumemountPath: /etc/nginx/nginx.conf#不加subPath时,默认挂载的是文件夹,#加subPath时,且subPath的值和configMap.items.path相同时,mountPath的挂载点是一个文件而非目录!subPath: nginx.confvolumes:- name: config-volume# 指定存储卷的类型为configMapconfigMap:# 指定configMap的名称name: nginx-configmap# 不加items,就是全部引入,加上是引用configMap的特定keyitems:- key: nginx.conf# 可以暂时理解为指定文件的名称path: nginx.conf

EOF4.应用Pod定义到Kubernetes集群:

kubectl apply -f nginx-pod.yaml10.2.2.2. 挂载nginx配置方式2: 把nginx配置文件加载为configmap,然后再用到挂载

| 1 | 创建Nginx配置文件 |

| 2 | 创建ConfigMap对象 |

| 3 | 创建Deployment对象 |

| 4 | 挂载ConfigMap到Deployment中 |

(1)创建Nginx配置文件

[root@k8s231 pods]# cat > server01.conf <<EOF

server {listen 80;server_name _;location / {root /usr/share/nginx/html;index index.html;}

}

EOF

(2)创建ConfigMap对象

在K8S中,可以使用ConfigMap对象来存储配置信息。

我们可以通过以下命令将Nginx配置文件创建为一个ConfigMap对象

#可以一次性储存多个文件为配置信息

#kubectl create configmap nginx-config --from-file=key1=/path/to/bar/file1.txt --from-file=key2=/path/to/bar/file2.txt

#可以把文件夹作为参数,会递归把文件夹下面的文件储存为配置信息

#kubectl create configmap nginx-config --from-file=nginx-conf.dkubectl create configmap nginx-config --from-file=server01.conf(3)创建pod资源清单

cat > nginx-pod-cm-from-file.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: nginx-pod-cm-from-file

spec:containers:- name: nginximage: nginx:latestvolumeMounts:- name: config-volumemountPath: /etc/nginx/conf.d/volumes:- name: config-volume# 指定存储卷的类型为configMapconfigMap:# 指定configMap的名称name: nginx-config

EOF(4)创建pod

kubectl apply -f nginx-pod-cm-from-file.yaml(5)验证

]# kubectl exec nginx-pod-cm-from-file -- cat /etc/nginx/conf.d/server01.conf

server {listen 80;server_name _;location / {root /usr/share/nginx/html;index index.html;}

}11. secret资源

Kubernetes 中的 Secret 对象用来保存敏感信息,例如密码、OAuth 令牌和 ssh 密钥等。Secret 的数据可以是任何二进制数据,但最常见的是用来保存文本数据。

Kubernetes 支持以下几种数据类型 Secret:

Opaque: 默认的 Secret 类型。使用base64编码存储信息,可通过base64 --decode解码获得原始数据,因此安全性弱。kubernetes.io/service-account-token: 这种类型的 Secret 由 Kubernetes 自动创建,并且挂载到 Pod 中的 Service Account 里。kubernetes.io/dockerconfigjson: 用于保存 Docker 登录的认证信息,例如用户名和密码。kubernetes.io/ssh-auth: 用于保存 SSH 密钥。kubernetes.io/tls: 用于保存 TLS 证书和私钥。

11.1. 创建secret

11.1.1. 创建Opaque类型的secret

Opaque类型的secret资源的增删改查实战:(1)编写secret资源

#对用户名密码进行base64编码,下面编写secret清单会用到

[root@k8s231 ~]# echo tom |base64

dG9tCg==

[root@k8s231 ~]# echo 123456 |base64

MTIzNDU2Cg==[root@k8s231 secret]# cat > opaque-secret.yaml <<EOF

apiVersion: v1

kind: Secret

metadata:name: opaque-secret

data:username: dG9tCg==password: MTIzNDU2Cg==

EOF(2)创建secret资源

[root@k8s231 secret]# kubectl apply -f opaque-secret.yaml(3)查询secret资源

[root@k8s231 secret]# ]# kubectl get secrets opaque-secret

NAME TYPE DATA AGE

opaque-secret Opaque 2 13s[root@k8s231 secret]# kubectl describe secrets opaque-secret

Name: opaque-secret

Namespace: default

Labels: <none>

Annotations: <none>

Type: Opaque

Data

====

password: 7 bytes

username: 4 bytes(4)删除secret资源

[root@k8s231 secret]# kubectl delete -f opaque-secret.yaml11.1.2. 创建 kubernetes.io/dockerconfigjson类型的secret

#得确保harbor仓库存在此用户,且项目对此用户开放

kubectl create secret docker-registry docker-secret \--docker-email=tom@qq.com \--docker-username=tom \--docker-password=Tom123456 \--docker-server=harbor.tom.com[root@k8s231 secret]# kubectl get secrets docker-secret

NAME TYPE DATA AGE

docker-secret kubernetes.io/dockerconfigjson 1 11s11.2. pod引用secret的方式

11.2.1. opaque secret引用方式

11.2.1.1. 方式1-pod基于env环境变量引入secret资源:

#使用方式可参考

kubectl explain po.spec.containers.env.valueFrom.secretKeyRefPod基于env引用opaque secret资源案例:

[root@k8s231 secret]# cat > pod-env-opaque-secret.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: pod-env-opaque-secret

spec:nodeName: k8s232.tom.comcontainers:- name: gameimage: nginx:alpine env: - name: env-opaque-secret-usernamevalueFrom:# 指定引用的secret资源secretKeyRef:# 指定secret的名称name: opaque-secret# 指定secret的KEYkey: username - name: env-opaque-secret-passwordvalueFrom:secretKeyRef:name: opaque-secretkey: password

EOF

]# kubectl apply -f pod-env-opaque-secret.yaml

]# kubectl exec pod-env-opaque-secret -- env

...

env-opaque-secret-username=tom

env-opaque-secret-password=123456

....11.2.1.2. 方式2-pod基于存储卷的方式引入opaque secret资源

Pod基于env引用opaque secret资源案例:

[root@k8s231 secret]# cat > pod-volume-opaque-secret.yaml << EOF

apiVersion: v1

kind: Pod

metadata:name: pod-volume-opaque-secret

spec:volumes:- name: data# 指定存储卷的类型为secretsecret:# 指定secret的名称secretName: opaque-secretitems:- key: usernamepath: username.info- key: passwordpath: password.infocontainers:- name: gameimage: nginx:alpine volumeMounts:- name: data mountPath: /data/username.infosubPath: username.info- name: datamountPath: /data/password.infosubPath: password.info

EOF [root@k8s231 secret]# kubectl apply -f pod-volume-opaque-secret.yaml

[root@k8s231 secret]# kubectl exec pod-volume-opaque-secret -- cat /data/username.info /data/password.info

tom

12345611.2.2. pod引用dockercfg secret方式

#使用dockercfg secret 从harbor拉取镜像

[root@k8s231 secret]# cat > pod-dockercfg-secret.yaml << EOF

apiVersion: v1

kind: Pod

metadata:name: pod-dockercfg-secret

spec:imagePullSecrets:- name: docker-secretcontainers:- name: nginximage: harbor.tom.com/private-lib/nginx:alpine

EOF12. 标签管理

标签管理分响应式和声明式:

响应式:创建标签立即生效,但资源被重新创建时,标签可能会丢失哟~需要重新创建

声明式:需要将标签写入到资源清单,每次修改后需要重新应用资源的配置文件,否则不会生效。

12.1. 标签管理:响应式

(一)响应式进行标签管理(1)创建标签#指定给资源清单文件所对应的pod打标签

[root@k8s231 pods]# kubectl label -f web-labels.yaml version=v1#查看pod的标签

[root@k8s231 pods]# kubectl get pod 01-nginx --show-labels

NAME READY STATUS RESTARTS AGE LABELS

01-nginx 1/1 Running 0 82s version=v1#指定给pod打标签

[root@k8s231 pods]# kubectl label pod 01-nginx app=game#查看pod的标签

[root@k8s231 pods]# kubectl get pod 01-nginx --show-labels

NAME READY STATUS RESTARTS AGE LABELS

01-nginx 1/1 Running 0 82s app=game,version=v1(2)修改标签

[root@k8s231 pods]# kubectl label --overwrite pod 01-nginx version=v2

pod/01-nginx labeled#查看pod的标签

[root@k8s231 pods]# kubectl get pod 01-nginx --show-labels

NAME READY STATUS RESTARTS AGE LABELS

01-nginx 1/1 Running 0 2m57s app=game,version=v2(3)删除标签

[root@k8s231 pods]# kubectl label pod 01-nginx version-

pod/01-nginx unlabeled

[root@k8s231 pods]# kubectl get pod 01-nginx --show-labels

NAME READY STATUS RESTARTS AGE LABELS

01-nginx 1/1 Running 0 5m45s app=game

---------------------------------------------------------------------12.2. 标签管理:声明式

(二)基于声明式进行标签管理:(1)创建标签

[root@k8s231 pods]# cat 01-nginx.yaml

apiVersion: v1

kind: Pod

metadata:name: 01-nginxlabels:version: v3app: web

spec:containers:- name: nginximage: nginx:alpine

#应用配置

[root@k8s231 pods]# kubectl apply -f 01-nginx.yaml

#查看pod的标签

[root@k8s231 pods]# kubectl get pod --show-labels

NAME READY STATUS RESTARTS AGE LABELS

01-nginx 1/1 Running 0 7s app=web,version=v3(2)修改标签

#vim 修改 labels 里面的version: v4

[root@k8s231 pods]# sed -i 's#version: v3#version: v4#g' 01-nginx.yaml

#重新应用配置

[root@k8s231 pods]# kubectl apply -f 01-nginx.yaml#查看pod的标签

[root@k8s231 pods]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

01-nginx 1/1 Running 0 5m54s app=web,version=v412.3. 基于标签删除pod

基于标签删除Pod资源案例

[root@k8s231 pods]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

02-nginx-tomcat 2/2 Running 0 77s version=v1

03-nginx-alpine 2/2 Running 0 73s version=v2

[root@k8s231 pods]# kubectl delete pods -l version=v1

pod "02-nginx-tomcat" deleted

[root@k8s231 pods]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

03-nginx-alpine 2/2 Running 0 92s version=v212.4. 基于标签查看Pod

基于标签查看Pod

[root@k8s231 pods]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

01-nginx 1/1 Running 0 41s app=web,version=v4

02-nginx-tomcat 2/2 Running 0 2s <none>

03-nginx-alpine 2/2 Running 0 4m26s version=v2

[root@k8s231 pods]# kubectl get pods --show-labels -l version

NAME READY STATUS RESTARTS AGE LABELS

01-nginx 1/1 Running 0 65s app=web,version=v4

03-nginx-alpine 2/2 Running 0 4m50s version=v212.5. 基于标签管理cm资源

创建标签的方式也可以分为响应式和声明式。和标签管理不同的是命令中pod换成cm即可

#响应式创建cm资源

#响应式创建标签

kubectl label cm cm-01 v=0.1

#响应式修改标签

kubectl label cm cm-01 v=0.3 --overwrite#声明式创建cm资源

cat > configmap-01.yaml <<EOF

apiVersion: v1

kind: ConfigMap

metadata:name: cm-01labels:v: "0.1"

data:name: tomage: "18"

EOF

kubectl apply -f configmap-01.yaml#基于标签查看cm

]# kubectl get cm -l v --show-labels

NAME DATA AGE LABELS

cm-01 3 13m v=0.3

nginx-config 2 21h v=0.2#基于标签删除cm

[root@k8s231 pods]# kubectl delete cm -l v=0.3

configmap "cm-01" deleted

[root@k8s231 pods]# kubectl get cm -l v --show-labels

NAME DATA AGE LABELS

nginx-config 2 21h v=0.212.6. 查看nodes节点的标签

查看nodes节点的标签:

[root@k8s231 pods]# kubectl get nodes --show-labels

NAME STATUS ROLES AGE VERSION LABELS

k8s231.tom.com Ready control-plane,master 4d6h v1.23.17 beta.kubernetes.io/arch=amd64,beta.kubernetes.io/os=linux,kubernetes.io/arch=amd64,kubernetes.io/hostname=k8s231.tom.com,kubernetes.io/os=linux,node-role.kubernetes.io/control-plane=,node-role.kubernetes.io/master=,node.kubernetes.io/exclude-from-external-load-balancers=

k8s232.tom.com Ready <none> 4d6h v1.23.17 beta.kubernetes.io/arch=amd64,beta.kubernetes.io/os=linux,kubernetes.io/arch=amd64,kubernetes.io/hostname=k8s232.tom.com,kubernetes.io/os=linux

k8s233.tom.com Ready <none> 4d6h v1.23.17 beta.kubernetes.io/arch=amd64,beta.kubernetes.io/os=linux,kubernetes.io/arch=amd64,kubernetes.io/hostname=k8s233.tom.com,kubernetes.io/os=linux13. 名称空间(namespace)

在同一个名称空间下,同一种资源类型,是无法同时创建多个名称相同的资源。

名称空间是用来隔离K8S集群的资源。我们通常使用名称空间对企业业务进行逻辑上划分。

K8S集群一切皆资源,有的资源是不支持名称空间的,我们将其称为全局资源,而支持名称空间的资源我们称之为局部资源。

我们可以通过"kubectl api-resources"命令来判断一个资源是否支持名称空间。

温馨提示:(1)在同一个名称空间下,同一个资源类型是不能出现重名的;(2)在不同的名称空间下,相同的资源类型是能出现同名的;13.1. 名称空间的各种资源查看详解

#1.查看现象有的名称空间

[root@k8s231 pods]# ]# kubectl get namespaces

NAME STATUS AGE

default Active 4d9h

kube-flannel Active 4d8h

kube-node-lease Active 4d9h

kube-public Active 4d9h

kube-system Active 4d9h #2.查看默认名称空间的Pod资源

kubectl get pods -n default

kubectl get pods #3.查看指定的名称空间Pod资源

kubectl get pods -n kube-system

kubectl get pods --namespace kube-system#4.查看所有名称空间的Pod资源

kubectl get pods --all-namespaces

kubectl get pods -A#5.查看所有名称空间的cm资源

kubectl get cm -A#6.查看指定名称空间的cm资源

kubectl get cm -n kube-system13.2. 创建名称空间

- 创建名称空间1.响应式创建名称空间

kubectl create namespace ns-tom-12.声明式创建名称空间

[root@k8s231 namespaces]# cat > ns-tom-2.yaml <<EOF

apiVersion: v1

kind: Namespace

metadata:name: ns-tom-2

EOF

[root@k8s231 namespaces]# kubectl apply -f ns-tom-2.yaml

[root@k8s231 pods]# kubectl get ns

NAME STATUS AGE

default Active 4d9h

kube-flannel Active 4d9h

kube-node-lease Active 4d9h

kube-public Active 4d9h

kube-system Active 4d9h

ns-tom-1 Active 14s

ns-tom-2 Active 4s13.3. 修改名称空间(名称空间一旦创建将无法修改!)

13.4. pod使用名称空间

[root@k8s231 namespaces]# cat > pods-ns.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: webnamespace: ns-tom-1

spec:containers:- name: nginximage: nginx:alpine

---

apiVersion: v1

kind: Pod

metadata:name: webnamespace: ns-tom-2

spec:containers:- name: nginximage: nginx:alpine

EOF[root@k8s231 pods]# kubectl apply -f pods-ns.yaml

pod/web created

pod/web created[root@k8s231 pods]# kubectl get pods -A|egrep "NAMESPACE|web"

NAMESPACE NAME READY STATUS RESTARTS AGE

ns-tom-1 web 1/1 Running 0 97s

ns-tom-2 web 1/1 Running 0 97s13.5. 删除名称空间中的pod

[root@k8s231 pods]# kubectl delete pod web -n ns-tom-1

pod "web" deleted13.6. 删除名称空间

慎用:一旦删除名称空间,该名称空间下的所有资源都会被随之删除

[root@k8s231 pods]# kubectl get po,cm,secret -n ns-tom-2

NAME READY STATUS RESTARTS AGE

pod/web 1/1 Running 0 4m55sNAME DATA AGE

configmap/kube-root-ca.crt 1 13mNAME TYPE DATA AGE

secret/default-token-n8wnp kubernetes.io/service-account-token 3 13m[root@k8s231 pods]# kubectl delete namespaces ns-tom-2

namespace "ns-tom-2" deleted[root@k8s231 pods]# kubectl get po,cm,secret -n ns-tom-2

No resources found in ns-tom-2 namespace.14. 控制器之RC(Replication Controller)副本控制器

Replication Controller(副本控制器),RC能够保证任意时间,pod都有指定的数量的副本在运行。(pod被删除会重新创建pod)

RC控制的pod的多个副本,每个副本都有独立的ip,并且支持pod副本数量的扩、缩容。

(1) 编写rc清单

cat > rc-web.yaml <<EOF

#api版本

apiVersion: v1

#对象资源类型 RC

kind: ReplicationController

#RC元数据

metadata:#对象资源名称name: nginx

#RC的详细描述

spec:#维持pod的共数量replicas: 3#RC选择器,指定对哪个Pod使用rcselector:#label 标签,选择有此 label 的 Podapp: webversion: v1# 定义创建 Pod 实例的模板template:metadata:name: nginx # Pod 的 label,对应上面 rc 的 selector labels:app: webversion: v1level: "3"spec:containers: # 定义 Pod 中的容器- name: nginximage: nginx:alpine

EOF(2) 创建rc清单

[root@k8s231 rc]# kubectl apply -f rc-web.yaml(3) 查看rc清单

[root@k8s231 rc]# kubectl get rc -o wide --show-labels

NAME DESIRED CURRENT READY AGE CONTAINERS IMAGES SELECTOR LABELS

nginx 3 3 3 5m52s nginx nginx:alpine app=web,version=v1 app=nginx(4) 查看rc清单创建的pod

[root@k8s231 rc]# kubectl get pod -o wide --show-labels

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES LABELS

nginx-2t6pn 1/1 Running 0 3m15s 10.200.2.27 k8s233.tom.com <none> <none> app=web,level=3,version=v1

nginx-tdlqd 1/1 Running 0 3m15s 10.200.2.26 k8s233.tom.com <none> <none> app=web,level=3,version=v1

nginx-xdbwf 1/1 Running 0 3m15s 10.200.1.30 k8s232.tom.com <none> <none> app=web,level=3,version=v1(5) 修改rc清单的副本数

#方式1:静态修改清单,然后apply

sed -i 's#replicas:.*#replicas: 2#g' rc-web.yaml

kubectl apply -f rc-web.yaml#方式2:动态修改,修改完立马生效

kubectl edit replicationcontrollers nginx (6) 删除rc

kubectl delete rc nginx 或 kubectl delete -f rc-web.yaml 15. Service

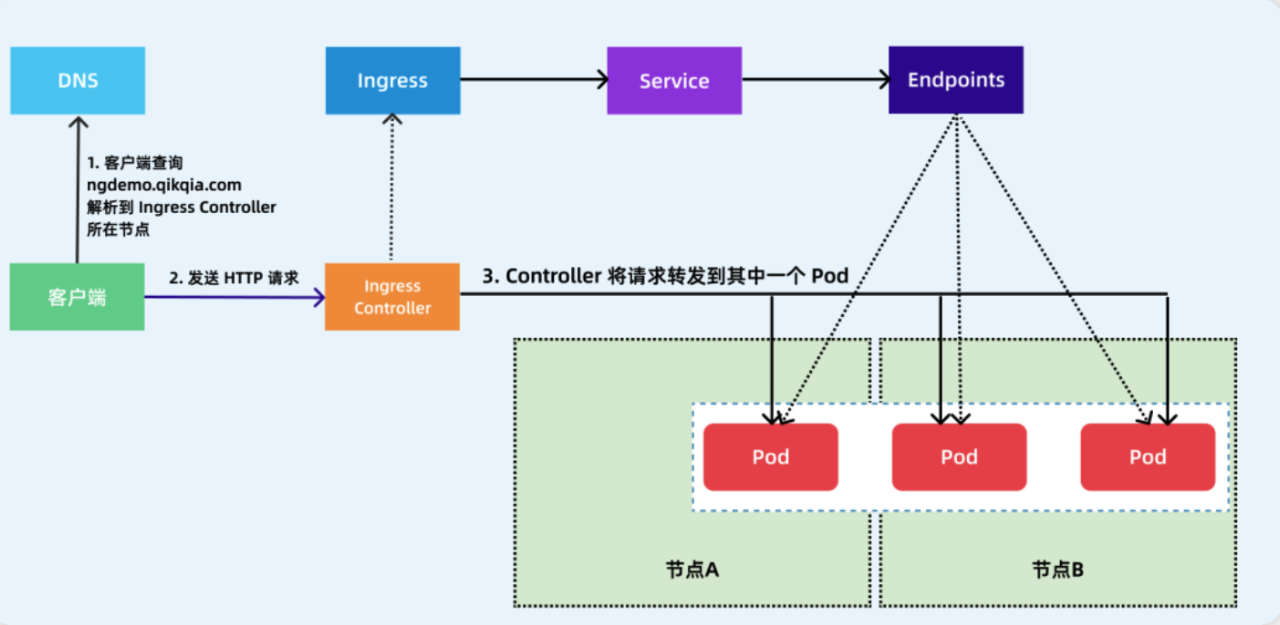

Service 存在的意义?

引入 Service 主要是解决 Pod 的动态变化,通过创建 Service,可以为一组具有相同功能的容器应用提供一个统一的入口地址,并且将请求负载分发到后端的各个容器应用上。

若提供服务的容器应用是分布式,所以存在多个 pod 副本,而 Pod 副本数量可能在运行过程中动态改变,比如水平扩缩容,或者服务器发生故障 Pod 的 IP 地址也有可能发生变化。当 pod 的地址端口发生改变后,客户端再想连接访问应用就得人工干预,很麻烦,这时就可以通过 service 来解决问题。

概念:

Service 主要用于提供网络服务,通过 Service 的定义,能够为客户端应用提供稳定的访问地址(域名或 IP 地址)和负载均衡功能,以及屏蔽后端 Endpoint 的变化,是 K8s 实现微服务的核心资源。

svc 特点:

-

- 服务发现,防止阴滚动升级等因素导致 Pod IP 发生改变而失联,找到提供同一个服务的 Pod。

- 负载均衡,定义一组 Pod 的访问策略。

15.1. svc的分类:

- ExternalName: 可以将K8S集群外部的服务映射为一个svc服务。类似于一种CNAME技术.

- ClusterIP: 仅用于K8S集群内部使用。提供统一的VIP地址。默认值!

- NodePort: 除了分配 ClusterIP 外,还会在每一个 Node 上享有一个高端口号,即

nodeIP:nodePort暴露服务。可以从集群外部访问服务。但不经常使用,局限性较大 - LoadBalancer: 主要用于云平台的LB等产品。

15.2. serveice 之 ClusterIP案例

#(1)查看当前存在的pod

[root@k8s231 svc]# kubectl get pods -o wide --show-labels

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES LABELS

nginx-65zbj 1/1 Running 0 4m9s 10.200.1.33 k8s232.tom.com <none> <none> app=web,level=3,version=v1

nginx-8w7qb 1/1 Running 0 4m9s 10.200.2.30 k8s233.tom.com <none> <none> app=web,level=3,version=v1

nginx-tvr7k 1/1 Running 0 4m9s 10.200.1.32 k8s232.tom.com <none> <none> app=web,level=3,version=v1#(2)编写svc清单

[root@k8s231 services]# cat > 01-svc-ClusterIP.yaml <<EOF

apiVersion: v1

kind: Service

metadata:name: webnamespace: defaultlabels:apps: svc

spec:# 根据标签,关联后端的Podselector:app: webtype: ClusterIP# 指定端口映射相关信息ports:# 指定svc的端口号- port: 88# 指定Pod端口号targetPort: 80# 指定协议protocol: TCP# 指定ClusterIP的地址#clusterIP: 10.100.1.0

EOF#(3)创建svc

[root@k8s231 svc]# kubectl apply -f 01-svc-ClusterIP.yaml#(4)查看创建的svc

[root@k8s231 svc]# kubectl get svc -o wide --show-labels

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR LABELS

kubernetes ClusterIP 10.100.0.1 <none> 443/TCP 5d8h <none> component=apiserver,provider=kubernetes

web ClusterIP 10.100.194.202 <none> 88/TCP 28s app=web apps=svc#(5)Endpoints为通过select的指定的标签匹配到的pod的ip,字段IP为对外提供服务的ip

[root@k8s231 svc]# kubectl describe svc web

Name: web

Namespace: default

Labels: apps=svc

Annotations: <none>

Selector: app=web

Type: ClusterIP

IP Family Policy: SingleStack

IP Families: IPv4

IP: 10.100.194.202

IPs: 10.100.194.202

Port: <unset> 88/TCP

TargetPort: 80/TCP

Endpoints: 10.200.1.32:80,10.200.1.33:80,10.200.2.30:80

Session Affinity: None

Events: <none>#(6)把三个web页面修改成相应的ip

[root@k8s231 svc]# kubectl exec nginx-tvr7k -- sh -c 'echo "nginx-tvr7k 10.200.1.32" > /usr/share/nginx/html/index.html'

[root@k8s231 svc]# kubectl exec nginx-8w7qb -- sh -c 'echo "nginx-8w7qb 10.200.2.30" > /usr/share/nginx/html/index.html'

[root@k8s231 svc]# kubectl exec nginx-65zbj -- sh -c 'echo "nginx-65zbj 10.200.1.33" > /usr/share/nginx/html/index.html'#(7)访问svc的ip,查看负载均衡的效果

[root@k8s231 svc]# curl 10.100.194.202:88

nginx-tvr7k 10.200.1.32

[root@k8s231 svc]# curl 10.100.194.202:88

nginx-8w7qb 10.200.2.30

[root@k8s231 svc]# curl 10.100.194.202:88

nginx-65zbj 10.200.1.33#(8)删除svc

[root@k8s231 svc]# kubectl delete svc web15.3. serveice 之 NodePort案例

除了分配 ClusterIP 外,还会在每一个 Node 上享有一个高端口号暴露服务。客户可以从集群外部访问nodeIP:nodePort访问服务。但不经常使用,局限性较大

#(1)编写资源清单

]# cat > 02-svc-nodeport.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: pod-nginxlabels:app: web

spec:containers:- name: nginximage: nginx:alpine

---

apiVersion: v1

kind: Service

metadata:name: svc-nginx

spec:selector:app: webtype: NodePortports:# 指定访问宿主机的端口,有效端口范围是:"30000-32767",该端口的报文会被转发后端的容器端口- nodePort: 30080#集群内部访问的端口号port: 88#容器内部服务端口号targetPort: 80# 指定协议protocol: TCP # 指定ClusterIP的地址#clusterIP: 10.100.100.200

EOF#(2)创建资源

]# kubectl apply -f 02-svc-nodeport.yaml#(3)查看资源

]# kubectl get svc,pod -o wide

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR

service/kubernetes ClusterIP 10.100.0.1 <none> 443/TCP 10s <none>

service/svc-nginx NodePort 10.100.25.155 <none> 88:30080/TCP 7s app=webNAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

pod/pod-nginx 1/1 Running 0 7s 10.200.1.58 k8s232.tom.com <none> <none>#(3)集群内部访问端口号80访问

]# curl -o /dev/null -s -w %{http_code} 10.100.25.155:88

200#(4)集群外部访问端口号30080访问

]# curl -o /dev/null -s -w %{http_code} k8s233.tom.com:30080

20015.4. serveice 之 LoadBalance案例:

- LoadBalance案例:(1)前提条件

K8S集群在任意云平台环境,比如腾讯云,阿里云,京东云等。(2)创建svc

[root@k8s231 services]# cat > 03-services-LoadBalance.yaml <<EOF

kind: Service

apiVersion: v1

metadata:name: svc-loadbalancer

spec:# 指定service类型为LoadBalancer,注意,一般用于云环境type: LoadBalancerselector:apps: webports:- protocol: TCPport: 80targetPort: 80nodePort: 30080

EOF(3)配置云环境的应用负载均衡器

添加监听器规则,比如访问负载均衡器的80端口,反向代理到30080端口。

简而言之,就是访问云环境的应用服务器的哪个端口,把他反向代理到K8S集群的node端口为30080即可。(4)用户访问应用负载均衡器的端口

用户直接访问云环境应用服务器的80端口即可,请求会自动转发到云环境nodePort的30080端口哟。15.5. service 之 ExternalName案例:

[root@k8s231 ~]# cat 04-svc-ExternalName.yaml

apiVersion: v1

kind: Service

metadata:name: svc-externalname

spec:# svc类型type: ExternalName# 指定外部域名externalName: www.baidu.com温馨提示:启动容器后访问名为"svc-externalname"的svc,请求会被cname到"www.baidu.com"的A记录。这种方式使用并不多,因为对于域名解析直接配置DSNS的解析较多,因此此处了解即可。 16. 探针(probe)

参考链接: Pod 的生命周期 | Kubernetes

16.1. 探针(Probe)分类:

常用的探针(Probe):livenessProbe:存活探针健康状态检查,周期性检查服务是否存活,检查结果失败,将"重启"容器(删除源容器并重新创建新容器)。如果容器没有提供健康状态检查,则默认状态为Success。readinessProbe:就绪探针,可用性检查可用性检查,周期性检查服务是否可用,从而判断容器是否就绪。若检测Pod服务不可用,则会将Pod从svc的ep列表中移除。若检测Pod服务可用,则会将Pod重新添加到svc的ep列表中。如果容器没有提供可用性检查,则默认状态为Success。startupProbe:启动探针 (1.16+之后的版本才支持)如果提供了启动探针,则所有其他探针都会被禁用,直到此探针成功为止。如果启动探测失败,kubelet将杀死容器,而容器依其重启策略进行重启。 如果容器没有提供启动探测,则默认状态为 Success。16.2. 探针(Probe)检测Pod服务方法:

探针(Probe)检测Pod服务方法:exec:执行一段命令,根据返回值判断执行结果。返回值为0或非0,有点类似于"echo $?"。httpGet:发起HTTP请求,根据返回的状态码来判断服务是否正常。200: 返回状态码成功301: 永久跳转302: 临时跳转401: 验证失败403: 权限被拒绝404: 文件找不到413: 文件上传过大500: 服务器内部错误502: 无效的请求504: 后端应用网关响应超时...tcpSocket:测试某个TCP端口是否能够链接,类似于telnet,nc等测试工具。16.3. 检测成功和失败的相关参数

initialDelaySeconds:Pod启动后延迟多久才进行检查,单位:秒。

periodSeconds:检查的间隔时间,默认为10,单位:秒。

timeoutSeconds:探测的超时时间,默认为1,单位:秒。

successThreshold:探测失败后认为成功的最小连接成功次数,默认为1,在Liveness探针中必须为1,最小值为1。

failureThreshold:探测失败的重试次数,重试一定次数后将认为失败,在readiness探针中,Pod会被标记为未就绪,默认为3,最小值16.4. livenessProbe探针使用方法

livenessProbe健康状态检查,周期性检查服务是否存活,检查结果失败,将"重启"容器(删除源容器并重新创建新容器)。如果容器没有提供健康状态检查,则默认状态为Success。

16.4.1. livenessProbe之exec: 检测命令执行是否成功

cat > livenessprobe-exec.yaml <<EOF

kind: Pod

apiVersion: v1

metadata:name: livenessprobe-exec

spec:containers:- name: webimage: nginx:alpinecommand: - /bin/sh- -c- touch /tmp/healthy; sleep 5; rm -f /tmp/healthy; sleep 600# 健康状态检查,周期性执行命令,命令执行失败,将重启容器。livenessProbe:# 使用exec的方式去做健康检查exec:# 自定义检查的命令command:- cat- /tmp/healthy# 检测服务失败次数的累加值,默认值是3次,最小值是1。当检测服务成功后,该值会被重置!failureThreshold: 3# Pod启动后延迟多久才进行检查,即此时间段内检测服务失败并不会对failureThreshold进行计数。initialDelaySeconds: 15# 指定探针检测的频率,默认是10s,最小值为1.periodSeconds: 1# 检测服务成功次数的累加值,默认值为1次,最小值1.successThreshold: 1# 一次检测周期超时的秒数,默认值是1秒,最小值为1.timeoutSeconds: 1

EOF实验结果:15秒开始,检测到失败,18秒左右pod中容器重启16.4.2. livenessProbe之httpGet:检测页面是否能访问

livenessProbe-httpGet检测方法

cat > livenessprobe-httpget.yaml <<EOF

kind: Pod

apiVersion: v1

metadata:name: livenessprobe-httpget

spec:volumes:- name: dataemptyDir: {}containers:- name: webimage: nginx:alpine volumeMounts:- name: datamountPath: /usr/share/nginx/html# 健康状态检查,周期性检查页面是否能访问,检查结果失败,将重启容器。livenessProbe:# 使用httpGet的方式去做健康检查httpGet:# 指定访问的端口号port: 80# 检测指定的访问路径path: /index.html# 检测服务失败次数的累加值,默认值是3次,最小值是1。当检测服务成功后,该值会被重置!failureThreshold: 3# 指定多久之后进行健康状态检查,即此时间段内检测服务失败并不会对failureThreshold进行计数。initialDelaySeconds: 20# 指定探针检测的频率,默认是10s,最小值为1.periodSeconds: 1# 检测服务成功次数的累加值,默认值为1次,最小值1.successThreshold: 1# 一次检测周期超时的秒数,默认值是1秒,最小值为1.timeoutSeconds: 1

EOF实验结果:

1.刚开始启动,pod正常运行,但是web服务异常,因为缺失index.html

2.连接pod中的web,手动创建/usr/share/nginx/html/index.html(容器启动20秒内完成,否则就会触发重启)16.4.3. livenessProbe之tcpSocket:检测端口连通性

- tcpSocket检测方法

cat > livenessprobe-tcpsocket.yaml <<EOF

kind: Pod

apiVersion: v1

metadata:name: livenessprobe-tcpsocket

spec:containers:- name: webimage: nginx:alpinecommand:- /bin/sh- -c- nginx ; sleep 10; nginx -s stop ; sleep 600# 健康状态检查,周期性检查端口是否存在,检查结果失败,将重启容器。livenessProbe:# 使用tcpSocket的方式去做健康检查tcpSocket:port: 80# 检测服务失败次数的累加值,默认值是3次,最小值是1。当检测服务成功后,该值会被重置!failureThreshold: 3# 指定多久之后进行健康状态检查,即此时间段内检测服务失败并不会对failureThreshold进行计数。initialDelaySeconds: 15# 指定探针检测的频率,默认是10s,最小值为1.periodSeconds: 1# 检测服务成功次数的累加值,默认值为1次,最小值1.successThreshold: 1# 一次检测周期超时的秒数,默认值是1秒,最小值为1.timeoutSeconds: 1

EOF实验结果:

1.15秒开始检测,18秒左右报错,pod中容器重启16.5. readinessProbe探针使用方法

readinessProbe:就绪探针

- 可用性检查,周期性检查服务是否可用,从而判断容器是否就绪。

- 若检测Pod服务不可用,则会将Pod从svc的ep列表中移除。

- 若检测Pod服务可用,则会将Pod重新添加到svc的ep列表中。

- 如果容器没有提供可用性检查,则默认状态为Success。

16.5.1. readinessProbe之exec: 检测命令执行是否成功

(1)编写资源清单(包含rc,svc)

cat > readiessprobe-exec.yaml <<EOF

apiVersion: v1

kind: ReplicationController

metadata:name: rc-readinessprobe-execnamespace: defaultlabels:v1: tomv2: jack

spec:replicas: 3selector:hobby: gamebook: sanguotemplate:metadata:namespace: defaultlabels:hobby: gamebook: sanguoage: "18"spec:containers:- name: webimage: nginx:alpine# 可用性检查,周期性执行命令是否成功,从而判断容器是否就绪.readinessProbe:# 使用exec的方式去做健康检查exec:# 自定义检查的命令command:- ls- /usr/share/nginx/html/index.htmlfailureThreshold: 3initialDelaySeconds: 15periodSeconds: 1successThreshold: 1timeoutSeconds: 1

---

apiVersion: v1

kind: Service

metadata:name: svc-readinessprobe-execnamespace: defaultlabels:apps: svc-read

spec:selector:hobby: gamebook: sanguotype: ClusterIPports:- port: 80targetPort: 80protocol: TCP#clusterIP: 10.100.100.200

EOF(2)创建资源清单

[root@k8s231 probe]# kubectl apply -f readiessprobe-exec.yaml(3)查看Pod状态(三个pod里面的容器都是未就绪状态,15秒内是未就绪状态(用了readinessProbe默认就是未就绪),15秒后,命令检测成功了就变为就绪状态了)

#15秒内是未就绪状态

[root@k8s231 probe]# kubectl get pods

NAME READY STATUS RESTARTS AGE

rc-readinessprobe-exec-4z5zs 1/1 Running 0 32s

rc-readinessprobe-exec-7jfgb 1/1 Running 0 32s

rc-readinessprobe-exec-qdk75 1/1 Running 0 32s

#15秒后,命令检测成功了就变为就绪状态了

[root@k8s231 probe]# kubectl get pods

NAME READY STATUS RESTARTS AGE

rc-readinessprobe-exec-4z5zs 1/1 Running 0 5m46s

rc-readinessprobe-exec-7jfgb 1/1 Running 0 5m46s

rc-readinessprobe-exec-qdk75 1/1 Running 0 5m46s(4)查看svc的状态

[root@k8s231 probe]# kubectl get svc --show-labels

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE LABELS

kubernetes ClusterIP 10.100.0.1 <none> 443/TCP 6d component=apiserver,provider=kubernetes

svc-readinessprobe-exec ClusterIP 10.100.141.130 <none> 80/TCP 5m16s apps=svc-read(5)查看ep(ENDPOINTS)的状态

[root@k8s231 probe]# kubectl get ep

NAME ENDPOINTS AGE

kubernetes 10.0.0.231:6443 6d1h

svc-readinessprobe-exec 10.200.1.36:80,10.200.1.37:80,10.200.2.34:80 4m30s(6)查看svc的详细信息ep(此时Endpoints为空)

[root@k8s231 probe]# kubectl describe svc svc-readinessprobe-exec|grep Endpoints

Endpoints: 10.200.1.36:80,10.200.1.37:80,10.200.2.34:80(7)查看ep详细信息中的就绪地址和未就绪地址

[root@k8s231 probe]# kubectl describe ep svc-readinessprobe-exec |grep -i addressAddresses: 10.200.1.36,10.200.1.37,10.200.2.34NotReadyAddresses: <none>(8)将任意2个Pod调整为未就绪状态

[root@k8s231 probe]# kubectl exec rc-readinessprobe-exec-4z5zs -- rm /usr/share/nginx/html/index.html

[root@k8s231 probe]# kubectl exec rc-readinessprobe-exec-7jfgb -- rm /usr/share/nginx/html/index.html(9)查看pod状态,发现有2个pod状态已经变为就绪了

[root@k8s231 probe]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

rc-readinessprobe-exec-4z5zs 0/1 Running 0 6m41s 10.200.1.36 k8s232.tom.com <none> <none>

rc-readinessprobe-exec-7jfgb 0/1 Running 0 6m41s 10.200.1.37 k8s232.tom.com <none> <none>

rc-readinessprobe-exec-qdk75 1/1 Running 0 6m41s 10.200.2.34 k8s233.tom.com <none> <none>(9)查看ep(ENDPOINTS)的状态(发现只有1个就绪的pod的ip了)

[root@k8s231 probe]# kubectl get ep

NAME ENDPOINTS AGE

kubernetes 10.0.0.231:6443 6d1h

svc-readinessprobe-exec 10.200.2.34:80 6m58s(10)查看svc的详细信息ep(此时Endpoints只有1个就绪的pod的ip了)

[root@k8s231 probe]# kubectl describe svc svc-readinessprobe-exec|grep Endpoints

Endpoints: 10.200.2.34:80(11)查看ep详细信息中的就绪地址和未就绪地址(1个就绪ip,2个未就绪ip)

[root@k8s231 probe]# kubectl describe ep svc-readinessprobe-exec |grep -i addressAddresses: 10.200.2.34NotReadyAddresses: 10.200.1.36,10.200.1.37(12)删除案例(rc和svc一起删除)

[root@k8s231 probe]# kubectl delete -f readiessprobe-exec.yaml

replicationcontroller "rc-readinessprobe-exec" deleted

service "svc-readinessprobe-exec" deleted16.5.2. readinessProbe之httpGet:检测页面是否能访问

(1)编写资源清单(包含rc,svc)

cat > readiessprobe-httpget.yaml <<EOF

apiVersion: v1

kind: ReplicationController

metadata:name: rc-readinessprobe-httpgetnamespace: defaultlabels:v1: tomv2: jack

spec:replicas: 3selector:hobby: gamebook: sanguotemplate:metadata:namespace: defaultlabels:hobby: gamebook: sanguoage: "18"spec:containers:- name: webimage: nginx:alpine# 可用性检查,周期性检查页面是否能访问,从而判断容器是否就绪.readinessProbe:# 使用httpGet的方式去做健康检查httpGet:# 指定访问的端口号port: 80# 检测指定的访问路径path: /index.htmlfailureThreshold: 3initialDelaySeconds: 15periodSeconds: 1successThreshold: 1timeoutSeconds: 1

---

apiVersion: v1

kind: Service

metadata:name: svc-readinessprobe-httpgetnamespace: defaultlabels:apps: svc-read

spec:selector:hobby: gamebook: sanguotype: ClusterIPports:- port: 80targetPort: 80protocol: TCP#clusterIP: 10.100.100.200

EOF(2)创建资源清单

kubectl apply -f readiessprobe-httpget.yaml(3)查看Pod状态

[root@k8s231 probe]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

rc-readinessprobe-httpget-hqtgd 1/1 Running 0 70s age=18,book=sanguo,hobby=game

rc-readinessprobe-httpget-kvk6q 1/1 Running 0 70s age=18,book=sanguo,hobby=game

rc-readinessprobe-httpget-w52h5 1/1 Running 0 70s age=18,book=sanguo,hobby=game(4)查看svc的状态

[root@k8s231 probe]# kubectl get svc --show-labels

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE LABELS

kubernetes ClusterIP 10.100.0.1 <none> 443/TCP 6d1h component=apiserver,provider=kubernetes

svc-readinessprobe-httpget ClusterIP 10.100.112.29 <none> 80/TCP 6s apps=svc-read(5)查看ep(ENDPOINTS)的状态

[root@k8s231 probe]# kubectl get ep

NAME ENDPOINTS AGE

kubernetes 10.0.0.231:6443 6d1h

svc-readinessprobe-exec 10.200.1.38:80,10.200.2.35:80,10.200.2.36:80 21s(6)查看svc的详细信息ep

[root@k8s231 probe]# kubectl describe svc svc-readinessprobe-exec|grep Endpoints

Endpoints: 10.200.1.38:80,10.200.2.35:80,10.200.2.36:80(7)查看ep详细信息中的就绪地址和未就绪地址

[root@k8s231 probe]# kubectl describe ep svc-readinessprobe-exec |grep -i addressAddresses: 10.200.1.38,10.200.2.35,10.200.2.36NotReadyAddresses: <none>(8)将任意2个Pod调整为未就绪状态

[root@k8s231 probe]# kubectl exec rc-readinessprobe-httpget-hqtgd -- rm /usr/share/nginx/html/index.html

[root@k8s231 probe]# kubectl exec rc-readinessprobe-httpget-kvk6q -- rm /usr/share/nginx/html/index.html(9)查看pod状态,发现有2个pod状态已经变未就绪了

[root@k8s231 probe]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

rc-readinessprobe-httpget-hqtgd 0/1 Running 0 2m55s 10.200.2.36 k8s233.tom.com <none> <none>

rc-readinessprobe-httpget-kvk6q 0/1 Running 0 2m55s 10.200.2.35 k8s233.tom.com <none> <none>

rc-readinessprobe-httpget-w52h5 1/1 Running 0 2m55s 10.200.1.38 k8s232.tom.com <none> <none>(9)查看ep(ENDPOINTS)的状态(发现有2个就绪的pod的ip了)

[root@k8s231 probe]# kubectl get ep

NAME ENDPOINTS AGE

kubernetes 10.0.0.231:6443 6d1h

svc-readinessprobe-httpget 10.200.1.38:80 3m15s(10)查看svc的详细信息ep(此时Endpoints有2个就绪的pod的ip了)

[root@k8s231 probe]# kubectl describe svc svc-readinessprobe-httpget|grep Endpoints

Endpoints: 10.200.1.38:80(11)查看ep详细信息中的就绪地址和未就绪地址

[root@k8s231 probe]# kubectl describe ep svc-readinessprobe-httpget |grep -i addressAddresses: 10.200.1.38NotReadyAddresses: 10.200.2.35,10.200.2.36(12)删除案例(rc和svc一起删除)

[root@k8s231 probe]# kubectl delete -f readiessprobe-httpget.yaml 16.5.3. readinessProbe之tcpSocket:检测端口连通性

(1)编写资源清单(包含rc,svc)

cat > readiessprobe-tcpsocket.yaml <<EOF

apiVersion: v1

kind: ReplicationController

metadata:name: rc-readinessprobe-tcpsocketnamespace: defaultlabels:v1: tomv2: jack

spec:replicas: 3selector:hobby: gamebook: sanguotemplate:metadata:namespace: defaultlabels:hobby: gamebook: sanguoage: "18"spec:containers:- name: webimage: nginx:alpine# 可用性检查,周期性检查服务是否可用,从而判断容器是否就绪.readinessProbe:# 使用tcpSocket的方式去做健康检查tcpSocket:port: 80failureThreshold: 3initialDelaySeconds: 15periodSeconds: 1successThreshold: 1timeoutSeconds: 1

---

apiVersion: v1

kind: Service

metadata:name: svc-readinessprobe-tcpsocketnamespace: defaultlabels:apps: svc-read

spec:selector:hobby: gamebook: sanguotype: ClusterIPports:- port: 80targetPort: 80protocol: TCP#clusterIP: 10.100.100.200

EOF(2)创建资源清单

[root@k8s231 probe]# kubectl apply -f readiessprobe-tcpsocket.yaml(3)查看Pod状态(三个pod里面的容器都是未就绪状态)

[root@k8s231 probe]# kubectl get pod --show-labels

NAME READY STATUS RESTARTS AGE LABELS

rc-readinessprobe-tcpsocket-jpqv5 0/1 Running 0 10s age=18,book=sanguo,hobby=game

rc-readinessprobe-tcpsocket-p8bhk 0/1 Running 0 10s age=18,book=sanguo,hobby=game

rc-readinessprobe-tcpsocket-wnrvg 0/1 Running 0 10s age=18,book=sanguo,hobby=game(4)查看svc的状态

[root@k8s231 probe]# kubectl get svc --show-labels

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE LABELS

kubernetes ClusterIP 10.100.0.1 <none> 443/TCP 6d1h component=apiserver,provider=kubernetes

svc-readinessprobe-tcpsocket ClusterIP 10.100.67.17 <none> 80/TCP 20s apps=svc-read(5)查看ep(ENDPOINTS)的状态

[root@k8s231 probe]# kubectl get ep --show-labels

NAME ENDPOINTS AGE LABELS

kubernetes 10.0.0.231:6443 6d1h endpointslice.kubernetes.io/skip-mirror=true

svc-readinessprobe-tcpsocket 10.200.1.42:80,10.200.1.43:80,10.200.2.40:80 30s apps=svc-read(6)查看svc的详细信息ep

[root@k8s231 probe]# kubectl describe svc svc-readinessprobe-tcpsocket|grep Endpoints

Endpoints: 10.200.1.42:80,10.200.1.43:80,10.200.2.40:80(7)查看ep详细信息中的就绪地址和未就绪地址

[root@k8s231 probe]# kubectl describe ep svc-readinessprobe-tcpsocket |grep -i addressAddresses: 10.200.1.42,10.200.1.43,10.200.2.40NotReadyAddresses: <none>(8)将任意2个Pod调整为未就绪状态(将80端口变为88端口)

[root@k8s231 probe]# kubectl exec rc-readinessprobe-tcpsocket-jpqv5 -- sh -c " sed -i 's#80#88#g' /etc/nginx/conf.d/default.conf; nginx -s reload"

[root@k8s231 probe]# kubectl exec rc-readinessprobe-tcpsocket-p8bhk -- sh -c " sed -i 's#80#88#g' /etc/nginx/conf.d/default.conf; nginx -s reload"(9)查看pod状态,发现有2个pod状态已经变未就绪了

[root@k8s231 probe]# kubectl get pods

NAME READY STATUS RESTARTS AGE

rc-readinessprobe-tcpsocket-jpqv5 0/1 Running 0 2m26s

rc-readinessprobe-tcpsocket-p8bhk 0/1 Running 0 2m26s

rc-readinessprobe-tcpsocket-wnrvg 1/1 Running 0 2m26s(9)查看ep(ENDPOINTS)的状态(发现有2个就绪的pod的ip了)

[root@k8s231 probe]# kubectl get ep

NAME ENDPOINTS AGE

kubernetes 10.0.0.231:6443 6d1h

svc-readinessprobe-tcpsocket 10.200.1.42:80 2m47s(10)查看svc的详细信息ep(此时Endpoints有2个就绪的pod的ip了)

[root@k8s231 probe]# kubectl describe svc svc-readinessprobe-tcpsocket|grep Endpoints

Endpoints: 10.200.1.42:80(11)查看ep详细信息中的就绪地址和未就绪地址

[root@k8s231 probe]# kubectl describe ep svc-readinessprobe-tcpsocket |grep -i addressAddresses: 10.200.1.42NotReadyAddresses: 10.200.1.43,10.200.2.40(12)删除案例(rc和svc一起删除)

[root@k8s231 probe]# kubectl delete -f readiessprobe-tcpsocket.yaml 16.6. startupProbe探针使用方法

startupProbe:启动探针 (1.16+之后的版本才支持)

- 如果提供了启动探针,则所有其他探针都会被禁用,直到此探针成功为止。

- 如果启动探测失败,kubelet将杀死容器,而容器依其重启策略进行重启。

- 如果容器没有提供启动探测,则默认状态为 Success。

- 优先级高于readinessprobe和livenessprobe

16.6.1. 三种探针一起使用的案例

(1)编写资源清单(包含rc,svc)

cat > probe.yaml <<EOF

apiVersion: v1

kind: ReplicationController

metadata:name: rc-probenamespace: defaultlabels:v1: tomv2: jack

spec:replicas: 3selector:hobby: gamebook: sanguotemplate:metadata:namespace: defaultlabels:hobby: gamebook: sanguoage: "18"spec:containers:- name: webimage: nginx:alpine# 可用性检查,周期性检查服务是否可用,从而判断容器是否就绪.livenessProbe:tcpSocket:port: 80failureThreshold: 3initialDelaySeconds: 15periodSeconds: 1successThreshold: 1timeoutSeconds: 1 readinessProbe:httpGet: port: 80path: /read.htmlfailureThreshold: 3initialDelaySeconds: 15periodSeconds: 3successThreshold: 1timeoutSeconds: 1startupProbe:exec:command:- ls- /usr/share/nginx/html/index.htmlfailureThreshold: 3initialDelaySeconds: 15periodSeconds: 3successThreshold: 1timeoutSeconds: 1

---

apiVersion: v1

kind: Service

metadata:name: svc-probenamespace: defaultlabels:apps: svc-probe

spec:selector:hobby: gamebook: sanguotype: ClusterIPports:- port: 80targetPort: 80protocol: TCP#clusterIP: 10.100.100.200

EOF(2)创建资源清单

[root@k8s231 probe]# kubectl apply -f probe.yaml(3)查看Pod状态(startupProbe检查成功,liveness-probe成功,readinessProbe失败)

[root@k8s231 probe]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

rc-readiess-liveness-probe-7m6zl 0/1 Running 0 92s age=18,book=sanguo,hobby=game

rc-readiess-liveness-probe-ms5wt 0/1 Running 0 93s age=18,book=sanguo,hobby=game

rc-readiess-liveness-probe-sq74z 0/1 Running 0 92s age=18,book=sanguo,hobby=game(4)startupProbe只在启动的时候检测,成功启动后,删除/usr/share/nginx/html/index.html,startupProbe就不会再次检测了

[root@k8s231 probe]# kubectl exec rc-probe-k8sgx -- rm -f /usr/share/nginx/html/index.html[root@k8s231 probe]# kubectl get pods

NAME READY STATUS RESTARTS AGE

rc-probe-k8sgx 0/1 Running 0 4m38s

rc-probe-ksjmj 0/1 Running 0 4m38s

rc-probe-swsxl 0/1 Running 0 4m38s(5)livenessProbe检测80端口,这里把80端口改为88端口,会触发容器重启

[root@k8s231 probe]# kubectl exec rc-probe-k8sgx -- sh -c " sed -i 's#80#88#g' /etc/nginx/conf.d/default.conf; nginx -s reload"

[root@k8s231 probe]# kubectl get pods

NAME READY STATUS RESTARTS AGE

rc-probe-k8sgx 0/1 Running 1 (1s ago) 9m10s

rc-probe-ksjmj 0/1 Running 0 9m10s

rc-probe-swsxl 0/1 Running 0 9m10s(6)readinessProbe检测/read.html,这里创建这个文件,pod状态就会变为就绪

[root@k8s231 probe]# kubectl exec rc-probe-k8sgx -- sh -c "echo 1 > /usr/share/nginx/html/read.html"

[root@k8s231 probe]# kubectl get pods

NAME READY STATUS RESTARTS AGE

rc-probe-k8sgx 1/1 Running 1 (3m28s ago) 12m

rc-probe-ksjmj 0/1 Running 0 12m

rc-probe-swsxl 0/1 Running 0 12m(7)删除案例(rc和svc一起删除)

[root@k8s231 probe]# kubectl delete -f probe.yaml17. 初始化容器(init container)

初始化容器用到的字段为initContainers。

Init Container 是一种特殊容器,顾名思义是用来做初始化工作的容器,可以是一个或者多个,如果有多个的话,这些容器会按定义的顺序依次执行,只有所有的Init Container执行完后,主容器才会被启动

举个例子: 下面的例子定义了一个具有 2 个 Init 容器的简单 Pod。第一个等待 myservice 启动, 第二个等待 mydb 启动。一旦这两个 Init 容器都启动完成,Pod 将启动 spec 节中的应用容器。

apiVersion: v1

kind: Pod

metadata:name: myapp-podlabels:app.kubernetes.io/name: MyApp

spec:containers:- name: myapp-containerimage: busybox:1.28command: ['sh', '-c', 'echo The app is running! && sleep 3600']initContainers:- name: init-myserviceimage: busybox:1.28command: ['sh', '-c', "until nslookup myservice.$(cat /var/run/secrets/kubernetes.io/serviceaccount/namespace).svc.cluster.local; do echo waiting for myservice; sleep 2; done"]- name: init-mydbimage: busybox:1.28command: ['sh', '-c', "until nslookup mydb.$(cat /var/run/secrets/kubernetes.io/serviceaccount/namespace).svc.cluster.local; do echo waiting for mydb; sleep 2; done"]18. Pod的安全上下文securityContext

安全上下文(Security Context)定义 Pod 或 Container 的特权与访问控制设置

kubectl explain po.spec.containers.securityContext

kubectl explain po.spec.securityContext

https://kubernetes.io/zh-cn/docs/tasks/configure-pod-container/security-context/参考案例:(1)编写dockerfile

[root@k8s231 ]# mkdir -p cd /docker/securityContext && cd /docker/securityContext

[root@k8s231 securityContext]# cat > Dockerfile <<EOF

FROM centos:7

RUN curl -o /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo

RUN yum -y install iptables-services net-tools && rm -rf /var/cache/yum

RUN useradd -u 666 tom

CMD ["tail","-f","/etc/hosts"]

EOF

[root@k8s231 securityContext]# cat > build.sh <<EOF

#!/bin/bash

docker image build -t harbor.tom.com/library/centos7-iptabls:v0.1 .

docker login -u admin -padmin harbor.tom.com

docker image push harbor.tom.com/library/centos7-iptabls:v0.1

docker logout harbor.tom.com

EOF(2)部署pod测试

[root@k8s231 pods]# cd /manifests/pods

[root@k8s231 pods]# cat > pod-securityContext.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: pod-securitycontext

spec:containers:- name: c1image: harbor.tom.com/library/centos7-iptabls:v0.1# 配置Pod的安全相关属性securityContext:# 配置容器为特权容器,若配置了特权容器,可能对capabilities测试有影响哟!#privileged: true# 自定义LINUX内核特性# 推荐阅读:# https://man7.org/linux/man-pages/man7/capabilities.7.html# https://docs.docker.com/compose/compose-file/compose-file-v3/#cap_add-cap_dropcapabilities:# 添加所有的Linux内核功能add:- ALL# 移除指定Linux内核特性drop:# 代表禁用网络管理的配置,# - NET_ADMIN# 代表禁用UID和GID,表示你无法使用chown命令哟 - CHOWN# # 代表禁用chroot命令- SYS_CHROOT# 如果容器的进程以root身份运行,则禁止容器启动!# runAsNonRoot: true# 指定运行程序的用户UID,注意,该用户的UID必须存在!runAsUser: 666

EOF[root@k8s231 pods]# kubectl apply -f pod-securityContext.yaml [root@k8s231 pods]# kubectl exec -it pod-securitycontext -- bash

[tom@pod-securitycontext /]$ whoami

tom19. pod生命周期lifecycle

Pod的生命周期优雅的终止案例:

[root@k8s231 pods]# cat > pod-lifecycle-postStart-preStop.yaml <<EOF

apiVersion: v1

kind: Pod

metadata:name: lifecycle-001

spec:nodeName: k8s232.tom.comvolumes:- name: datahostPath:path: /tom-data# 在pod优雅终止时,定义延迟发送kill信号的时间,此时间可用于pod处理完未处理的请求等状况。# 默认单位是秒,若不设置默认值为30s。terminationGracePeriodSeconds: 60containers:- name: mywebimage: nginx:alpinestdin: truevolumeMounts:- name: datamountPath: /data/# 定义Pod的生命周期。lifecycle:# Pod启动之后做的事情postStart:exec:command: - "/bin/sh"- "-c"- "echo \"postStart at $(date +%F_%T)\" >> /data/postStart.log"# Pod停止之前做的事情preStop:exec:command: - "/bin/sh"- "-c"- "echo \"preStop at $(date +%F_%T)\" >> /data/preStop.log"

EOF[root@k8s231 pods]# kubectl apply -f pod-lifecycle-postStart-preStop.yaml#在232节点上查看日志

[root@k8s232 ~]# cat /tom-data/*.log

postStart at 2024-08-09_22:05:57[root@k8s231 pods]# kubectl delete -f pod-lifecycle-postStart-preStop.yaml#在232节点上查看日志

[root@k8s232 ~]# cat /tom-data/*.log

postStart at 2024-08-09_22:05:57

preStop at 2024-08-09_22:05:5720. pod创建流程

1.用户发起请求:

用户通过响应式或者声明式提交创建pod请求,请求信息包含容器镜像、环境变量、资源需求、卷挂载等2.格式解析,认证,权限校验(apiServer):

用户的请求首先到达apiServer,会对请求进行认证、授权和准入控制检查。3.pod信息存储(etcd):

apiServer认定请求有效后,它会将Pod的定义信息写入etcd(分布式键值存储),以确保集群内的所有组件都能获取最新的集群状态。

这标志着Pod在k8s集群中已被创建并存在,尽管此刻它还没有被调度到任何节点上运行4.controller manager管理集群

controller manager会通过API Server提供的接口实时监控资源对象的当前状态

控制器计算需要创建的Pod副本数量,并根据Pod模板创建出相应数量的Pods,维护集群状态5.调度决策(scheduler):

Scheduler监听apiserver中创建的Pod事件,基于节点的资源可用性、硬件等因素,选择最适合运行该Pod的节点,然后把信息告知apiserver6.apiserver将调度结果存入etcd:

scheduler将Pod绑定Node的结果发给API Server,由API Server写入etcd7.节点上部署pod(kubelet):

被选定Pod的节点上的kubelet监听到APIServer发送的Pod更新的事件后,开始创建pod

1.创建Pause基础网路镜像容器

2.创建initcontainers初始化容器

3.创建业务容器1.容器启动后,执行poststart操作2.容器启动后,执行startupProbe探针,判断是否继续运行3.执行readinessProbe和livenessProbe探针4.容器退出前,执行prestop21. 静态Pod(了解即可):

vim /var/lib/kubelet/config.yaml ...

staticPodPath: /etc/kubernetes/manifests

温馨提示:

(1)静态Pod是由kubelet启动时通过"staticPodPath"配置参数指定路径

(2)静态Pod创建的Pod名称会自动加上kubelet节点的主机名,比如"k8s231.tom.com"

(3)静态Pod的创建并不依赖API-Server,而是直接基于kubelet所在节点来启动Pod;

(4)静态Pod的删除只需要将其从staticPodPath指定的路径移除即可;

(5)静态Pod路径仅对Pod资源类型有效,其他类型资源将不被创建

(6)kubeadm部署方式就是基于静态Pod部署的;

22. 控制器之RS(ReplicaSet)副本控制器

replicaset作用: 控制Pod的副本数量。

和rc相比: 功能更加强大,不仅仅支持标签匹配,还支持表达式匹配。

rs的Pod控制器实战案例:

mkdir

[root@k8s231 replicasets]# cat 01-rs-matchlabels.yaml

apiVersion: apps/v1

kind: ReplicaSet

metadata:name: rs-matchlabels

spec: replicas: 5 selector: matchLabels: apps: webtemplate:metadata:labels:apps: weblevel: L1spec:containers:- name: webimage:nginx:alpine[root@k8s231 replicasets]# cat 02-rs-matchexpressions.yaml

apiVersion: apps/v1

kind: ReplicaSet

metadata:name: rs-matchexpressions

spec: replicas: 5 selector:# 基于表达式匹配matchExpressions:- key: apps# 当operator的值为In或者NotIn时,values的值不能为空。# values:# - haha# - xixi# 当operator的值为Exists或者DoesNotExist时,values的值必须为空.operator: Exists# 定义Pod资源创建的模板template:metadata:labels:apps: webspec:containers:- name: webimage: nginx:alpine23. 控制器之Deployment

- Deployment是k8s中用来管理发布的控制器

- Deployment滚动更新的实现,依赖的是Kubernetes中的ReplicaSet

- Deployment控制器实际操纵的,就是Replicas对象,而不是Pod对象。对于Deployment、ReplicaSet、Pod它们的关系如下图:

#(1)创建deploy资源清单

]# cat > 01-deployment.yaml <<EOF

apiVersion: apps/v1

kind: Deployment

metadata:name: nginx-deploymentlabels:app: nginx

spec:replicas: 2 selector:matchLabels:app: nginxtemplate:metadata:labels:app: nginxspec:hostNetwork: truecontainers:- name: nginximage: nginx:1.12.2ports:- containerPort: 80

---

apiVersion: v1

kind: Service

metadata:name: svc-deploy-nginx

spec:selector:app: nginxtype: ClusterIPports:- port: 80targetPort: 80clusterIP: 10.100.1.11

EOF#(2)创建deploy资源

]# kubectl apply -f 01-deployment.yaml#(3)查看deploy,rs,pods资源

]# kubectl get deploy,rs,svc,pod -o wide

NAME READY UP-TO-DATE AVAILABLE AGE CONTAINERS IMAGES SELECTOR

deployment.apps/nginx-deployment 2/2 2 2 10s nginx nginx:1.12 app=nginxNAME DESIRED CURRENT READY AGE CONTAINERS IMAGES SELECTOR

replicaset.apps/nginx-deployment-84fc49578f 2 2 2 10s nginx nginx:1.12 app=nginx,pod-template-hash=84fc49578fNAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR

service/kubernetes ClusterIP 10.100.0.1 <none> 443/TCP 12s <none>

service/svc-deploy-nginx ClusterIP 10.100.1.11 <none> 80/TCP 9s app=nginxNAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

pod/nginx-deployment-84fc49578f-64kqb 1/1 Running 0 10s 10.200.1.61 k8s232.tom.com <none> <none>

pod/nginx-deployment-84fc49578f-r4v5k 1/1 Running 0 9s 10.200.2.51 k8s233.tom.com <none> <none>#(4)验证nginx版本号

]# curl 10.100.1.11 -I|& grep Server

Server: nginx/1.12.2#(5)版本升级#响应式-非交互修改

]# kubectl set image deployment nginx-deployment nginx=nginx:1.13#响应式-交互修改

]# kubectl edit deployments.apps nginx-deployment #声明式修改

]# vim 01-deployment.yaml

]# kubectl apply -f 01-deployment.yaml#(6)查看deploy,rs,pods资源

]# kubectl get deploy,rs,svc,pod -o wide

NAME READY UP-TO-DATE AVAILABLE AGE CONTAINERS IMAGES SELECTOR

deployment.apps/nginx-deployment 2/2 2 2 71s nginx nginx:1.13 app=nginxNAME DESIRED CURRENT READY AGE CONTAINERS IMAGES SELECTOR

replicaset.apps/nginx-deployment-6bc9989998 2 2 2 5s nginx nginx:1.13 app=nginx,pod-template-hash=6bc9989998

replicaset.apps/nginx-deployment-84fc49578f 0 0 0 71s nginx nginx:1.12 app=nginx,pod-template-hash=84fc49578fNAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR

service/kubernetes ClusterIP 10.100.0.1 <none> 443/TCP 73s <none>

service/svc-deploy-nginx ClusterIP 10.100.1.11 <none> 80/TCP 70s app=nginxNAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

pod/nginx-deployment-6bc9989998-fzhjj 1/1 Running 0 5s 10.200.2.52 k8s233.tom.com <none> <none>

pod/nginx-deployment-6bc9989998-j7lxd 1/1 Running 0 3s 10.200.1.62 k8s232.tom.com <none> <none>#(7)验证nginx版本号