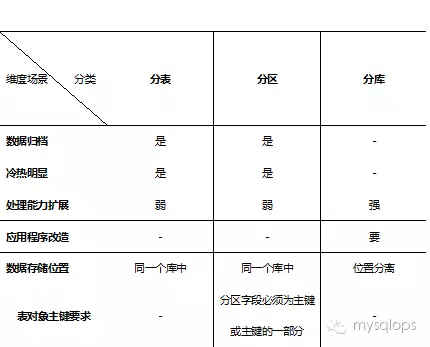

分表分区的区别

实现方式上

数据处理上

提高性能上

实现的难易度上

mysql分表和分区的联系

如何分区

概述

分区技术支持

分区类型及举例

注意

应用场景示例

订单表比预想中扩张速度快

坑爹的日志表

每半月一个分区,自动维护

备注

RDS for MySQL 对表分区的限制

RDS是否需要自己做分表、读写分离

RDS MySQL的单表尺寸限制

PS:分库能够突破单机瓶颈

什么是分表分区

分表

分表是将一个大表按照一定的规则分解成多张具有独立存储空间的实体表,我们可以称为子表,每个表都对应三个文件,MYD数据文件,.MYI索引文件,.frm表结构文件。这些子表可以分布在同一块磁盘上,也可以在不同的机器上。

分区

分区和分表相似,都是按照规则分解表。不同在于分表将大表分解为若干个独立的实体表,而分区是将数据分段划分在多个位置存放(但是数据表还是同一个),可以是同一块磁盘也可以在不同的机器。

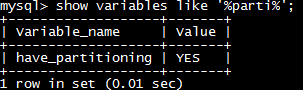

mysql可以通过下面语句判断是否支持分区:

SHOW VARIABLES LIKE '%partition%';

如果输出:

have_partitioning YES

表示支持分区。

或者通过:

SHOW PLUGINS;

显示所有插件,如果有partition ACTIVE STORAGE ENGINE GPL 插件则表明支持分区

查看表是否为分区表:

show table status like 'table_name';

Create_options: partitioned

查看分区信息:

select * from information_schema.partitions where table_schema=schema() and table_name = '表名';

为什么要进行表分区

为了改善大型表以及具有各种访问模式的表的可伸缩性,可管理性和提高数据库效率。

分区的一些优点包括:

- 与单个磁盘或文件系统分区相比,可以存储更多的数据。

- 对于那些已经失去保存意义的数据,通常可以通过删除与那些数据有关的分区,很容易地删除那些数据。相反地,在某些情况下,添加新数据的过程又可以通过为那些新数据专门增加一个新的分区,来很方便地实现。通常和分区有关的其他优点包括下面列出的这些。MySQL分区中的这些功能目前还没有实现,但是在我们的优先级列表中,具有高的优先级;我们希望在5.1的生产版本中,能包括这些功能。

- 一些查询可以得到极大的优化,这主要是借助于满足一个给定WHERE语句的数据可以只保存在一个或多个分区内,这样在查找时就不用查找其他剩余的分区。因为分区可以在创建了分区表后进行修改,所以在第一次配置分区方案时还不曾这么做时,可以重新组织数据,来提高那些常用查询的效率。

- 涉及到例如SUM()和COUNT()这样聚合函数的查询,可以很容易地进行并行处理。这种查询的一个简单例子如 “SELECT salesperson_id, COUNT (orders) as order_total FROM sales GROUP BY salesperson_id;”。通过“并行”,这意味着该查询可以在每个分区上同时进行,最终结果只需通过总计所有分区得到的结果。

- 通过跨多个磁盘来分散数据查询,来获得更大的查询吞吐量。

分表分区的区别

实现方式上

分表

mysql的分表是真正的分表,一张表分成很多表后,每一个小表都是完正的一张表,都对应三个文件,一个.MYD数据文件,.MYI索引文件,.frm表结构文件。

[root@BlackGhost test]# ls |grep useralluser.MRGalluser.frmuser1.MYDuser1.MYIuser1.frmuser2.MYDuser2.MYIuser2.frm

简单说明一下,上面的分表呢是利用了merge存储引擎(分表的一种),alluser是总表,下面有二个分表,user1,user2。他们二个都是独立的表,取数据的时候,我们可以通过总表来取。这里总表是没有.MYD,.MYI这二个文件的,也就是说,总表他不是一张表,没有数据,数据都放在分表里面。我们来看看.MRG到底是什么东西

[root@BlackGhost test]# cat alluser.MRG |moreuser1user2#INSERT_METHOD=LAST

从上面我们可以看出,alluser.MRG里面就存了一些分表的关系,以及插入数据的方式。可以把总表理解成一个外壳,或者是联接池。

分区

一张大表进行分区后,他还是一张表,不会变成二张表,但是他存放数据的区块变多了。

[root@BlackGhost test]# ls |grep aaaa#P#p1.MYDaa#P#p1.MYIaa#P#p3.MYDaa#P#p3.MYIaa.frmaa.par

从上面我们可以看出,aa这张表,分为二个区,p1和p3,本来是三个区,被我删了一个区。我们都知道一张表对应三个文件.MYD,.MYI,.frm。分区呢根据一定的规则把数据文件和索引文件进行了分割,还多出了一个.par文件,打开.par文件后你可以看出他记录了,这张表的分区信息,根分表中的.MRG有点像。分区后,还是一张,而不是多张表。

数据处理上

分表

分表后,数据都是存放在分表里,总表只是一个外壳,存取数据发生在一个一个的分表里面。看下面的例子:

select * from alluser where id='12'表面上看,是对表alluser进行操作的,其实不是的。是对alluser里面的分表进行了操作。

分区

分区只不过把存放数据的文件分成了许多小块,分区后的表呢,还是一张表。数据处理还是由自己来完成。

提高性能上

分表

分表后,单表的并发能力提高了,磁盘I/O性能也提高了。并发能力为什么提高了呢,因为查寻一次所花的时间变短了,如果出现高并发的话,总表可以根据不同的查询,将并发压力分到不同的小表里面。磁盘I/O性能怎么搞高了呢,本来一个非常大的.MYD文件现在也分摊到各个小表的.MYD中去了。

分区

mysql提出了分区的概念,我觉得就想突破磁盘I/O瓶颈,想提高磁盘的读写能力,来增加mysql性能。

在这一点上,分区和分表的测重点不同,分表重点是存取数据时,如何提高mysql并发能力上;而分区呢,如何突破磁盘的读写能力,从而达到提高mysql性能的目的。

实现的难易度上

分表

分表的方法有很多,用merge来分表,是最简单的一种方式。这种方式根分区难易度差不多,并且对程序代码来说可以做到透明的。如果是用其他分表方式就比分区麻烦了。

分区

分区实现是比较简单的,建立分区表,根建平常的表没什么区别,并且对开代码端来说是透明的。

mysql分表和分区的联系

- 都能提高mysql的性高,在高并发状态下都有一个良好的表现。

- 分表和分区不矛盾,可以相互配合的,对于那些大访问量,并且表数据比较多的表,我们可以采取分表和分区结合的方式(如果merge这种分表方式,不能和分区配合的话,可以用其他的分表试),访问量不大,但是表数据很多的表,我们可以采取分区的方式等。

- 分表技术是比较麻烦的,需要手动去创建子表,app服务端读写时候需要计算子表名。采用merge好一些,但也要创建子表和配置子表间的union关系。

- 表分区相对于分表,操作方便,不需要创建子表。

如何分区

MySQL 分区技术(是mysql 5.1以版本后开始用->是甲骨文mysql技术团队维护人员以插件形式插入到mysql里面的技术)

概述

数据库单表到达一定量后,性能会有衰减,像mysql\sql server等犹为明显,所以需要把这些数据进行分区处理。同时有时候可能出现数据剥离什么的,分区表就更有用处了!

MySQL 5.1 中新增的分区(Partition)功能就开始增加,优势也越来越明显了:

- 与单个磁盘或文件系统分区相比,可以存储更多的数据

- 很容易就能删除不用或者过时的数据

- 一些查询可以得到极大的优化

- 涉及到 SUM()/COUNT() 等聚合函数时,可以并行进行

- IO吞吐量更大

- 分区允许可以设置为任意大小的规则,跨文件系统分配单个表的多个部分。实际上,表的不同部分在不同的位置被存储为单独的表。

分区技术支持

在5.6之前,使用这个参数查看当将配置是否支持分区:

mysql> SHOW VARIABLES LIKE '%partition%';+-----------------------+-------+|Variable_name | Value |+-----------------------+-------+| have_partition_engine | YES |+-----------------------+-------+

如果是yes表示你当前的配置支持分区。 在5.6及以采用后,则采用如下方式进行查看:

mysql> SHOW PLUGINS;+----------------------------+----------+--------------------+---------+---------+| Name | Status | Type | Library | License |+----------------------------+----------+--------------------+---------+---------+| binlog | ACTIVE | STORAGE ENGINE | NULL | GPL || mysql_native_password | ACTIVE | AUTHENTICATION | NULL | GPL |..................................................................................| INNODB_LOCKS | ACTIVE | INFORMATION SCHEMA | NULL | GPL || INNODB_LOCK_WAITS | ACTIVE | INFORMATION SCHEMA | NULL | GPL || partition | ACTIVE | STORAGE ENGINE | NULL | GPL |+----------------------------+----------+--------------------+---------+---------+

42 rows in set (0.00 sec) 最后一行,可以看到partition是ACTIVE的,表示支持分区。

分区类型及举例

RANGE 分区

基于属于一个给定连续区间的列值,把多行分配给分区。如时间,连续的常量值等 –按年分区

CREATE TABLE users (uid INT UNSIGNED NOT NULL AUTO_INCREMENT PRIMARY KEY,name VARCHAR(30) NOT NULL DEFAULT '',email VARCHAR(30) NOT NULL DEFAULT '')PARTITION BY RANGE (uid) (PARTITION p0 VALUES LESS THAN (3000000)DATA DIRECTORY = '/data0/data'INDEX DIRECTORY = '/data1/idx',PARTITION p1 VALUES LESS THAN (6000000)DATA DIRECTORY = '/data2/data'INDEX DIRECTORY = '/data3/idx',PARTITION p2 VALUES LESS THAN (9000000)DATA DIRECTORY = '/data4/data'INDEX DIRECTORY = '/data5/idx',PARTITION p3 VALUES LESS THAN MAXVALUE DATA DIRECTORY = '/data6/data'INDEX DIRECTORY = '/data7/idx');

在这里,将用户表分成4个分区,以每300万条记录为界限,每个分区都有自己独立的数据、索引文件的存放目录,与此同时,这些目录所在的物理磁盘分区可能也都是完全独立的,可以提高磁盘IO吞吐量。

LIST 分区

类似于按RANGE分区,区别在于LIST分区是基于列值匹配一个离散值集合中的某个值来进行选择。比如说类似性别(1,2)等属性值。

CREATE TABLE category (cid INT UNSIGNED NOT NULL AUTO_INCREMENT PRIMARY KEY,name VARCHAR(30) NOT NULL DEFAULT '')PARTITION BY LIST (cid) (PARTITION p0 VALUES IN (0,4,8,12)DATA DIRECTORY = '/data0/data'INDEX DIRECTORY = '/data1/idx',PARTITION p1 VALUES IN (1,5,9,13)DATA DIRECTORY = '/data2/data'INDEX DIRECTORY = '/data3/idx',PARTITION p2 VALUES IN (2,6,10,14)DATA DIRECTORY = '/data4/data'INDEX DIRECTORY = '/data5/idx',PARTITION p3 VALUES IN (3,7,11,15)DATA DIRECTORY = '/data6/data'INDEX DIRECTORY = '/data7/idx');

分成4个区,数据文件和索引文件单独存放。注意,list只能是数字,使用字符会报错ERROR 1697 (HY000): VALUES value for partition 'c1' must have type INT。

HASH分区

基于用户定义的表达式的返回值来进行选择的分区,该表达式使用将要插入到表中的这些行的列值进行计算。这个函数可以包>含MySQL中有效的、产生非负整数值的任何表达式。

–以int字段hash分区

CREATE TABLE users (uid INT UNSIGNED NOT NULL AUTO_INCREMENT PRIMARY KEY,name VARCHAR(30) NOT NULL DEFAULT '',email VARCHAR(30) NOT NULL DEFAULT '')PARTITION BY HASH (uid) PARTITIONS 4 (PARTITION p0DATA DIRECTORY = '/data0/data'INDEX DIRECTORY = '/data1/idx',PARTITION p1DATA DIRECTORY = '/data2/data'INDEX DIRECTORY = '/data3/idx',PARTITION p2DATA DIRECTORY = '/data4/data'INDEX DIRECTORY = '/data5/idx',PARTITION p3DATA DIRECTORY = '/data6/data'INDEX DIRECTORY = '/data7/idx');

分成4个区,数据文件和索引文件单独存放。

KEY分区

与HASH分区类似,但它的key可以不是整数类型,如字符串等类型的字段。MySQL 簇(Cluster)使用函数MD5()来实现KEY分区;对于使用其他存储引擎的表,服务器使用其自己内部的哈希函数,这些函数是基于与PASSWORD()一样的运算法则。

CREATE TABLE users (uid INT UNSIGNED NOT NULL AUTO_INCREMENT PRIMARY KEY,name VARCHAR(30) NOT NULL DEFAULT '',email VARCHAR(30) NOT NULL DEFAULT '')PARTITION BY KEY (uid) PARTITIONS 4 (PARTITION p0DATA DIRECTORY = '/data0/data'INDEX DIRECTORY = '/data1/idx',PARTITION p1DATA DIRECTORY = '/data2/data'INDEX DIRECTORY = '/data3/idx',PARTITION p2DATA DIRECTORY = '/data4/data'INDEX DIRECTORY = '/data5/idx',PARTITION p3DATA DIRECTORY = '/data6/data'INDEX DIRECTORY = '/data7/idx');

分成4个区,数据文件和索引文件单独存放。

子分区

子分区是针对 RANGE/LIST 类型的分区表中每个分区的再次分割。再次分割可以是 HASH/KEY 等类型。例如:

CREATE TABLE users (uid INT UNSIGNED NOT NULL AUTO_INCREMENT PRIMARY KEY,name VARCHAR(30) NOT NULL DEFAULT '',email VARCHAR(30) NOT NULL DEFAULT '')PARTITION BY RANGE (uid) SUBPARTITION BY HASH (uid % 4) SUBPARTITIONS 2(PARTITION p0 VALUES LESS THAN (3000000)DATA DIRECTORY = '/data0/data'INDEX DIRECTORY = '/data1/idx',PARTITION p1 VALUES LESS THAN (6000000)DATA DIRECTORY = '/data2/data'INDEX DIRECTORY = '/data3/idx');

对 RANGE 分区再次进行子分区划分,子分区采用 HASH 类型。

或者

CREATE TABLE users (uid INT UNSIGNED NOT NULL AUTO_INCREMENT PRIMARY KEY,name VARCHAR(30) NOT NULL DEFAULT '',email VARCHAR(30) NOT NULL DEFAULT '')PARTITION BY RANGE (uid) SUBPARTITION BY KEY(uid) SUBPARTITIONS 2(PARTITION p0 VALUES LESS THAN (3000000)DATA DIRECTORY = '/data0/data'INDEX DIRECTORY = '/data1/idx',PARTITION p1 VALUES LESS THAN (6000000)DATA DIRECTORY = '/data2/data'INDEX DIRECTORY = '/data3/idx');

对 RANGE 分区再次进行子分区划分,子分区采用 KEY 类型。

维护命令

现有表分区(经测试,阿里云RDS 1500W现有数据表进行分区,执行10-15分钟)

alter table 33-> partition by hash(id)-> partitions 2;alter table '33'partition by hash(id)partitions 2;

添加分区

alter table xxxxxxx add partition (partition p0 values less than(1991)); //只能添加大于分区键的分区

查看分区情况

select * from information_schema.partitions where table_schema=schema() and table_name = '表名';

删除分区

alter table xxxxxxx drop partition p0; //可以删除任意分区

删除分区数据

alter table xxxxxx truncate partition p1,p2;alter table xxxxxx truncate partition all;或delete from xxxxxx where separated < '2006-01-01' or (separated >= '2006-01-01' and separated<'2011-01-01');

重定义分区(包括重命名分区,伴随移动数据;合并分区)

alter table xxxxx reorganize partition p1,p3,p4 into (partition pm1 values less than(2006),partition pm2 values less than(2011));

rebuild重建分区

alter table xxxxxx rebuild partition pm1/all; //相当于drop所有记录,然后再reinsert;可以解决磁盘碎片

优化表

alter table tt2 optimize partition pm1; //在大量delete表数据后,可以回收空间和碎片整理。但在5.5.30后支持。在5.5.30之前可以通过recreate+analyze来替代,如果用rebuild+analyze速度慢

analzye表

alter table xxxxxx analyze partition pm1/all;

check表

alter table xxxxxx check partition pm1/all;

show create table employees2; //查看分区表的定义show table status like 'employees2'\G; //查看表时候是分区表 如“Create_options: partitioned”select * from information_schema.KEY_COLUMN_USAGE where table_name='employees2'; //查看索引SELECT * FROM information_schema.partitions WHERE table_name='employees2' //查看分区表explain partitions select * from employees2 where separated < '1990-01-01' or separated > '2016-01-01'; //查看分区是否被select使用

其它说明

mysql-5.5开始支持COLUMNS分区,可视为RANGE和LIST分区的进化,COLUMNS分区可以直接使用非整形数据进行分区。COLUMNS分区支持以下数据类型: 所有整形,如INT SMALLINT TINYINT BIGINT。FLOAT和DECIMAL则不支持。 日期类型,如DATE和DATETIME。其余日期类型不支持。 字符串类型,如CHAR、VARCHAR、BINARY和VARBINARY。BLOB和TEXT类型不支持。 COLUMNS可以使用多个列进行分区。

mysql> create table range_p(-> perid int(11),-> pername char(12) not null,-> monsalary DECIMAL(10,2),-> credate datetime-> ) PARTITION BY RANGE COLUMNS (credate)(-> partition p20151 values less than ('2015-04-01'),-> partition p20152 values less than ('2015-07-01'),-> partition p20153 values less than ('2015-10-01'),-> partition p20154 values less than ('2016-01-01'),-> partition p20161 values less than ('2016-04-01'),-> partition partlog values less than maxvalue-> );Query OK, 0 rows affected (0.12 sec)

注意

- 对于通过RANGE分区的表,只可以使用ADD PARTITION添加新的分区到分区列表的高端。即不能添加比这个分区的范围小的分区。

- 对于按照RANGE分区的表,只能重新组织相邻的分区;不能跳过RANGE分区。不能使用REORGANIZEPARTITION来改变表的分区类型;也就是说,例如,不能把RANGE分区变为HASH分区,反之亦然。也不能使用该命令来改变分区表达式或列。

- 注意主键和唯一索引的区别

- MySQL主键的限制,每一个分区表中的公式中的列,必须在主键/unique key 中包括

官方资料:https://dev.mysql.com/doc/refman/5.5/en/partitioning.html - 如果原分区定义LESS THAN MAXVALUE,执行add partition会报错

MAXVALUE can only be used in last partition definition,可对该表的分区重新定义,其中的数据不会丢失,或者创建分区的时候,不定义MAX VALUE,届时手动新增分区。

应用场景示例

订单表比预想中扩张速度快

根据公司数据库实际情况,订单表有可能会比预想中扩张速度快,这里可能需要预先准备下优化方案,传统方案是分表或者分库,不过目前最好的方案是使用mysql的表分区来优化。不过需要注意的是在表分区建立后mysql查询缓存会失效,那么可以说暂时分表带来的好处在于更新、删除以及锁处理的时间会减少,但是如果查询并非针对表分区字段进行,那么查询的时间由于查询缓存失效反而会增加,这点需要取舍。

第一步:由于表分区必须在表建立的时候创建规则,而已经存在的没有创建过表分区规则的表需要重新做导入处理。方法如下:

#这里使用HASH表分区,mysql会根据HASH字段来自动分配数据到不同的表分区,这种情况适用于没有表分区规则但是有需要分表来进行查询优化的情况。这里根据id字段hash规则创建2个表分区CREATE TABLE `creater_bak` (`id` int(11) NOT NULL,`name` varchar(100) DEFAULT NULL,PRIMARY KEY (`id`)) ENGINE=InnoDB DEFAULT CHARSET=utf8PARTITION BY HASH(id) PARTITIONS 2

创建完成后开始导入原表数据:

insert into creater_bak select * from creater;

如果数据量非常大,觉得预设的表分区数量太少,那么可以新增表分区,mysql会自动重新分配:

#这里新增8个表分区,加上新建表时候的2个,一共10个表分区了ALTER TABLE `creater_bak` ADD PARTITION PARTITIONS 8;

最后修改表名为原表名即可。

PS:下面是使用RANGE形式表分区,其中一些注意点HASH表分区也一样要注意:

1.如果使用RANGE形式进行表分区,必须设定规则,例如:

CREATE TABLE `creater_bak` (`id` int(11) NOT NULL,`name` varchar(100) DEFAULT NULL,PRIMARY KEY (`id`)) ENGINE=InnoDB DEFAULT CHARSET=utf8PARTITION BY RANGE(id) (PARTITION p0 VALUES LESS THAN (500),PARTITION p1 VALUES LESS THAN (1000),PARTITION p2 VALUES LESS THAN MAXVALUE)

2.如果想修改有规则的表分区,注意只能新增,不要随意删除,这里删除表分区会造成该表分区内部数据也一起被删除掉,千万注意。另外如果设定了MAXVALUE那么是不能新增的,虽然删除MAXVALUE那条表分区后可以新增,但是依然注意删除的MAXVALUE分区是否有数据,如果有则不能随意删除,最好的办法依然是重建一张新表,表在创建时候重新制定规则后把旧表导入新表,这样能保证不会丢失数据。虽然最好不要删除分区,但是依然下面介绍如何删除表分区以及新增表分区:

#删除上面的MAXVALUE规则表分区(如果该表分区有数据,请勿随便使用此操作)ALTER TABLE `creater_bak` drop PARTITION p2;#新增规则表分区,注意按规则步长来新增,否则会报错,这里步长为500ALTER TABLE `creater_bak` add PARTITION(PARTITION p2 VALUES LESS THAN (1500))ALTER TABLE `creater_bak` add PARTITION(PARTITION p3 VALUES LESS THAN MAXVALUE)

最后使用下面的语句可以查看分区搜索情况:

EXPLAIN PARTITIONS select * from `creater_bak` b1 where b1.`id`=11

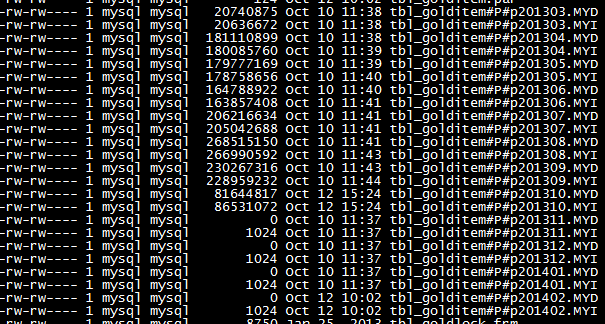

坑爹的日志表

前些天拿到一个表,将近有4000w数据,没有任何索引,主键。(建这表的绝对是个人才)

这是一个日志表,记录了游戏中物品的产出与消耗,原先有一个后台对这个表进行统计。。。。。(这要用超级计算机才能统计得出来吧),只能帮前人填坑了。。。。

数据太大,决定用分区来重构。

如果你发现是empty,说明你的mysql版本不够,分区至少要5.1

下面针对业务查询,决定用时间来做range分区(还有list,hash等类型),一个月一个区.

按照RANGE分区的表是通过如下一种方式进行分区的,每个分区包含那些分区表达式的值位于一个给定的连续区间内的行。这些区间要连续且不能相互重叠,使用VALUES LESS THAN操作符来进行定义。

新建一个表:

CREATE TABLE `xxxxxxxx` (`crttm` int(11) NOT NULL,`srvid` int(11) NOT NULL,`evtid` int(11) NOT NULL,`aid` int(11) NOT NULL,`rid` int(11) NOT NULL,`itmid` int(11) NOT NULL,`itmnum` int(11) NOT NULL,`gdtype` int(11) NOT NULL,`gdnum` int(11) NOT NULL,`islmt` int(11) NOT NULL,KEY `crttm` (`crttm`),KEY `itemid` (`itmid`),KEY `srvid` (`srvid`),KEY `gdtype` (`gdtype`)) ENGINE=myisam DEFAULT CHARSET=utf8PARTITION BY RANGE (crttm)(PARTITION p201303 VALUES LESS THAN (unix_timestamp('2013-04-01')),PARTITION p201304 VALUES LESS THAN (unix_timestamp('2013-05-01')),PARTITION p201305 VALUES LESS THAN (unix_timestamp('2013-06-01')),PARTITION p201306 VALUES LESS THAN (unix_timestamp('2013-07-01')),PARTITION p201307 VALUES LESS THAN (unix_timestamp('2013-08-01')),PARTITION p201308 VALUES LESS THAN (unix_timestamp('2013-09-01')),PARTITION p201309 VALUES LESS THAN (unix_timestamp('2013-10-01')),PARTITION p201310 VALUES LESS THAN (unix_timestamp('2013-11-01')),PARTITION p201311 VALUES LESS THAN (unix_timestamp('2013-12-01')),PARTITION p201312 VALUES LESS THAN (unix_timestamp('2014-01-01')),PARTITION p201401 VALUES LESS THAN (unix_timestamp('2014-02-01')));

注意

- primary key和unique key必须包含在分区key的一部分,否则在创建primary key和unique index时会报”ERROR 1503 (HY000)“

mysql> create unique index idx_employees1_job_code on employees1(job_code);

ERROR 1503 (HY000): A UNIQUE INDEX must include all columns in the table's partitioning function

或

mysql> ALTER TABLEskate.employees1ADD PRIMARY KEY (id) ;

ERROR 1503 (HY000): A PRIMARY KEY must include all columns in the table's partitioning function - 范围分区添加分区只能在最大值后面追加分区

- 所有分区的engine必须一样

- 范围分区分区字段:integer、数值表达式、日期列,日期函数表达式(如year(),to_days(),to_seconds(),unix_timestamp())

将旧的表数据导入到新表后,看到新表的数据都分布到不同的区了!

每半月一个分区,自动维护

建表语句

drop table if exists terminal_parameter;CREATE TABLE `terminal_parameter` (`terminal_parameter_id` int(11) NOT NULL AUTO_INCREMENT,`serial` int(11) DEFAULT NULL,`network_type` char(1) DEFAULT NULL,`mcc` int(8) DEFAULT NULL,`mnc` int(8) DEFAULT NULL,`lac` int(8) DEFAULT NULL,`cellid` int(8) DEFAULT NULL,`bsic_psc` int(8) DEFAULT NULL,`ta_ec_io` int(8) DEFAULT NULL,`bcch_rxlev_rscp` int(8) DEFAULT NULL,`arfcn_uarfcn` int(8) DEFAULT NULL,`rxq` int(8) DEFAULT NULL,`c1` int(8) DEFAULT NULL,`c2` int(8) DEFAULT NULL,`signal_intensity` int(8) DEFAULT NULL,`error_rate` int(8) DEFAULT NULL,`alarm_type` varchar(16) DEFAULT NULL,`txpower` int(8) DEFAULT NULL,`small_running_number` int(8) DEFAULT NULL,`createtime` datetime NOT NULL,`userid` int(8) NOT NULL,`terminal_id` int(8) DEFAULT NULL,`state` char(1) DEFAULT '0',`order_definition_id` int(8) DEFAULT NULL,`order_code` varchar(20) DEFAULT NULL,`charg_voltage` float(8,2) DEFAULT NULL,`battery_voltage` float(8,2) DEFAULT NULL,`temprad` float(8,2) DEFAULT NULL,`run_state` int(8) DEFAULT NULL,`switching_value1` int(8) DEFAULT NULL,`switching_value2` int(8) DEFAULT NULL,`bcch_freq` int(8) DEFAULT NULL,`rxlev` int(8) DEFAULT NULL,`rxlev_full` int(8) DEFAULT NULL,`rxlev_sub` int(8) DEFAULT NULL,`rxqual` int(8) DEFAULT NULL,`rxqual_full` int(8) DEFAULT NULL,`rxqual_sub` int(8) DEFAULT NULL,`idle_ts` int(8) DEFAULT NULL,`timing_advance` int(8) DEFAULT NULL,`tch_efr_out` int(8) DEFAULT NULL,`tch_efr_in` int(8) DEFAULT NULL,`dtx` int(8) DEFAULT NULL,`major_cycle_frequency` int(8) DEFAULT NULL,PRIMARY KEY (`terminal_parameter_id`,`createtime`),KEY `idx_createtime` (`createtime`),KEY `idx_terminal_id` (`terminal_id`)) ENGINE=InnoDB DEFAULT CHARSET=utf8PARTITION BY RANGE(TO_DAYS (createtime))(PARTITION p20101115 VALUES LESS THAN (TO_DAYS('2010-11-15')),PARTITION p20101130 VALUES LESS THAN (TO_DAYS('2010-11-30')),PARTITION p20101215 VALUES LESS THAN (TO_DAYS('2010-12-15')),PARTITION p20101231 VALUES LESS THAN (TO_DAYS('2010-12-31')),PARTITION p20110115 VALUES LESS THAN (TO_DAYS('2011-01-15')),PARTITION p20110131 VALUES LESS THAN (TO_DAYS('2011-01-31')),PARTITION p20110215 VALUES LESS THAN (TO_DAYS('2011-02-15')),PARTITION p20110228 VALUES LESS THAN (TO_DAYS('2011-02-28')),PARTITION p20110315 VALUES LESS THAN (TO_DAYS('2011-03-15')),PARTITION p20110331 VALUES LESS THAN (TO_DAYS('2011-03-31')),PARTITION p20110415 VALUES LESS THAN (TO_DAYS('2011-04-15')),PARTITION p20110430 VALUES LESS THAN (TO_DAYS('2011-04-30')));

存储过程代码:

* 每隔15天执行一次/* 程序功能:循环使用分区,每半个月一个分区,保留6个月的数据时间:2010-11-09 */drop procedure if exists Set_Partition;create procedure Set_Partition()begin/* 事务回滚,其实放这里没什么作用,ALTER TABLE是隐式提交,回滚不了的。*/declare exit handler for sqlexception rollback;start TRANSACTION;/* 到系统表查出这个表的最大分区,得到最大分区的日期。在创建分区的时候,名称就以日期格式存放,方便后面维护 */select REPLACE(partition_name,'p','') into @P12_Name from INFORMATION_SCHEMA.PARTITIONS where TABLE_SCHEMA='mydb_1' and table_name='terminal_parameter' order by partition_ordinal_position DESC limit 1;/* 判断最大分区的时间段,如果是前半个月的,那么根据情况需要加13,14,15,16天如果是后半个月的,那么直接加15天。 +0 是为了把日期都格式化成YYYYMMDD这样的格式*/IF (DAY(@P12_Name)<=15) THENCASE day(LAST_DAY(@P12_name))WHEN 31 THEN set @Max_date= date(DATE_ADD(@P12_Name+0,INTERVAL 16 DAY))+0 ;WHEN 30 THEN set @Max_date= date(DATE_ADD(@P12_Name+0,INTERVAL 15 DAY))+0 ;WHEN 29 THEN set @Max_date= date(DATE_ADD(@P12_Name+0,INTERVAL 14 DAY))+0 ;WHEN 28 THEN set @Max_date= date(DATE_ADD(@P12_Name+0,INTERVAL 13 DAY))+0 ;END CASE;ELSEset @Max_date= date(DATE_ADD(@P12_Name+0, INTERVAL 15 DAY))+0;END IF;/* 修改表,在最大分区的后面增加一个分区,时间范围加半个月 */SET @s1=concat('ALTER TABLE terminal_parameter ADD PARTITION (PARTITION p',@Max_date,' VALUES LESS THAN (TO_DAYS (''',date(@Max_date),''')))');PREPARE stmt2 FROM @s1;EXECUTE stmt2;DEALLOCATE PREPARE stmt2;/* 取出最小的分区的名称,并删除掉 。注意:删除分区会同时删除分区内的数据,慎重 */select partition_name into @P0_Name from INFORMATION_SCHEMA.PARTITIONS where TABLE_SCHEMA='mydb_1' and table_name='terminal_parameter' order by partition_ordinal_position limit 1;SET @s=concat('ALTER TABLE terminal_parameter DROP PARTITION ',@P0_Name);PREPARE stmt1 FROM @s;EXECUTE stmt1;DEALLOCATE PREPARE stmt1;/* 提交 */COMMIT ;end;

计划任务代码:

CREATE EVENT e_Set_PartitionON SCHEDULEEVERY 15 day STARTS '2011-04-30 23:59:59'DOcall Set_Partition();

备注

RDS for MySQL 对表分区的限制

只能对数据表的整型列进行分区,或者数据列可以通过分区函数转化成整型列。

最大分区数目不能超过 1024。

如果含有唯一索引或者主键,则分区列必须包含在所有的唯一索引或者主键在内。

不支持外键。

不支持全文索引(FULL TEXT)。

RDS是否需要自己做分表、读写分离

RDS产品是主备架构,但是备库不支持读写请求,只作高可用存在,RDS目前已经推出只读实例,您可以到官网购买RDS只读实例做读写分离。

另外,我们后续也会提供分布式RDS(DRDS),解决您水平拆分的问题,目前RDS需要您自己分表、分库(分平拆分、垂直拆分)。

RDS MySQL的单表尺寸限制

单表的有效最大表尺寸通常受限于操作系统的文件尺寸限制,而不是受MySQL内部机制的限制。

由于RDS实例的最大尺寸为 2TB, 因此单表的最大尺寸为略小于 2TB(因为会有些元数据等的开销)。若RDS的MySQL实例有多张表,多张表的总和也不能超过2TB。

注:本文摘自互联网~我只是理解后做了个汇总