MapReduce:大数据处理的范式

一、介绍

在当今的数字时代,生成和收集的数据量正以前所未有的速度增长。这种数据的爆炸式增长催生了大数据领域,传统的数据处理方法往往不足。MapReduce是一个编程模型和相关框架,已成为应对大数据处理挑战的强大解决方案。本文探讨了MapReduce的概念、其原理、应用及其对数据处理世界的影响。

MapReduce:大数据与它的匹配相遇,将信息的混乱转化为洞察力的智慧。

二、MapReduce的起源

MapReduce是Google在2004年由Jeffrey Dean和Sanjay Ghemawat撰写的一篇开创性论文中引入的。Google 需要一种高效且可扩展的方式来处理大量数据,以完成索引网络和生成搜索结果等任务。传统方法难以跟上不断扩大的数据量,这导致了MapReduce模型的发展。

三、MapReduce原则

MapReduce的核心是一种编程模型,它通过将任务分解为两个主要步骤来简化分布式数据处理:“Map”步骤和“Reduce”步骤。

- 映射:在映射步骤中,数据被划分为较小的块或拆分,并分配给工作器节点。每个工作节点处理其分配的数据,应用用户定义的函数(“映射器”),并发出一组键值对。然后,根据键值对的键对进行洗牌和排序,以将相关数据分组在一起。

- Reduce:在Reduce步骤中,另一组工作节点采用分组的键值对并应用用户定义的函数(“reducer”)。Reducer 处理数据,聚合结果,并生成最终输出。

MapReduce以容错的方式运行,这意味着它可以从工作节点故障中恢复,使其具有很强的弹性。它还抽象化了并行性和分布的复杂性,使开发人员能够专注于其数据处理任务的逻辑。

四、MapReduce的应用

MapReduce对各个行业和领域产生了重大影响,应用范围广泛,包括:

- 搜索引擎:Google最初的MapReduce用例是索引网络,这是一项涉及处理大量数据以创建高效搜索索引的任务。

- 数据分析: MapReduce通常用于数据分析,使组织能够从大型数据集中分析和获取见解。

- 社交媒体:Facebook 和 Twitter 等公司使用 MapReduce 来完成用户分析、趋势分析和推荐系统等任务。

- 基因组数据处理:基因组学领域利用MapReduce处理和分析大量遗传数据,用于研究和医疗保健目的。

- 日志处理:使用MapReduce可以对系统、服务器和应用程序生成的日志文件进行高效的处理和分析,以进行调试和监控。

- 自然语言处理:在NLP任务中,MapReduce用于处理和分析文本数据,如情感分析、主题建模、语言翻译等。

五、对数据处理的影响

MapReduce的引入对数据处理领域产生了深远的影响,无论是在技术上还是在思维方式上。一些主要贡献和影响包括:

- 可扩展性:MapReduce系统可以通过添加更多的工作节点来横向扩展,使组织能够处理不断增长的数据集。

- 成本效益:通过利用商用硬件和分布式处理,MapReduce系统为大数据处理提供了高性价比的解决方案。

- 简化开发:MapReduce抽象了分布式计算的许多复杂性,使开发人员更容易上手。

- 开源框架:MapReduce的成功激发了Apache Hadoop等开源实现的发展,使其广泛可用且适应性强。

- 数据驱动的决策:处理和分析海量数据集的能力使组织能够做出数据驱动的决策,从而制定更明智的策略和见解。

六、代码

在 Python 中编写包含数据集和绘图的完整 MapReduce 代码需要大量代码和数据。但是,我可以使用 Python 的内置函数为您提供一个简化的示例,我们可以使用 Matplotlib 等库生成一些基本绘图。此示例不会涵盖完整的MapReduce分布式系统,但将说明该概念。mapreduce

首先,让我们创建一个数据集并实现一个简单的 map 和 reduce 操作:

# Import necessary libraries

import random

from functools import reduce

import matplotlib.pyplot as plt# Create a sample dataset

data = [random.randint(1, 10) for _ in range(100)]# Map function: Square the numbers

def map_function(item):return item ** 2# Reduce function: Sum all squared values

def reduce_function(acc, item):return acc + item# Map the data and then reduce it

mapped_data = list(map(map_function, data))

result = reduce(reduce_function, mapped_data)# Display the result

print("Mapped data:", mapped_data)

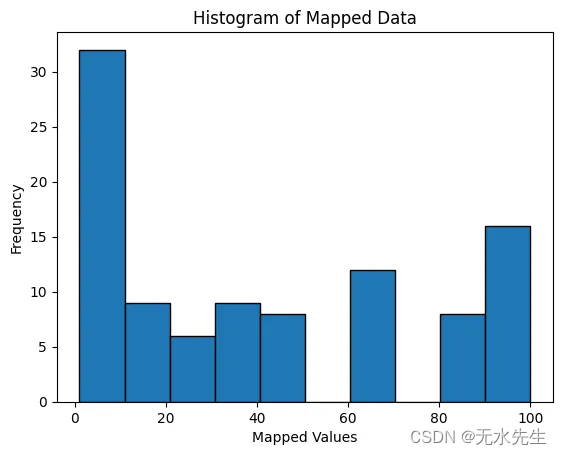

print("Reduced result:", result)现在,让我们创建一个简单的直方图来可视化映射的数据:

# Plot the histogram of the mapped data

plt.hist(mapped_data, bins=10, edgecolor='k')

plt.title('Histogram of Mapped Data')

plt.xlabel('Mapped Values')

plt.ylabel('Frequency')

plt.show()此代码将从数据集生成平方值的直方图。

Mapped data: [1, 1, 4, 81, 16, 81, 9, 36, 1, 25, 49, 4, 36, 49, 4, 25, 100, 64, 1, 4, 4, 1, 100, 1, 4, 100, 16, 100, 9, 100, 16, 36, 36, 49, 64, 36, 36, 4, 100, 4, 64, 64, 64, 36, 4, 1, 100, 100, 81, 100, 25, 49, 4, 4, 64, 81, 100, 64, 100, 64, 81, 100, 1, 81, 9, 64, 25, 4, 16, 4, 4, 49, 81, 64, 16, 1, 1, 9, 16, 49, 25, 36, 64, 1, 1, 81, 1, 25, 49, 49, 100, 16, 16, 64, 100, 36, 16, 100, 4, 100]

Reduced result: 4135要使用分布式处理创建更逼真的MapReduce代码,通常使用Hadoop或Apache Spark等框架。这些框架是为大规模数据处理而设计的,从头开始实现它们将超出简单示例的范围。

如果您有想要实现的特定数据集和MapReduce操作,请提供更多详细信息,我可以为您提供进一步的帮助。

七、工具

MapReduce是一个功能强大的编程模型和数据处理框架,通常用于处理大规模的数据处理任务。有几种工具和框架可用于MapReduce,每种工具和框架都提供不同的特性和功能。以下是MapReduce使用最广泛的一些工具:

- Hadoop:Apache Hadoop是用于实现MapReduce编程模型的最流行和最广泛使用的开源框架之一。Hadoop包括用于存储的Hadoop分布式文件系统(HDFS)和用于数据处理的Hadoop MapReduce引擎。它还提供了其他组件,例如用于资源管理的 YARN 以及用于数据管理和分析的各种工具。

- Apache Spark:Apache Spark是另一个开源的大数据处理框架,它扩展了MapReduce模型。它提供内存中数据处理,这比传统的基于磁盘的MapReduce处理更快。Spark 支持各种编程语言,例如 Scala、Java、Python 和 R,并具有用于机器学习、图形处理等的库。

- Apache Flink:Apache Flink 是一个支持MapReduce式操作的流处理和批处理框架。它专为低延迟和高吞吐量处理而设计,并在统一的 API 中提供批处理和流处理。

- Apache Tez:Apache Tez 是一个通过优化数据处理任务的执行来改进 MapReduce 执行引擎的框架。它通常与 Apache Hive 和 Apache Pig 结合使用,以提高其性能。

- Amazon EMR:Amazon Elastic MapReduce (EMR) 是 Amazon Web Services (AWS) 提供的一项基于云的服务,可简化 Hadoop、Spark 和其他大数据处理框架的部署。EMR允许用户快速设置和运行集群,以进行大规模的数据处理。

- Cloudera CDH:Cloudera 的发行版包括 Apache Hadoop (CDH) 是一个综合平台,提供一组大数据工具,包括 Hadoop、Spark、Hive、Impala 等。它专为企业级大数据处理和分析而设计。

- MapR:MapR 提供了一个完整的数据平台,包括 MapR-FS(分布式文件系统)、MapR-DB(NoSQL 数据库)和 Apache Drill(SQL 查询引擎)。它为各种大数据用例提供了一组工具和 API。

- IBM InfoSphere BigInsights:IBM 的大数据平台包括 Hadoop 和 Spark 以及其他分析和数据管理工具。它专为希望有效管理和分析大数据的企业而设计。

- Hortonworks 数据平台:Hortonworks 提供了一个大数据平台,其中包括 Apache Hadoop 和其他工具,例如用于群集管理的 Ambari 和用于数据仓库的 Hive。

这些工具用于各种方案,具体取决于您的特定要求、基础结构和首选项。MapReduce工具或框架的选择取决于可伸缩性、性能、易用性以及与组织中其他技术的集成等因素。

八、结论

MapReduce诞生于处理海量数据集的需要,已经发展成为分布式数据处理的强大范式。其映射和减少数据的原则在彻底改变我们分析、处理和从大数据中获取见解的方式方面发挥了重要作用。随着我们继续在数字世界中生成和收集大量数据,MapReduce及其相关框架仍然是数据科学家、工程师和企业寻求利用大数据潜力进行创新和发现的关键工具。