第一个Java网络爬虫程序

目录

- 前言

- 第一个Java网络爬虫程序

- 总结

前言

网络爬虫是一种获取互联网信息的技术,它可以模拟浏览器行为,访问网站并提取所需的数据。在这个小Demo中,我们使用Java语言结合HttpClient库实现了一个简单的爬虫程序,用于抓取汽车之家的车辆评测数据。在实际爬虫项目中,除了简单的HTTP请求,还需要处理页面解析、数据存储、反爬虫策略等问题。

第一个Java网络爬虫程序

- 引入依赖

HttpClient用于进行HTTP请求,slf4j用于日志记录。

<dependencies><!-- HttpClient --><dependency><groupId>org.apache.httpcomponents</groupId><artifactId>httpclient</artifactId><version>4.5.3</version></dependency><!-- 日志 --><dependency><groupId>org.slf4j</groupId><artifactId>slf4j-log4j12</artifactId><version>1.7.25</version></dependency></dependencies>- 加入log4j.properties配置

创建log4j.properties文件,用于配置日志输出的格式和级别。

log4j.rootLogger=DEBUG,A1

log4j.logger.cn.itcast = DEBUGlog4j.appender.A1=org.apache.log4j.ConsoleAppender

log4j.appender.A1.layout=org.apache.log4j.PatternLayout

log4j.appender.A1.layout.ConversionPattern=%-d{yyyy-MM-dd HH:mm:ss,SSS} [%t] [%c]-[%p] %m%n- 编写最简单的爬虫,抓取汽车之家车辆评测数据

public class AutohomeCrawlerTest {public static void main(String[] args) throws Exception {// 创建HttpClient对象CloseableHttpClient httpClient = HttpClients.createDefault();// 声明访问地址HttpGet httpGet = new HttpGet("https://www.autohome.com.cn/bestauto/");// 发起请求CloseableHttpResponse response = httpClient.execute(httpGet);// 判断状态码是否是200if (response.getStatusLine().getStatusCode() == 200) {// 解析数据String content = EntityUtils.toString(response.getEntity(), "UTF-8");System.out.println(content);}}

}

CloseableHttpClient httpClient = HttpClients.createDefault();:创建一个默认的CloseableHttpClient对象,用于执行HTTP请求。HttpGet httpGet = new HttpGet("https://www.autohome.com.cn/bestauto/");:创建一个HttpGet对象,指定要访问的URL。CloseableHttpResponse response = httpClient.execute(httpGet);:使用httpClient对象执行HTTP请求,获取服务器的响应。if (response.getStatusLine().getStatusCode() == 200):判断HTTP响应的状态码是否为200,表示请求成功。String content = EntityUtils.toString(response.getEntity(), "UTF-8");:将服务器响应的实体内容转换为字符串,使用UTF-8编码。System.out.println(content);:输出请求返回的HTML内容。

一般步骤:

- 创建HttpClient对象

- 声明访问地址

- 发起请求

- 解析数据

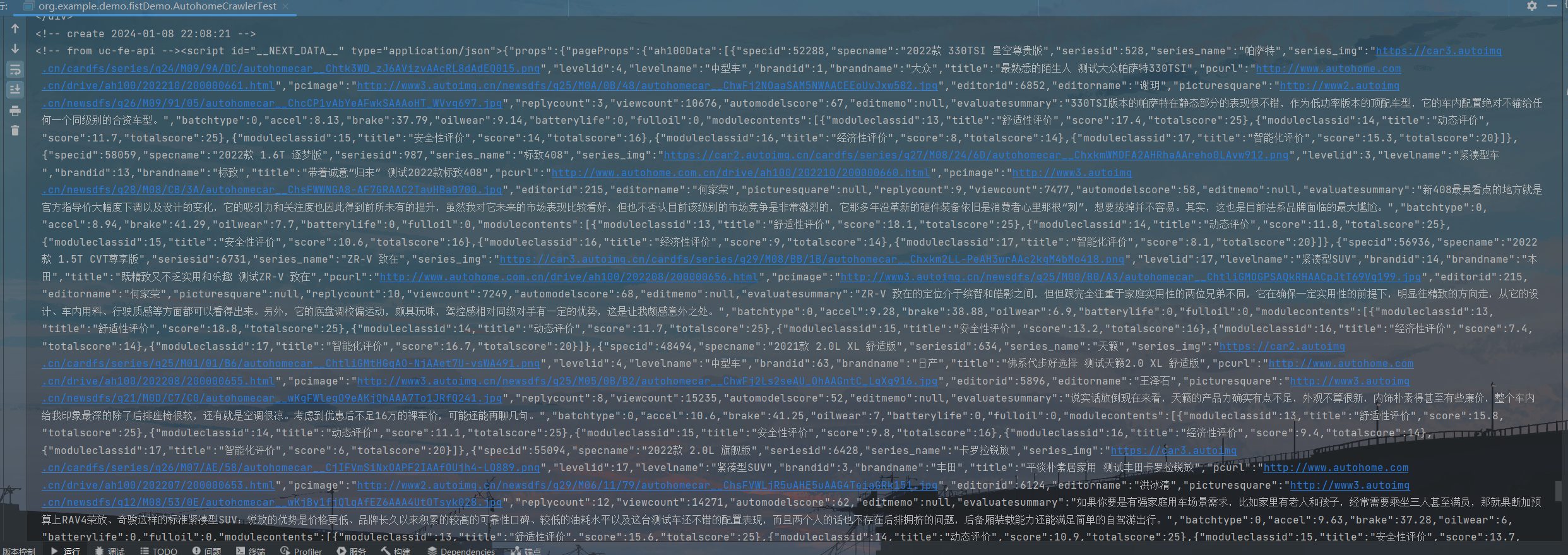

测试结果:

总结

这个小Demo展示了如何使用Java进行基本的网络爬虫操作。值得注意的是,爬取网站数据需要遵循法律规定和网站的使用条款,以及尊重隐私权和知识产权。网络爬虫在实际应用中需要更加复杂的处理,例如处理动态网页、使用代理、设置请求头等。同时,要注意网站的Robots协议,避免对网站造成不必要的压力。在进行爬虫项目时,务必遵循道德规范,以确保爬虫活动的合法性和合规性。