【推荐】多模态基础大模型技术白皮书|附下载

概述

当前,新一代人工智能已成为世界各国的竞争焦点,抢占未来技术战略制高点意义重大。由于持续开放的动态环境、各行业领域不断攀升的系统复杂度以及快速扩大的数据规模总量,智能技术应用需求不断增长,智能形态和认知水平持续深入发展。从互联网到移动互联网再到物联网、星联网时代,计算硬件体积不断压缩、功耗与成本持续降低,新一代人工智能已经成为共性支撑技术,推动经济、社会、民生、国家安全、制造等领域进行数字化和智能化转型。另一方面,伴随互联网/行业大数据、并行计算能力、机器学习算法的突破和人类智能本质认知探索的深入,新一代人工智能发展还在继续加速。

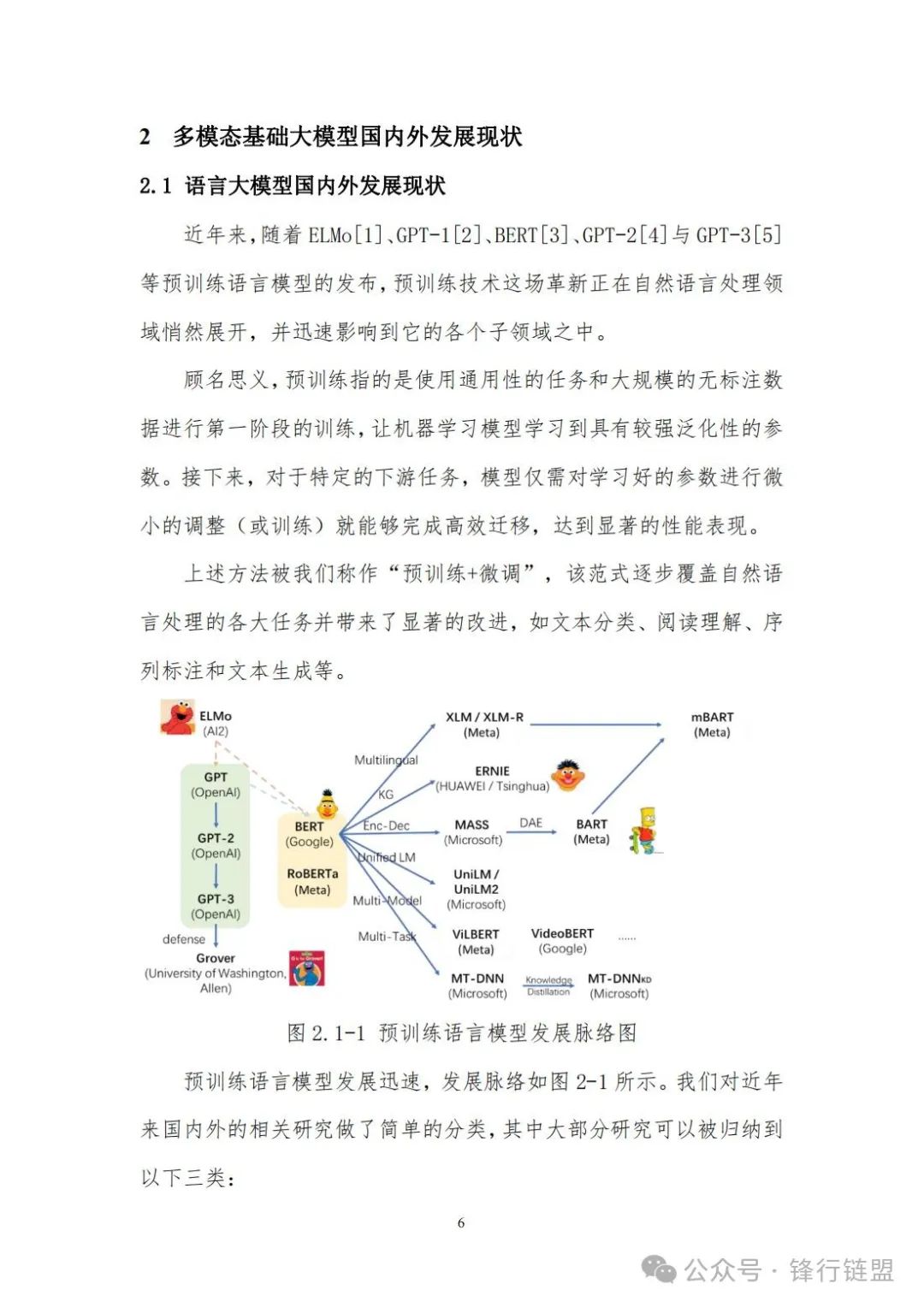

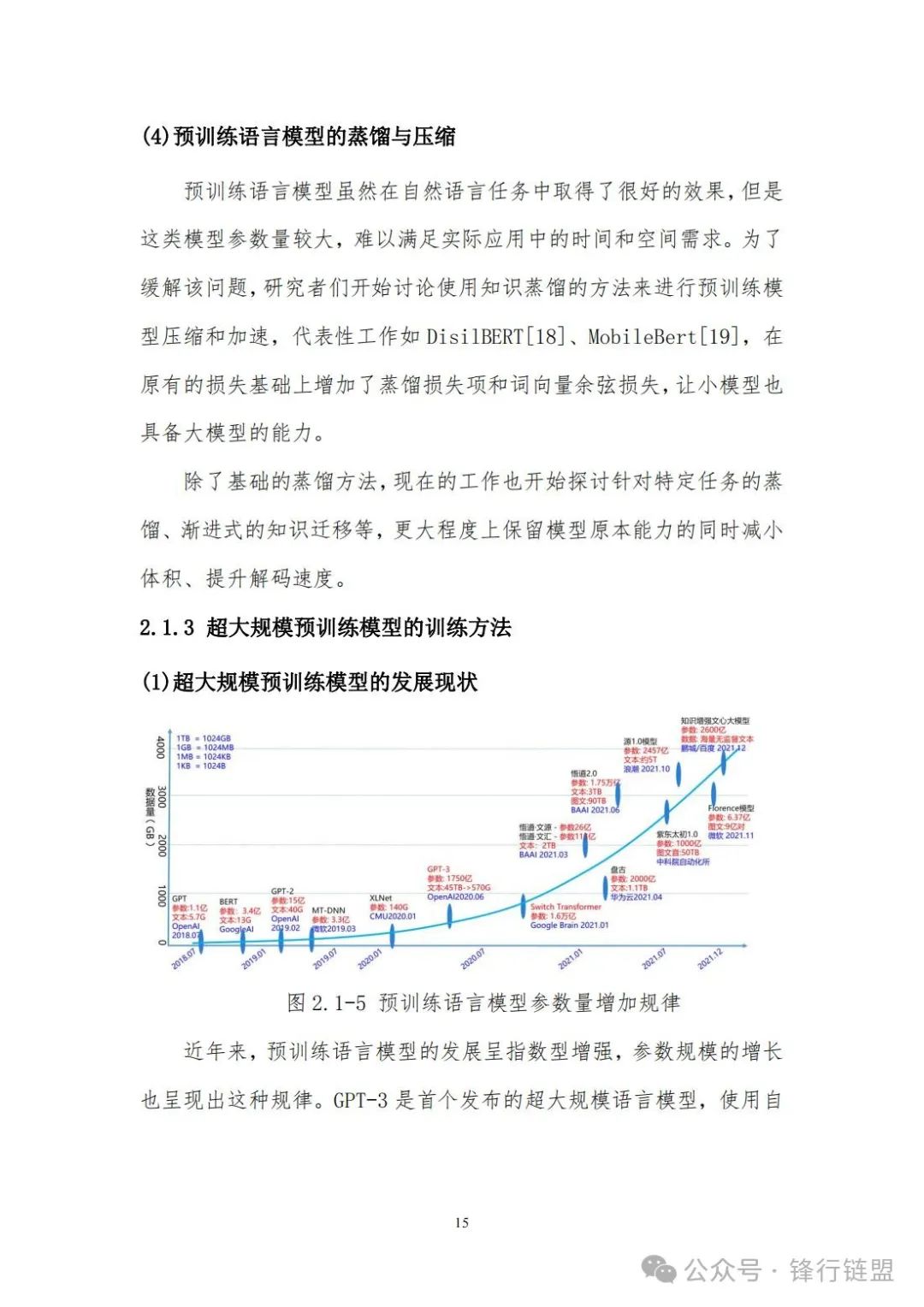

随着生成式预训练(Generative Pre-Train,GPT)、基于Transformer的双向编码器表达(Bidirectional EncoderRepresentation from Transformers,BERT)、GPT-3、DALL-E、SwitchTransformer、华为盘古、悟道、ERINE、M6等大规模预训练模型快速涌现,人工智能研究领域正在经历一场有监督学习向无监督学习条件下“大数据+大模型”的大规模预训练范式转变,即基于海量广域数据训练并且经过微调学习自动适应应用于广泛下游任务的模型。大规模预训练模型起源于自监督的语言模型,自监督的深度语言神经网络模型最初只在自然语言处理领域展开研究,直到2018年BERT模型在11项NLP任务基准上都打破了纪录,取得了巨大成功,性能远超第二名。2019年以后,基于自监督学习的语言模型已成为基础性方法,这与2012年基于卷积神经网络AlexNet在ImageNet2012上的突破很相似,标志着一个大模型时代的开始。当下,自然语言处理(Natural Language Processing,NLP)领域几乎所有的目前最先进的模型(State-Of-The-Art model,SOTA)都是基于Transformer的大模型架构进化而来的,而这种趋势也正在向图像、视频、语音等不同模态、不同领域扩散蔓延。

人工智能从单模态有监督迈向多模态自监督学习时代。目前网络数据中90%以上是图像与视频,更多知识蕴含其中。人类的信息获取、环境感知、知识学习与表达,都是采用跨模态的输入输出方式。如何设计计算机模型并使其具有强大的无监督学习与通用知识迁移能力,使不同领域任务在统一框架下实现基于低标注代价的性能提升?一种可行的路径是通过跨模态语义关联,提升多模态融合理解以及跨模态转换与生成性能。

当前,单模态预训练模型在数据规模和模型性能方面已经遇到瓶颈,而且单模型只涵盖了互联网数据中的单一模态信息,更丰富的包含文本、语音、图像、视频等多种模态数据的信息并未被充分利用与学习。此外,人类的信息获取、环境感知、知识学习与表达,都是通过多模态信息方式进行执行。

因此,为实现更加通用的人工智能模型,预训练模型必然由单模态往多模态方向发展,需将文本、语音、图像、视频等多模态内容联合起来进行学习,并专注多模态内容之间的关联特性与跨模态转换问题。这样一方面可以引入多维度的信息,另一方面可以利用互联网上大量的多模态数据,使得模型能够学习更通用化的特征表示,以此增强模型的通用性和泛化能力。

1.1多模态基础大模型简介

多模态预训练大模型架构与GPT和BERT类似,也是基于自注意力机制Transformer深度学习模型,其最大特点是模型的输入由单一模态的文本拓展到文本、语音、图像、视频等多个模态数据同时作为输入。多模态大模型主要指输入包括两种及以上模态的、参数量大于亿级的深度学习网络模型。

单模态大模型主要是指模型输入只包括一种模态(如只包括语音、图像或文本)的、大规模参数量的深度神经网络模型。一个关键的科学问题是如何设计神经网络模型并使其具有强大的无监督学习与通用知识迁移能力,使不同领域任务在统一框架下实现基于低标注代价的性能提升。一种可行的路径是通过跨模态语义关联,提升多模态融合理解以及跨模态转换与生成性能。

多模态预训练模型通常采用无监督学习的方法进行大规模训练,预训练数据来自互联网上大量的多模态数据,例如网页、视频等,无需人工标注,从而具有良好的拓展性和通用性。在不微调或采用少量数据微调的情况下,多模态预训练模型就可直接用于解决不同类型的多模态数据处理问题,例如为视频自动配上字幕、声音,输入声音和文本自动生成图像或视频片段等。多模态数据相比单模态数据更具有研究意义,但同时也存在更多的困难与挑战。

具体而言,多模态预训练模型的研究面临以下挑战:

(1)模型构建不完善

现有的多模态预训练模型往往忽略了视觉内容的语义编码,对视觉内容常使用离线训练的目标检测模型进行编码,然后进行“图像-文本”的匹配,而“目标-语义”才是实际任务中真正的需求所在。另一方面,现有模型的训练方式和优化机制沿用了语言预训练模型的范式,相对于NLP任务中的自由文本,多模态对齐数据的获取难度大,面临着数据噪声大、不同模态缺失等挑战。为此,需围绕基于全注意力机制的跨模态关联建模,对Transformer模型在视觉中的应用进行改进;充分发挥多模态预训练模型对不同模态数据间关联互补特性的有效建模能力,以及模态信息缺失情形下的鲁棒分析能力;设计与多模态预训练模型网络结构尽可能兼容的多任务学习机制,优化模型参数的学习机制。

(2)知识利用不充分

目前,多模态预训练领域通过增加训练数据和计算资源来提升模型的性能,而这种粗放耗能方式和人类大脑的集约计算方式是完全不一样的,并且这种粗放的学习方式随着数据量和计算机资源的增长,所带来的收益会越来越小,而且很快会达到性能瓶颈。另外,数据≠知识,数据是未经组织和处理的文本、声音、图像和视频,本身没有意义;而知识与内容相关,是可表示、可计算、可生长、有逻辑、可推理的更高层智能载体,是有意义的。为此,需构建知识引导的多模态预训练模型,研究多模态数据与知识统一表征的预训练模型构建、知识嵌入的多模态预训练模型构建方法、大规模预训练模型的可解释性理论,提升模型的可信可解释性。

(3)理解与生成不统一

多模态内容的理解与表达是人类智能中的最重要能力之一。然而,现有的预训练模型通常极少同时具备理解与生成能力,他们要么仅仅关注理解类而缺乏生成的能力,或者仅关注生成任务却对理解类任务表现欠佳。在实际应用中也通常需要同时对多模态数据进行理解和生成。为此,需研究多模态内容理解与生成任务统一建模,面向理解与生成任务相关的多种下游任务,包括语音识别、语音合成、视觉描述、视觉问答、视觉内容生成、跨模态检索等具体应用,设计与多模态预训练模型尽可能兼容的多任务学习机制,使得各个任务的学习能够互相兼容、互为增强,各个任务可以从其他任务中所学到的技能和知识中收益,在提升模型性能和泛化能力的同时,赋予预训练模型更强的通用性。

(4)应用部署代价高

大规模预训练模型通常包含数以亿计的参数,海量的参数量使得预训练大模型在下游任务微调和推理解码时速度慢,对计算资源要求高,计算成本大,并且无法满足线上系统的实时性要求,导致无法在实际场景开展高效部署应用。因此,需研究面向应用部署的模型推理加速、面向特定任务的模型泛化与迁移学习,实现高效的预训练学习算法,同时保障预训练模型泛化性和鲁棒性。

😝有需要的小伙伴,可以Vx扫描下方二维码免费领取🆓