强化学习(ICML2022)

Optimizing Sequential Experimental Design with Deep Reinforcement Learning

用于解决顺序实验优化设计的贝叶斯方法在数学上很优雅,但在计算上很有挑战性。最近,有人提出了使用摊销的技术,通过训练一个参数化策略,在部署时有效地提出设计,从而使这些贝叶斯方法变得实用。然而,这些方法可能无法充分探索设计空间,需要访问可微概率模型,只能在连续设计空间上进行优化。在这里,我们通过展示优化策略的问题可以简化为解决马尔可夫决策过程(MDP)来解决这些限制。我们用现代深度强化学习技术解决了等价MDP。我们的实验表明,我们的方法在部署时也具有计算效率,并且在连续和离散设计空间中表现出最先进的性能,即使概率模型是一个黑箱。

问题:

该方法涉及通过策略网络的反向传播,因此要求概率模型可微且设计空间连续。这使得这些类型的方法不适用于设计空间离散的问题,或概率模型的梯度不可用的问题

方法:

本文建议将序列实验设计(SED)问题表示为马尔可夫决策过程(MDP) (Bellman, 1957),并使用强化学习(RL)学习设计策略。由于所提出的RL智能体利用了策略梯度定理(Sutton等人,1999),因此EIG目标不需要是可微的

Neural Fisher Discriminant Analysis: Optimal Neural Network Embeddings in Polynomial Time

Fisher线性判别分析(Fisher 's Linear Discriminant Analysis, FLDA)是一种将数据点线性嵌入到低维空间以最大化判别准则的统计分析方法,使得类间方差最大化而类内方差最小化。本文提出采用神经网络的FLDA的自然扩展,称为神经Fisher判别分析(NFDA)。该方法通过寻找嵌入数据点的最优双层神经网络来优化同一判别准则。我们使用凸优化工具将最优神经网络嵌入问题转化为凸问题。由此得到的问题易于解释和求解,达到全局最优。在合成数据集和真实数据集上评估了该方法的性能。

EAT-C: Environment-Adversarial sub-Task Curriculum for RL

由于奖励稀疏,强化学习(RL)在长时间任务上效率低下,并且其策略可能对轻微扰动的环境很脆弱。本文通过由两个与强化学习联合训练的策略生成的耦合环境任务课程来解决这些挑战:(1)一个合作规划策略,将困难任务递归分解为从粗到细的子任务树;(2)在每个子任务中修改环境的对抗策略。它们是互补的,可以为强化学习获得更多信息的反馈:(1)提供更容易的子任务的密集奖励,而(2)修改子任务的环境,使其更具挑战性和多样性。相反,它们是通过强化学习对子任务的密集反馈进行训练的,因此其生成的课程可以自适应强化学习的进展。子任务树为每个策略提供了一个易于实现的课程:其自上而下的构建逐渐增加规划器需要生成的子任务,而环境和强化学习之间的对抗性训练遵循自下而上的遍历,从更容易的子任务的密集序列开始,允许更频繁的环境变化。将EAT-C与针对类似问题的强化学习/规划以及具有环境生成器或对抗性智能体的方法进行了比较。在不同任务上的广泛实验表明,所提出方法在提高强化学习的效率和泛化性方面具有优势。

Perfectly Balanced: Improving Transfer and Robustness of Supervised Contrastive Learning

一个理想的学习表示应该表现出可迁移性和鲁棒性。监督对比学习(SupCon)是一种很有前途的训练精确模型的方法,但由于类坍缩(当一个类中的所有点都映射到相同表示时),产生的表示不能捕捉这些属性。最近的工作表明,“扩展”这些表示可以改善它们,但其精确机制尚不清楚。本文认为,单独创建扩展不足以获得更好的表示,因为扩展对类内的排列是不变的。相反,正确的传播程度和打破这种不变性的机制都是必要的。首先证明了在SupCon中添加一个加权类条件InfoNCE损失可以控制传播程度。研究了三种打破排列不变性的机制:使用受限编码器、添加类条件自编码器和使用数据增强。后两者比前两者鼓励在更现实的条件下对潜在子类进行聚类。向SupCon添加一个适当加权的类条件InfoNCE损失和一个类条件自编码器,在5个标准数据集的粗到细迁移中实现了11.1点的提升,在3个数据集的最差组鲁棒性上实现了4.7点,在CelebA上使最先进水平提高了11.5点。

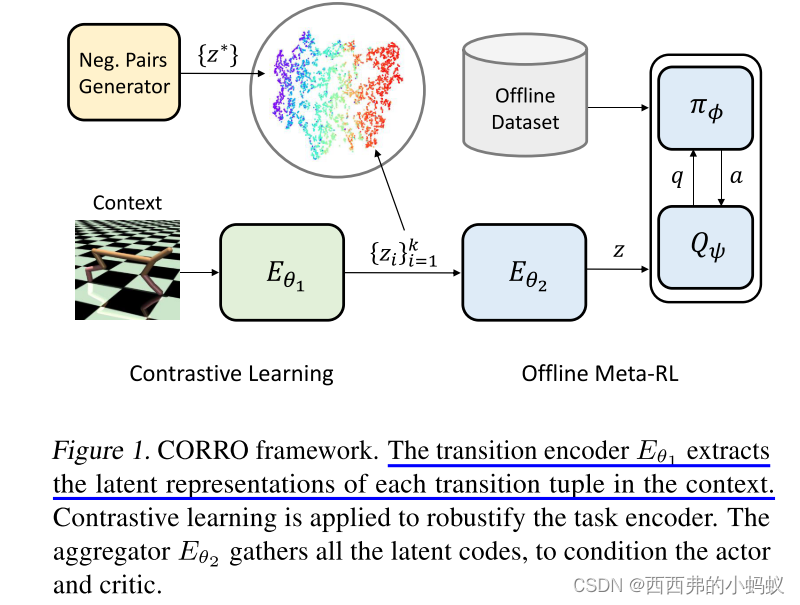

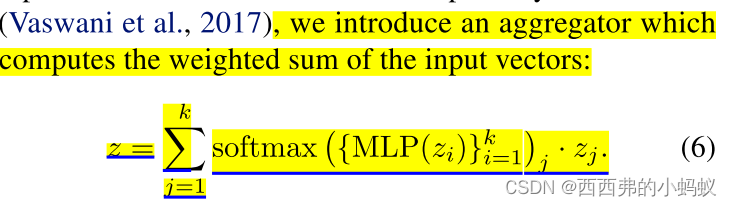

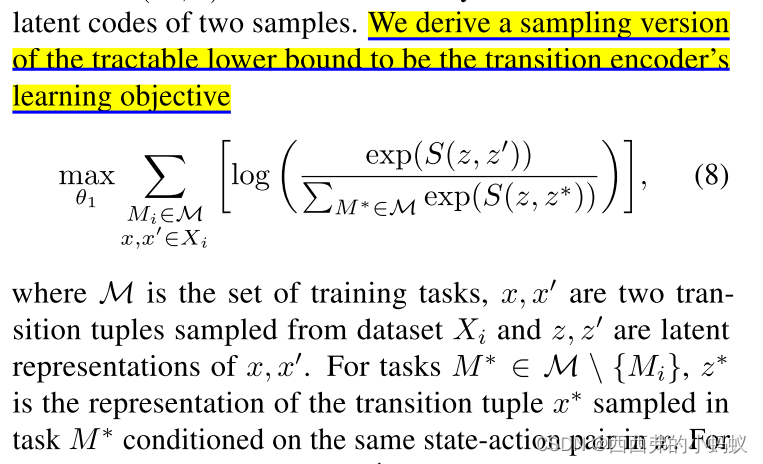

robust Task Representations for Offline Meta-Reinforcement Learning via Contrastive Learning

本文研究离线元强化学习,一种实用的强化学习范式,从离线数据中学习以适应新任务。离线数据的分布由行为策略和任务共同决定。现有的离线元强化学习算法无法区分这些因素,使得任务表示对行为策略的变化不稳定。为解决这个问题,本文提出一种任务表示的对比学习框架,对训练和测试中的行为策略分布不匹配具有鲁棒性。设计了一个双层编码器结构,使用互信息最大化来形式化任务表示学习,推导出一个对比学习目标,并引入了几种方法来近似负对的真实分布。在各种离线元强化学习基准上的实验表明,所提出方法比之前方法具有优势,特别是在对分布外行为策略的泛化方面。

方法:为解决离线任务表示问题,本文提出CORRO,一种新的对比学习框架,用完全离线的数据集进行鲁棒任务表示,降低了行为策略对任务表示的影响,同时支持奖赏函数和过渡动态性不同的任务。

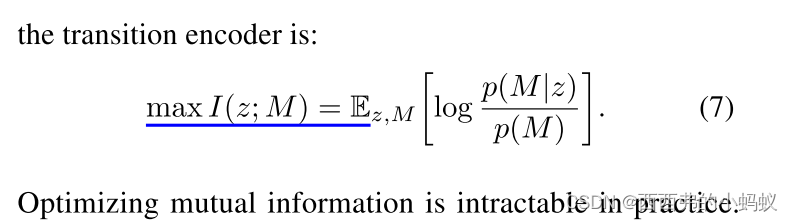

我们引入互信息来衡量任务表示和任务之间的相互依赖关系

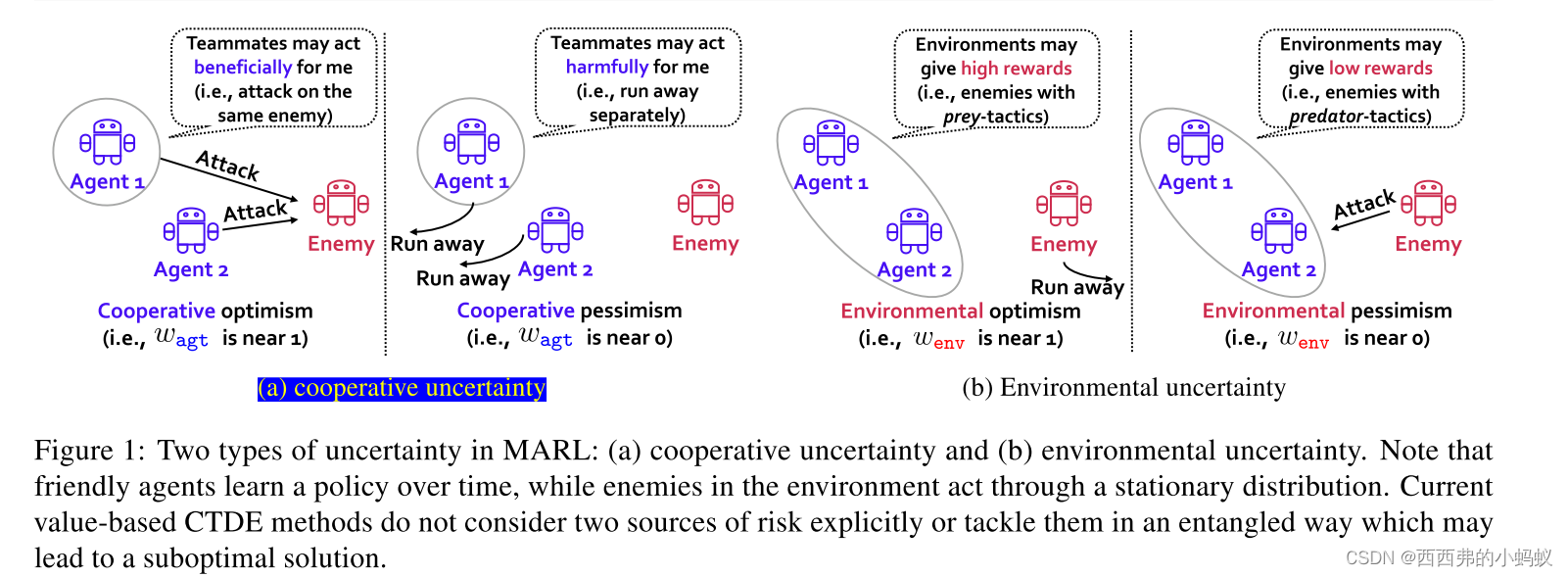

Disentangling Sources of Risk for Distributional Multi-Agent Reinforcement Learning

在合作的多智能体强化学习中,智能体策略的结果是高度随机的,因为有两个风险来源:(a)队友采取的随机行动和(b)随机转移和奖励。尽管这两种来源具有非常不同的特征,但现有框架不足以以一种分离的方式控制智能体策略的风险敏感性。本文提出解缠风险敏感的多智能体强化学习(DRIMA)来分别访问风险源。例如,我们的框架允许智能体对队友(可以亲社会适应)保持乐观,但对环境(不适应)则更加风险中立。实验表明,DRIMA在《星际争霸》多智能体挑战环境中的各种场景中明显优于之前的最先进方法。值得注意的是,DRIMA表现出鲁棒的性能,其中之前的方法只学习一个高度次优的策略,而不管奖励塑造、探索调度和噪声(随机或对抗性)智能体。

Pessimistic Q-Learning for Offline Reinforcement Learning: Towards Optimal Sample Complexity

离线或批量强化学习旨在利用历史数据学习接近最优的策略,而无需主动探索环境。为了应对许多离线数据集覆盖率不足和样本稀缺的问题,悲观主义原则最近被引入,以缓解估计值的高偏差。虽然已经对基于模型的算法的悲观变体(例如,具有下界的值迭代)进行了理论上的研究,但它们的无模型变体——不需要显式的模型估计——还没有得到充分的研究,特别是在样本效率方面。为解决这一不足,本文研究了有限时域马尔可夫决策过程背景下q学习的一种悲观变体,并在单策略集中性假设下描述了其样本复杂性,该假设不要求状态-动作空间的完全覆盖。此外,提出一种方差降低的悲观q学习算法,以获得接近最优的样本复杂度。总而言之,这项工作强调了离线强化学习中无模型算法与悲观主义和方差减少一起使用时的效率。

Policy Diagnosis via Measuring Role Diversity in Cooperative Multi-agent RL

协作式多智能体强化学习(MARL)在解决网格世界和现实世界中的任务方面取得了快速进展,在MARL中,智能体被赋予不同的属性和目标,从而导致在整个任务中表现出不同的行为。通过角色多样性(Role Diversity)量化智能体的行为差异,并建立其与策略性能的关系,这是一种衡量MARL任务特征的指标。从三个角度定义角色多样性:基于行动、基于轨迹和基于贡献,以全面衡量多智能体任务。通过理论分析,我们发现MARL中的误差界可以分解为三个与角色多样性密切相关的部分。分解后的因子可以显著影响参数共享、通信机制和学分分配3个热门方向的策略优化。主要的实验平台是基于多智能体粒子环境(Multiagent Particle Environment, MPE)和星际争霸多智能体挑战(StarCraft Multi-Agent Challenge, SMAC)。广泛的实验清楚地表明,角色多样性可以作为多智能体合作任务特征的鲁棒度量,帮助诊断策略是否适合当前的多智能体系统以获得更好的策略性能。

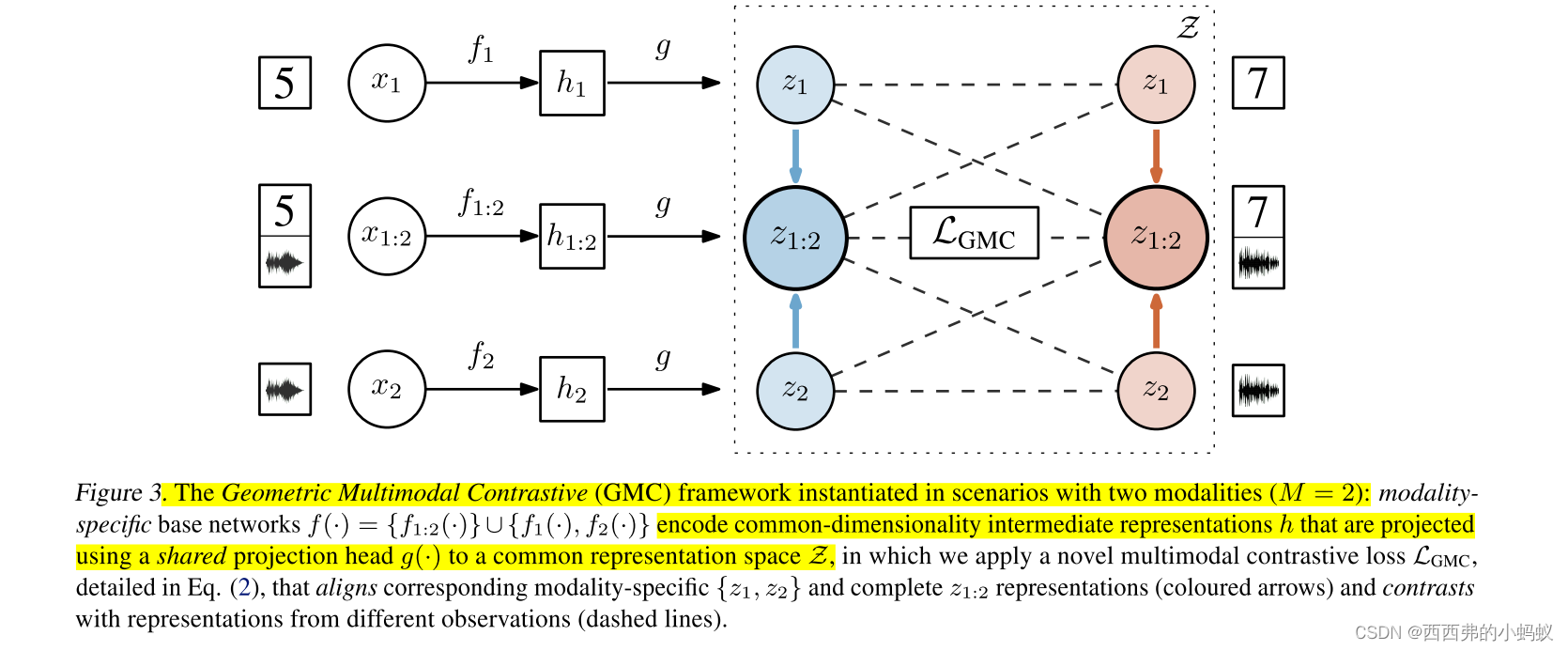

Geometric Multimodal Contrastive Representation Learning

由于从不同渠道获得的数据固有的异构性,学习多模态数据的表示仍然是一个具有挑战性的问题,因为在测试时,多模态数据的表示既包含信息,又对缺失模态具有鲁棒性。本文提出一种新的几何多模态对比(GMC)表示学习方法,由两个主要部分组成: i)一个由特定模态基编码器组成的两层架构,允许将任意数量的模态处理为固定维度的中间表示,以及一个共享的投影头,将中间表示映射到潜在表示空间;Ii)多模态对比损失函数,鼓励学习到的表示的几何对齐。实验证明,GMC表示语义丰富,并在三个不同的学习问题(包括预测和强化学习任务)上实现了最先进的性能,在缺失模态信息的情况下。

背景:

减轻异构差距的一个直观想法是将异构数据投影到共享表示空间中,以便完整观测的表示捕获所有模态共享的语义内容。

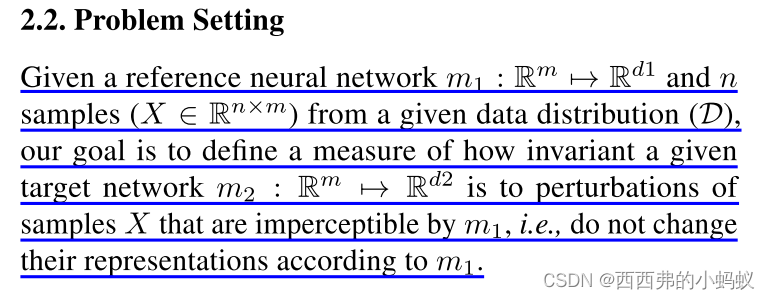

Measuring Representational Robustness of Neural Networks Through Shared Invariances

在深度学习中研究鲁棒性的一个主要挑战是定义给定神经网络(NN)应保持不变的“无意义”扰动集。大多数关于鲁棒性的工作隐式地使用人类作为参考模型来定义这种扰动。本文工作通过使用另一个参考神经网络来定义给定神经网络应不变的扰动集,为鲁棒性提供了一种新的观点,从而将对参考"人类神经网络"的依赖推广到任何神经网络。这使得测量鲁棒性等同于测量两个神经网络共享不变性的程度。本文提出一种称为STIR的方法,忠实地捕捉到两个神经网络共享不变性的程度。STIR重新利用了现有的表示相似性度量,使其适合于测量共享不变性。使用该方法,能够了解共享不变性如何随着权重初始化、架构、损失函数和训练数据集的变化而变化

Model Selection in Batch Policy Optimization

本文研究了批量策略优化中的模型选择问题:给定一个固定的、部分反馈数据集和M个模型类,学习一个性能与从最佳模型类派生的策略相竞争的策略。通过确定三个误差源,任何模型选择算法都应该最优地权衡,以具有竞争力,在上下文bandit环境下用线性模型类形式化了这个问题:(1)近似误差,(2)统计复杂度,和(3)覆盖率。前两种来源在监督学习的模型选择中是常见的,在监督学习中,人们对这两种来源的最佳权衡进行了充分的研究。相比之下,第三个来源是批量策略优化的唯一来源,是由于设置固有的数据集移位。没有任何批策略优化算法能保证同时解决这三个问题,揭示了批策略优化的困难和监督学习中可用的积极结果之间的鲜明对比。尽管有这种负面结果,放松三个误差源中的任何一个,都可以设计算法,为其余两个实现接近oracle的不等式。最后,通过实验证明了这些算法的有效性。

Deconfounded Value Decomposition for Multi-Agent Reinforcement Learning

值分解(VD)方法被广泛应用于协作多智能体强化学习(MARL)中,信用分配在指导智能体的分散执行中起着重要作用。本文从因果推理的新角度研究VD。现有VD方法中的环境是一个未观察到的混淆因子,作为全局状态和联合值函数的共因因子,导致学习学分分配的混淆偏差。提出了去创始值分解(DVD)方法,切断了从全局状态到联合值函数的后门混淆路径。该方法通过引入仅依赖于局部轨迹的轨迹图作为代理混淆因子来实现。DVD具有足够的通用性,可以应用于各种VD方法,广泛的实验表明,在星际争霸II和MACO基准上,DVD可以持续获得显著的性能提升。