机器学习概述、特征工程、机器学习算法基础

机器学习概述、特征工程、机器学习算法

- 1.机器学习概述

- 1.什么是机器学习

- 2.为什么需要机器学习

- 3.机器学习的应用场景

- 4.开发机器学习应用程序的步骤

- (1)收集数据

- (2)准备输入数据

- (3)分析输入数据

- (4)训练算法

- (5)测试算法

- (6)使用算法

- 2.数据来源与类型

- 1.数据来源

- 2.数据类型

- 3.可用的数据集

- 4.常用数据集的结构组成

- 3.数据的特征工程

- 1.特征工程是什么

- 2.特征工程的意义

- 3.scikit-learn库介绍

- 4.数据的特征抽取

- 1. 特征抽取实例演示

- 2. sklearn特征抽取API

- 3. 字典特征抽取

- 流程

- 4.分类特征变量提取

- 方法

- 5. 文本特征抽取(英文)

- 方法

- 方法

- 6. 文本特征抽取(中文)

- 方法

- TF-IDF

- 5.数据的特征处理

- 1、特征处理的方法

- 2、sklearn特征处理API

- 1、归一化

- 2、标准化

- 3、缺失值

- 6.特征工程之特征抽取与特征选择

- 1、特征选择是什么

- 2、sklearn特征选择API

- 3、其他特征选择方法

- 7.降维

- 4.机器学习基础

- 机器学习开发流程

1.机器学习概述

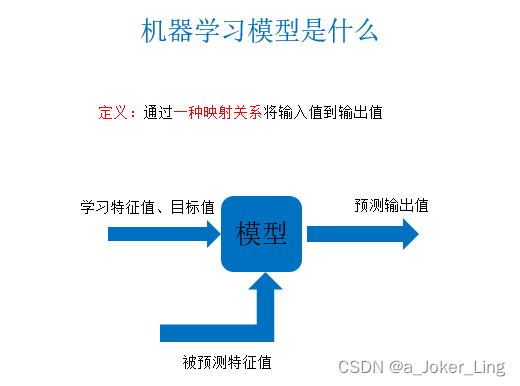

1.什么是机器学习

机器学习是人工智能的一个分支。人工智能的研究是从以“推理”为重点到以“知识”为重点,再到以“学习”为重点,一条自然、清晰的脉络。机器学习是实现人工智能的一个途径,即以机器学习为手段解决人工智能中的问题。

机器学习算法是从 数据 中自动分析获得规律(模型),并利用规律对未知数据进行预测。

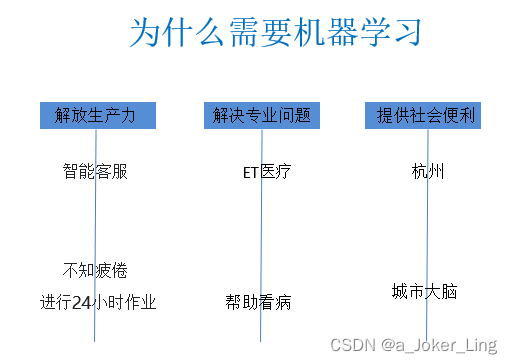

2.为什么需要机器学习

21世纪机器学习又一次被人们关注,而这些关注的背后是因为整个环境的改变,我们的数据量越来越多,硬件越来越强悍。急需要解放人的生产力,自动去寻找数据的规律。解决更多专业领域的问题。

3.机器学习的应用场景

机器学习已广泛应用于数据挖掘、计算机视觉、推荐系统、自然语言处理、生物特征识别、搜索引擎、无人驾驶、医学诊断、检测信用卡欺诈、证券市场分析、DNA序列测序、语音和手写识别、战略游戏和机器人等领域。

4.开发机器学习应用程序的步骤

(1)收集数据

我们可以使用很多方法收集样本数据,如:制作网络爬虫从网站上抽取数据、从RSS反馈或者API中得到信息、设备发送过来的实测数据。

(2)准备输入数据

得到数据之后,还必须确保数据格式符合要求。

(3)分析输入数据

这一步的主要作用是确保数据集中没有垃圾数据。如果是使用信任的数据来源,那么可以直接跳过这个步骤

(4)训练算法

机器学习算法从这一步才真正开始学习。如果使用无监督学习算法,由于不存在目标变量值,故而也不需要训练算法,所有与算法相关的内容在第(5)步

(5)测试算法

这一步将实际使用第(4)步机器学习得到的知识信息。当然在这也需要评估结果的准确率,然后根据需要重新训练你的算法

(6)使用算法

转化为应用程序,执行实际任务。以检验上述步骤是否可以在实际环境中正常工作。如果碰到新的数据问题,同样需要重复执行上述的步骤

2.数据来源与类型

1.数据来源

大部分的数据都来自已有的数据库,如果没有的话也可以交给很多爬虫工程师去采集,来提供。也可以来自平时的记录,反正数据无处不在,大都是可用的。

- 企业日益积累的大量数据(互联网公司更为显著)

- 政府掌握的各种数据

- 科研机构的实验数据

- 。。。

2.数据类型

按照机器学习的数据分类我们可以将数据分成:

- 标称型:标称型目标变量的结果只在有限目标集中取值,如真与假(标称型目标变量主要用于分类)

- 数值型:数值型目标变量则可以从无限的数值集合中取值,如0.100,42.001等 (数值型目标变量主要用于回归分析)

按照数据的本身分布特性

- 离散型

- 连续型

那么什么是离散型和连续型数据呢?首先连续型数据是有规律的,离散型数据是没有规律的

-

离散变量是指其数值只能用自然数或整数单位计算的则为离散变量.例如,班级人数、进球个数、是否是某个类别等等

-

离散型数据:由记录不同类别个体的数目所得到的数据,又称计数数据,所有这些数据全部都是整数,而且不能再细分,也不能进一步提高他们的精确度。

-

连续型数据是指在指定区间内可以是任意一个数值,例如,票房数据、花瓣大小分布数据

-

连续型数据:变量可以在某个范围内取任一数,即变量的取值可以是连续

的,如,长度、时间、质量值等,这类整数通常是非整数,含有小数

部分。

注:只要记住一点,离散型是区间内不可分,连续型是区间内可分

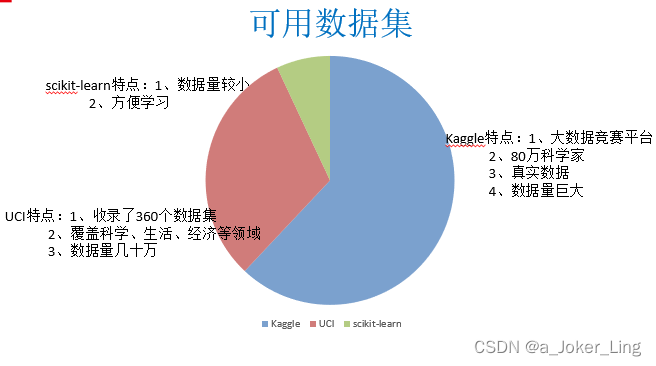

3.可用的数据集

- Kaggle网址:https://www.kaggle.com/datasets

UCI数据集网址: http://archive.ics.uci.edu/ml/

scikit-learn网址:http://scikit-learn.org/stable/datasets/index.html#datasets

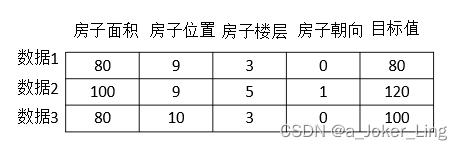

4.常用数据集的结构组成

结构:特征值+目标值

注:有些数据集可以没有目标值

3.数据的特征工程

1.特征工程是什么

特征工程是将原始数据转换为更好地代表预测模型的潜在问题的特征的过程,从而提高了对未知数据的模型准确性

从数据中抽取出来的对预测结果有用的信息,通过专业的技巧进行数据处理,使得特征能在机器学习算法中发挥更好的作用。优质的特征往往描述了数据的固有结构。 最初的原始特征数据集可能太大,或者信息冗余,因此在机器学习的应用中,一个初始步骤就是选择特征的子集,或构建一套新的特征集,减少功能来促进算法的学习,提高泛化能力和可解释性。

例如:你要查看不同地域女性的穿衣品牌情况,预测不同地域的穿衣品牌。如果其中含有一些男性的数据,是不是要将这些数据给去除掉

2.特征工程的意义

直接影响模型的预测结果

更好的特征意味着更强的鲁棒性

更好的特征意味着只需用简单模型

更好的特征意味着更好的结果

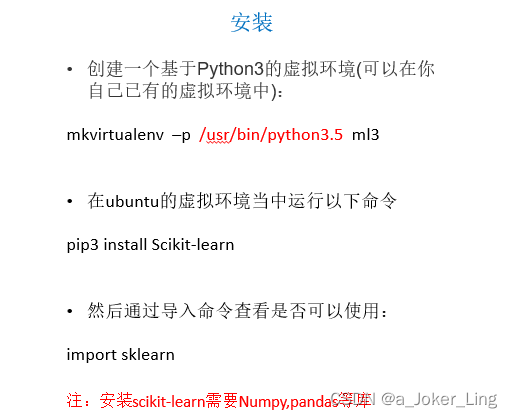

3.scikit-learn库介绍

-

Python语言的机器学习工具

-

Scikit-learn包括许多知名的机器学习算法的实现

-

Scikit-learn文档完善,容易上手,丰富的API,使其在学术界颇受欢迎。

-

基于NumPy、SciPy和matplotlib构建

-

开源、商业可用 - BSD许可

-

目前发布版本1.0

自2007年发布以来,scikit-learn已经成为最给力的Python机器学习库(library)了。scikit-learn支持的机器学习算法包括分类,回归,降维和聚类。还有一些特征提取(extracting features)、数据处理(processing data)和模型评估(evaluating models)的模块。作为Scipy库的扩展,scikit-learn也是建立在Python的NumPy和matplotlib库基础之上。NumPy可以让Python支持大量多维矩阵数据的高效操作,matplotlib提供了可视化工具,SciPy带有许多科学计算的模型。

scikit-learn文档完善,容易上手,丰富的API,使其在学术界颇受欢迎。开发者用scikit-learn实验不同的算法,只要几行代码就可以搞定。scikit-learn包括许多知名的机器学习算法的实现,包括LIBSVM和LIBLINEAR。还封装了其他的Python库,如自然语言处理的NLTK库。另外,scikit-learn内置了大量数据集,允许开发者集中于算法设计,节省获取和整理数据集的时间。

4.数据的特征抽取

现实世界中多数特征都不是连续变量,比如分类、文字、图像等,为了对非连续变量做特征表述,需要对这些特征做数学化表述,因此就用到了特征提取. sklearn.feature_extraction提供了特征提取的很多方法

1. 特征抽取实例演示

通过演示得出结论:

- 特征抽取针对非连续型数据

- 特征抽取对文本等进行特征值化

注:特征值化是为了计算机更好的去理解数据

2. sklearn特征抽取API

sklearn.feature_extraction

3. 字典特征抽取

作用:对字典数据进行特征值化

类:sklearn.feature_extraction.DictVectorizer

流程

- 实例化类

DictVectorizer - 调用

fit_transform方法输入数据并转换注意返回格式

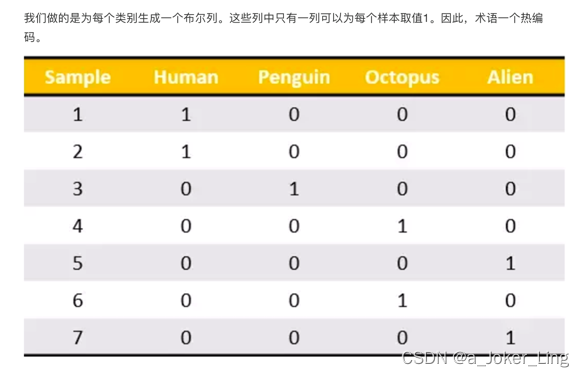

4.分类特征变量提取

我们将城市和环境作为字典数据,来进行特征的提取。

sklearn.feature_extraction.DictVectorizer(sparse = True)

将映射列表转换为Numpy数组或scipy.sparse矩阵

- sparse 是否转换为scipy.sparse矩阵表示,默认开启

方法

fit_transform(X,y)

应用并转化映射列表X,y为目标类型

inverse_transform(X[, dict_type])

将Numpy数组或scipy.sparse矩阵转换为映射列表

from sklearn.feature_extraction import DictVectorizer

onehot = DictVectorizer() # 如果结果不用toarray,请开启sparse=False

instances = [{'city': '北京','temperature':100},{'city': '上海','temperature':60}, {'city': '深圳','temperature':30}]

X = onehot.fit_transform(instances).toarray()

print(onehot.inverse_transform(X))

5. 文本特征抽取(英文)

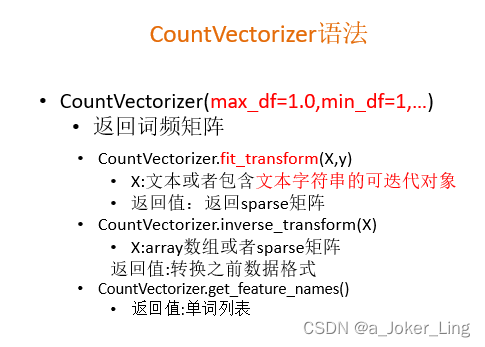

文本的特征提取应用于很多方面,比如说文档分类、垃圾邮件分类和新闻分类。那么文本分类是通过词是否存在、以及词的概率(重要性)来表示。

max_df,min_df整数:指每个词的所有文档词频数不小于最小值,每个文档中每个词的词频不超过此文档的最大值

max_df,min_df小数:每个词的次数/所有文档数量

(1)文档中的词的出现

数值为1表示词表中的这个词出现,为0表示未出现

对文本数据进行特征值化

sklearn.feature_extraction.text.CountVectorizer()

将文本文档的集合转换为计数矩阵(scipy.sparse matrices)

方法

- 实例化类

CountVectorizer - 调用

fit_transform方法输入数据并转换

注意返回格式,利用toarray()进行sparse矩阵转换array数组

vectorizer = CountVectorizer()

vectorizer.fit_transform(raw_documents).toarray()

学习词汇词典并返回词汇文档矩阵

from sklearn.feature_extraction.text import CountVectorizer

content = ["life is short,i like python","life is too long,i dislike python"]

vectorizer = CountVectorizer()

print(vectorizer.fit_transform(content).toarray())

需要toarray()方法转变为numpy的数组形式

温馨提示:每个文档中的词,只是整个语料库中所有词,的很小的一部分,这样造成特征向量的稀疏性(很多值为0)为了解决存储和运算速度的问题,使用Python的scipy.sparse矩阵结构

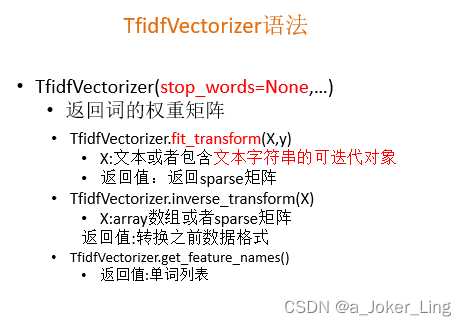

(2)TF-IDF表示词的重要性

TfidfVectorizer会根据指定的公式将文档中的词转换为概率表示。

class sklearn.feature_extraction.text.TfidfVectorizer()

方法

fit_transform(raw_documents,y)

学习词汇和idf,返回术语文档矩阵。

from sklearn.feature_extraction.text import TfidfVectorizer

content = ["life is short,i like python","life is too long,i dislike python"]

vectorizer = TfidfVectorizer(stop_words='english')

print(vectorizer.fit_transform(content).toarray())

print(vectorizer.vocabulary_)

6. 文本特征抽取(中文)

中文需要进行分词以后才能进行详细的特征值化 (jieba分词)

对三段话进行特征值化:

1、今天很残酷,明天更残酷,后天很美好,但绝对大部分是死在明天晚上,所以每个人不要放弃今天。

2、我们看到的从很远星系来的光是在几百万年之前发出的,这样当我们看到宇宙时,我们是在看它的过去。

3、如果只用一种方式了解某样事物,你就不会真正了解它。了解事物真正含义的秘密取决于如何将其与我们所了解的事物相联系。

方法

1、准备句子,利用jieba.cut进行分词

2、实例化CountVectorizer

3、将分词结果变成字符串当作fit_transform的输入值

from sklearn.feature_extraction.text import CountVectorizer

import jieba

def cutword():

# 分词后是生成器generator类型

con1 = jieba.cut("今天很残酷,明天更残酷,后天很美好,但绝对大部分是死在明天晚上,所以每个人不要放弃今天。")

con2 = jieba.cut("我们看到的从很远星系来的光是在几百万年之前发出的,这样当我们看到宇宙时,我们是在看它的过去。")

con3 = jieba.cut("如果只用一种方式了解某样事物,你就不会真正了解它。了解事物真正含义的秘密取决于如何将其与我们所了解的事物相联系。")

# 把生成器generator类型转换成列表

content1 = list(con1)

content2 = list(con2)

content3 = list(con3)

# 把列表转换成字符串,并用空格隔开

c1 = ' '.join(content1)

c2 = ' '.join(content2)

c3 = ' '.join(content3)

return c1, c2, c3

def hanzivec():

"""

中文特征值化

:return: None

"""

c1, c2, c3 = cutword()

print(c1, c2, c3)

cv = CountVectorizer()

data = cv.fit_transform([c1, c2, c3])

# print(cv.get_feature_names())

# 1.2版本以后用get_feature_names_out(),旧版本用get_feature_names()

print(cv.get_feature_names_out()) # 单词列表,统计所有文章当中所有的词,重复的只看做一次,单个字母不统计,如 I

print(data.toarray())

return None

if __name__ == "__main__:

hanzivec()

TF-IDF

TF-IDF的主要思想是:如果某个词或短语在一篇文章中出现的概率高,并且在其他文章中很少出现,则认为此词或者短语具有很好的类别区分能力,适合用来分类。

TF-IDF作用:用以评估一字词对于一个文件集或一个语料库中的其中一份文件的重要程度。

TfidfVectorizer是分类机器学习算法的重要依据

类:sklearn.feature_extraction.text.TfidfVectorizer

from sklearn.feature_extraction.text import TfidfVectorizer

import jieba

def cutword():

con1 = jieba.cut("今天很残酷,明天更残酷,后天很美好,但绝对大部分是死在明天晚上,所以每个人不要放弃今天。")

con2 = jieba.cut("我们看到的从很远星系来的光是在几百万年之前发出的,这样当我们看到宇宙时,我们是在看它的过去。")

con3 = jieba.cut("如果只用一种方式了解某样事物,你就不会真正了解它。了解事物真正含义的秘密取决于如何将其与我们所了解的事物相联系。")

# 转换成列表

content1 = list(con1)

content2 = list(con2)

content3 = list(con3)

# 吧列表转换成字符串

c1 = ' '.join(content1)

c2 = ' '.join(content2)

c3 = ' '.join(content3)

return c1, c2, c3

def tfidfvec():

"""

中文特征值化

:return: None

"""

c1, c2, c3 = cutword()

print(c1, c2, c3)

tf = TfidfVectorizer()

data = tf.fit_transform([c1, c2, c3])

print(tf.get_feature_names_out())

print(data.toarray())

return None

if __name__ == "__main__":

tfidfvec()

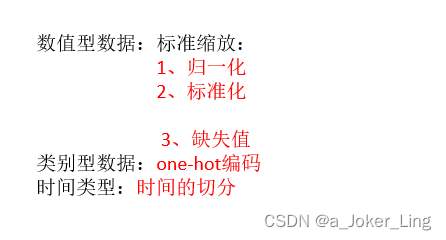

5.数据的特征处理

特征工程中最重要的一个环节就是特征处理,特征处理包含了很多具体的专业技巧

1、特征处理的方法

特征处理:通过特定的统计方法(数学方法)将数据转换成算法要求的数据

2、sklearn特征处理API

sklearn.preprocessing

特征预处理

-

单个特征

- 归一化

- 标准化

- 缺失值

-

多个特征

- 降维

- PCA

1、归一化

特点:通过对原始数据进行变换把数据映射到(默认【0,1】)区间之间。

归一化首先在特征(维度)非常多的时候,可以防止某一维或某几维对数据影响过大,也是为了把不同来源的数据统一到一个参考区间下,这样比较起来才有意义,其次可以使程序运行更快。 例如:一个人的身高和体重两个特征,假如体重50kg,身高175cm,由于两个单位不一样,数值大小不一样。如果比较两个人的体型差距时,那么身高的影响结果会比较大,k-临近算法会有这个距离公式。

注意在数据流场景下最大值最小值是变化的,另外,最大值与最小值非常容易受异常点影响,所以这种方法鲁棒性较差,只适合传统精确小数据场景。

sklearn 归一化API

sklearn.preprocessing.MinMaxScaler

归一化步骤

1、实例化MinMaxScalar

2、通过fit_transform转换

from sklearn.preprocessing import MinMaxScaler

def mm():

"""

归一化处理

:return: NOne

"""

mm = MinMaxScaler(feature_range=(2, 3)) # 默认范围为0-1

data = mm.fit_transform([[90,2,10,40],[60,4,15,45],[75,3,13,46]])

print(data)

return None

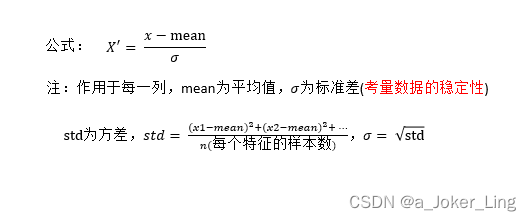

2、标准化

特点:通过对原始数据进行变换把数据变换到均值为0,方差为1范围内。

可以通过现有的样本进行估计,在已有的样本足够多的情况下比较稳定,适合嘈杂的数据场景。

对于归一化来说:如果出现异常点,影响了最大值和最小值,那么结果显然会发生改变

对于标准化来说:如果出现异常点,由于具有一定数据量,少量的异常点对于平均值的影响并不大,从而方差改变较小。

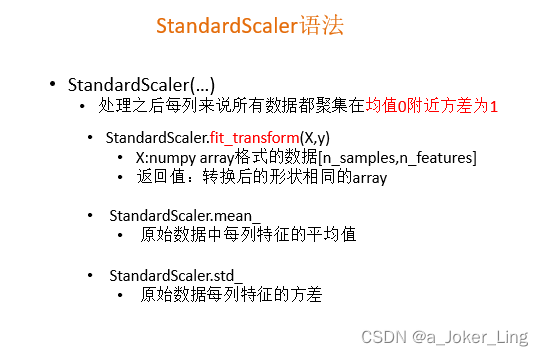

sklearn特征化API

scikit-learn.preprocessing.StandardScaler

1、实例化StandardScaler

2、通过fit_transform转换

from sklearn.preprocessing import StandardScaler, Imputer

def stand():

"""

标准化缩放

:return:

"""

std = StandardScaler()

data = std.fit_transform([[ 1., -1., 3.],[ 2., 4., 2.],[ 4., 6., -1.]])

print(data)

return None

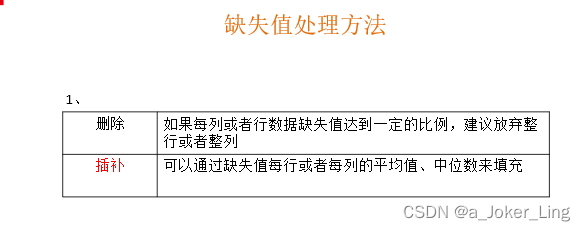

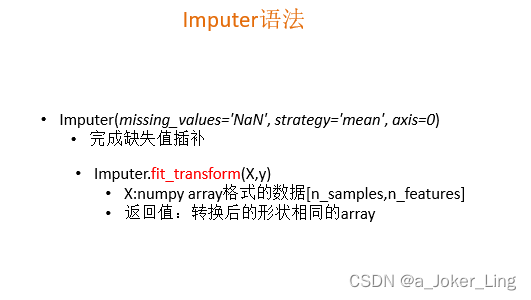

3、缺失值

由于各种原因,许多现实世界的数据集包含缺少的值,通常编码为空白,NaN或其他占位符。然而,这样的数据集与scikit的分类器不兼容,它们假设数组中的所有值都是数字,并且都具有和保持含义。使用不完整数据集的基本策略是丢弃包含缺失值的整个行和/或列。然而,这是以丢失可能是有价值的数据(即使不完整)的代价。更好的策略是估算缺失值,即从已知部分的数据中推断它们。

sklearn.preprocessing.Imputer

1、初始化Imputer,指定”缺失值”,指定填补策略,指定行或列(缺失值也可以是别的指定的要替换的值)

2、调用fit_transform

numpy的数组中可以使用np.nan/np.NaN来代替缺失值,属于float类型

如果是文件中的一些缺失值,可以替换成nan,通过np.array转化成float型的数组即可

from sklearn.preprocessing import Imputer

import numpy as np

def im():

"""

缺失值处理

:return:NOne

"""

# NaN, nan

im = Imputer(missing_values=np.nan, strategy='mean')

data = im.fit_transform([[1, 2], ['nan', 3], [7, 6]])

print(data)

return None

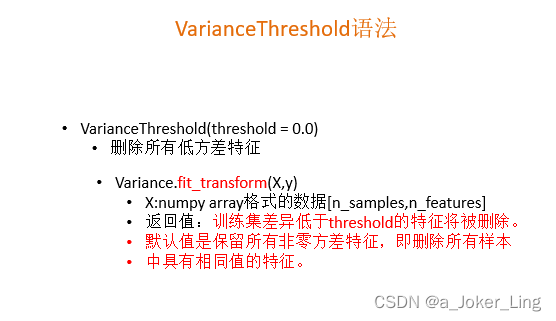

6.特征工程之特征抽取与特征选择

如果说特征处理其实就是在对已有的数据进行运算达到我们目标的数据标准。特征抽取则是将任意数据格式(例如文本和图像)转换为机器学习的数字特征。而特征选择是在已有的特征中选择更好的特征。

1、特征选择是什么

特征选择就是单纯地从提取到的所有特征中选择部分特征作为训练集特征,特征在选择前和选择后可以改变值、也可以不改变值,但是选择后的特征维数肯定比选择前小,毕竟我们只选择了其中的一部分特征。

降维本质上是从一个维度空间映射到另一个维度空间,特征的多少别没有减少,当然在映射的过程中特征值也会相应的变化。举个例子,现在的特征是1000维,我们想要把它降到500维。降维的过程就是找个一个从1000维映射到500维的映射关系。原始数据中的1000个特征,每一个都对应着降维后的500维空间中的一个值。假设原始特征中有个特征的值是9,那么降维后对应的值可能是3。而对于特征选择来说,有很多方法:

- Filter(过滤式):VarianceThreshold

- Embedded(嵌入式):正则化、决策树

- Wrapper(包裹式)

其中过滤式的特征选择后,数据本身不变,而数据的维度减少。而嵌入式的特征选择方法也会改变数据的值,维度也改变。

特征选择的原因:

冗余:部分特征的相关度高,容易消耗计算性能

噪声:部分特征对预测结果有负影响

特征选择主要有两个功能:

(1)减少特征数量,降维,使模型泛化能力更强,减少过拟合

(2)增强特征和特征值之间的理解

2、sklearn特征选择API

sklearn.feature_selection.VarianceThreshold

VarianceThreshold 是特征选择中的一项基本方法。它会移除所有方差不满足阈值的特征。默认设置下,它将移除所有方差为0的特征,即那些在所有样本中数值完全相同的特征。

1、初始化VarianceThreshold

2、调用fit_transform

假设我们要移除那些超过80%的数据都为1或0的特征

from sklearn.feature_selection import VarianceThreshold

# 特征选择--方差,剔除低方差的特征,即减少特征数量

X = [[0, 0, 1], [0, 1, 0], [1, 0, 0], [0, 1, 1], [0, 1, 0], [0, 1, 1]]

sel = VarianceThreshold(threshold=(.8 * (1 - .8)))

sel.fit_transform(X)

array([[0, 1],

[1, 0],

[0, 0],

[1, 1],

[1, 0],

[1, 1]])

3、其他特征选择方法

神经网络

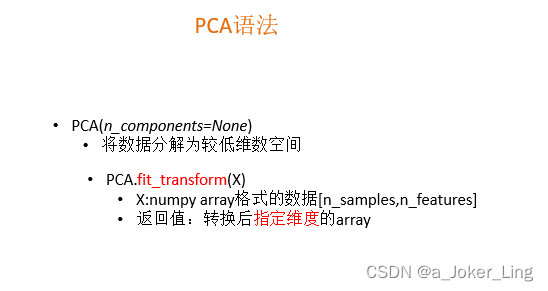

7.降维

PCA(Principal component analysis),主成分分析。特点是保存数据集中对方差影响最大的那些特征,PCA极其容易受到数据中特征范围影响,所以在运用PCA前一定要做特征标准化,这样才能保证每维度特征的重要性等同。

本质:PCA是一种分析、简化数据集的技术

目的:是数据维数压缩,尽可能降低原数据的维数(复杂度),损失少量信息。

作用:可以削减回归分析或者聚类分析中特征的数量。

高纬度数据容易出现的问题:特征之间通常是线性相关的。

sklearn.decomposition

1、初始化PCA,指定减少后的维度

2、调用fit_transform

from sklearn.decomposition import PCA

def pca():

"""

主成分分析进行特征降维

:return: None

"""

pca = PCA(n_components=0.9)

data = pca.fit_transform([[2,8,4,5],[6,3,0,8],[5,4,9,1]])

print(data)

return None

if __name__ == "__main__":

pca()

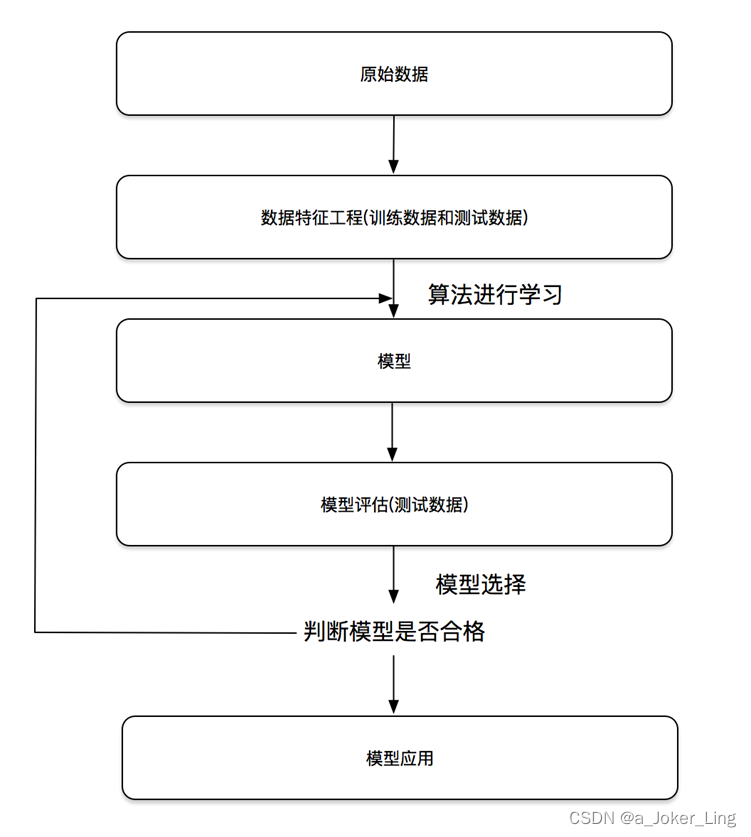

4.机器学习基础

1、需要明确的是:算法是核心,数据和计算是基础

2、找准定位

大部分复杂模型的算法设计都是算法工程师在做,而我们

- 分析很多的数据

- 分析具体的业务

- 应用常见的算法

- 特征工程、调参数、优化

我们应该怎么做:

1.学会分析问题,使用机器学习算法的目的,想要算法完成何种任务

2.掌握算法基本思想,学会对问题用相应的算法解决

3.学会利用库或者框架解决问题

机器学习开发流程

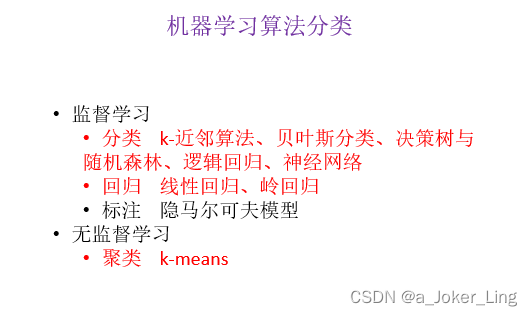

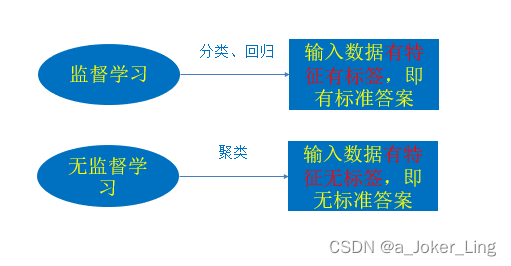

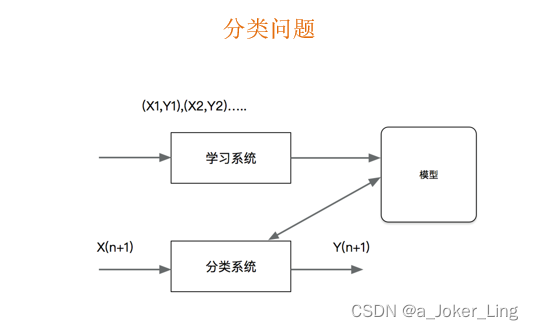

监督学习(英语:Supervised learning),可以由输入数据中学到或建立一个模型,并依此模式推测新的结果。输入数据是由输入特征值和目标值所组成。函数的输出可以是一个连续的值(称为回归),或是输出是有限个离散值(称作分类)。

无监督学习(英语:Supervised learning),可以由输入数据中学到或建立一个模型,并依此模式推测新的结果。输入数据是由输入特征值所组成。

概念:分类是监督学习的一个核心问题,在监督学习中,当输出变量取有限个离散值时,预测问题变成为分类问题。最基础的便是二分类问题,即判断是非,从两个类别中选择一个作为预测结果;

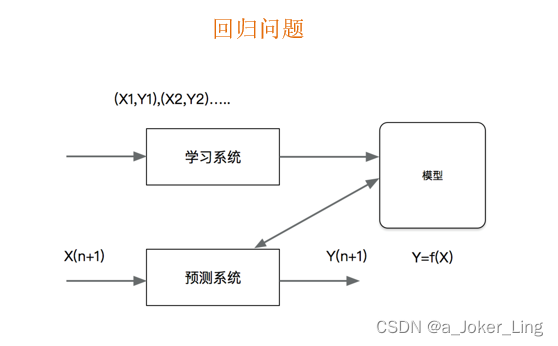

概念:回归是监督学习的另一个重要问题。回归用于预测输入变量和输出变量之间的关系,输出是连续型的值。