Pytorch混合精度(FP16FP32)(AMP自动混合精度)/半精度 训练(一) —— 原理(torch.half)

我们定义一个tensor默认都是FP32的,即单精度,single

fp16是半精度,half;fp64是双精度, double

AMP自动混合精度

一般用自动混合精度(AMP, Automatic mixed precision),用半精度可能对acc的影响较大

混合精度的performance也要看网络,有些网络的提升不大,有些网络会影响acc

AMP自动混合精度,可以在神经网络推理过程中,针对不同的层,采用不同的数据精度进行计算,从而实现节省显存和加快速度的目的。在Pytorch 1.5版本及以前,通过NVIDIA提供的apex库可以实现amp功能。但是在使用过程中会伴随着一些版本兼容和奇怪的报错问题。从1.6版本开始,Pytorch原生支持自动混合精度训练(torch.cuda.amp),并已进入稳定阶段,AMP 训练能在 Tensor Core GPU 上实现更高的性能并节省多达 50% 的内存。

原理

当前Pytorch的默认存储数据类型是整数INT64(8字节),浮点数FP32(4字节),PyTorch Tensor的默认类型为单精度浮点数FP32。随着模型越来越大,加速训练模型的需求就产生了。在深度学习模型中使用FP32主要存在几个问题,第一模型尺寸大,训练的时候对显卡的显存要求高;第二模型训练速度慢;第三模型推理速度慢。其解决方案就是使用低精度计算对模型进行优化。

精度减半(FP32→ FP16) ,训练时间减半。与单精度浮点数float32(32bit,4个字节)相比,半精度浮点数float16仅有16bit,2个字节组成。可以很明显的看到,使用FP16可以解决或者缓解上面FP32的两个问题:显存占用更少:通用的模型FP16占用的内存只需原来的一半,训练的时候可以使用更大的batchsize。计算速度更快:有论文指出半精度的计算吞吐量可以是单精度的 2-8 倍。

自动混合精度训练的精髓在于“在内存中用FP16进行tensor储存和做乘法从而加速计算,用FP32做累加避免舍入误差”。混合精度训练的策略有效地缓解了舍入误差的问题。从而加快速度,减少内存占用。缺陷是只能在支持FP16操作的一些特定类型的显卡上面使用; 而且依然会存在溢出误差和舍入误差。

FP16就是torch.half

NVIDIA GPU 使用 float16 执行运算的速度比使用 float32 快。当前很多NVIDIA GPU搭载了专门为快速FP16矩阵运算设计的特殊用途Tensor Core,比如Tesla P100,Tesla V100、Tesla A100、GTX 20XX 和RTX 30XX等。Tensor Core是一种矩阵乘累加的计算单元,每个Tensor Core每个时钟执行64个浮点混合精度操作(FP16矩阵相乘和FP32累加),英伟达宣称使用Tensor Core进行矩阵运算可以轻易的提速,同时降低一半的显存访问和存储。随着Tensor Core的普及FP16计算也一步步走向成熟,低精度计算也是未来深度学习的一个重要趋势。

动态损失放大,是为了解决使用了混合精度训练,还是会存在无法收敛的情况。因为激活梯度的值太小,造成了下溢出(Underflow)。损失放大的思路是:

具体做法

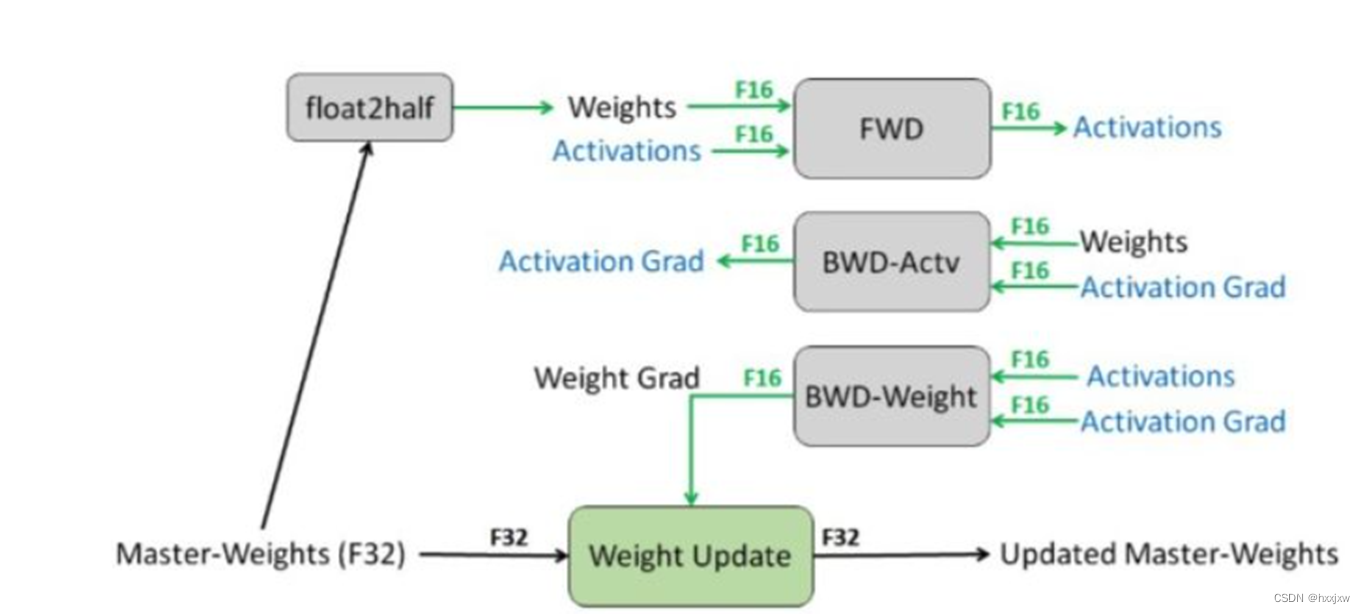

上面说过,自动混合精度训练的精髓在于“在内存中用FP16进行tensor储存和做乘法从而加速计算,用FP32做累加避免舍入误差”。

那么,从FP32转FP16容易,但是从FP16可就没法转回FP32了,就有精度损失了,所以需要进行FP32的权重备份,即weights, activations, gradients 等数据在训练中都利用FP16来存储,同时拷贝一份FP32的weights,用于更新。

因为

这样不会使得显存占用增大,因为大头activations是用FP16存的

用FP32做累加的意思是,2个FP16的值累加,产生的结果用FP32存,然后再转为FP16

并不需要两个FP16先转为FP32

实验

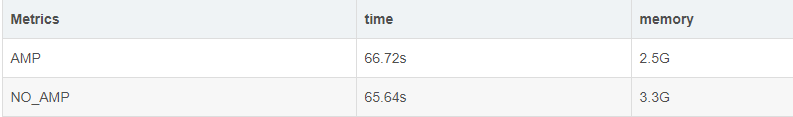

硬件使用NVIDIA Geforce RTX 3070作为测试卡,这块卡有184个Tensor Core,能比较好的支持amp模式。模型使用ERFNet分割模型作为基准,cityscapes作为测试数据,10个epoch下的测试效果如下所示:

在模型的训练性能方面,amp模式下的平均训练时间并没有明显节省,甚至还略低于正常模式。显存的占用大约节省了25%,对于需要大量显存的模型来说这个提升还是相当可观的。理论上训练速度应该也是有提升的,到Pytorch的GitHub issue里翻了一下,好像30系显卡会存在速度提不上来的问题,不太清楚是驱动支持不到位还是软件适配不到位。

在模型的精度方面,在不进行数据

shuffle的情况下统计了10个epoch下两种模式的train_loss和val_acc,可以看出不管是训练还是推理,amp模式并没有带来明显的精度损失。