解读《陆奇最新演讲实录—我的大模型世界观》

腾讯科技频道记者张小珺一篇《陆奇最新演讲实录—我的大模型世界观》刷爆朋友圈。文章知识点丰富、字里行间处处流淌着创业方法论和AI应用商机,含金量极高!

PS:一家之言、不求苟同。如有不爽之处,欢迎来 找我。

腾讯新闻原文:

“就连陆奇都说他跟不上大模型时代的狂飙速度了。他让下属做“大模型日报”,一方面便于他跟上论文和信息更新,另一方面给奇绩生态创业者共享。他用了三个“实在”表达这一点。“我实在不行了,论文实在是跟不上,代码实在是跟不上。Just too much(太多了)。”陆奇在近期一次分享活动上说。 ”

解读:

最近LLM大模型相关技术发布太密集了,还没消化完ChatGPT,马上又蹦出来下面这些,真的是乱花渐欲迷人眼!

腾讯新闻原文:

奇绩创坛创始人兼CEO陆奇是中国AI布道人,也是中国针对大模型最有发言权的人之一。他曾在全球巨头身居要职,先后任职于IBM、雅虎、微软、百度,曾是华人在美国科技公司最有权威的高层人士,位至雅虎和微软执行副总裁,回国加盟百度出任集团总裁兼COO。陆奇以勤勉的工作为科技圈著称——每天清晨4点起床,跑步5英里,6点准时到办公室。

同时,他和OpenAI有着深厚渊源。陆奇所掌管的奇绩前身是YC中国,是美国著名创业孵化器YC(Y Combinator)的中国分支。他也是YC全球研究院院长。而OpenAI首席执行官Sam Altman正是YC二代接班者、现任总裁。两人虽相差24岁,却是忘年交,相识已逾18年。当初正是Sam Altman屡次力邀陆奇加盟YC。所以,陆奇对YC、对Sam Altman和OpenAI都有长期的近距离观察。我认识Sam Altman是2005年,他那时19岁不到,我已经40多岁了。我们俩是忘年交。他是一个很善良也很奇怪的小孩,今天很高兴他能这样改变世界。前不久,我春节在美国3个月,也到OpenAI和Sam聊了一些。

解读:

简单说,陆奇博士和OpenAI创始人Sam Altman渊源颇深,可能是少数能和他说得上话且了解ChatGPT内幕的华人之一(这很关键)。这意味着他的观点是具备非常重要的参考价值的,因为大部分不了解OpenAI内幕的人对其分析和评价其实基本是靠猜,没有这么好的参考价值。

腾讯新闻原文:

陆奇希望帮助中国创业者认清这次历史性的拐点时刻,定位今天的时代坐标、找准自己的位置。“这个时代跟淘金时代很像,”他说道,“如果你那个时候去加州淘金,一大堆人会死掉。但是卖勺子、卖铲子的人永远可以赚钱。”

解读:

同意陆奇博士“AI淘金时代”观点,他自己有和Sam千丝万缕的联系,自然不需要下场“淘金”,帮OpenAI投资孵化上下游相关的AI生态项目“卖铲子”就可以了。

腾讯新闻原文:

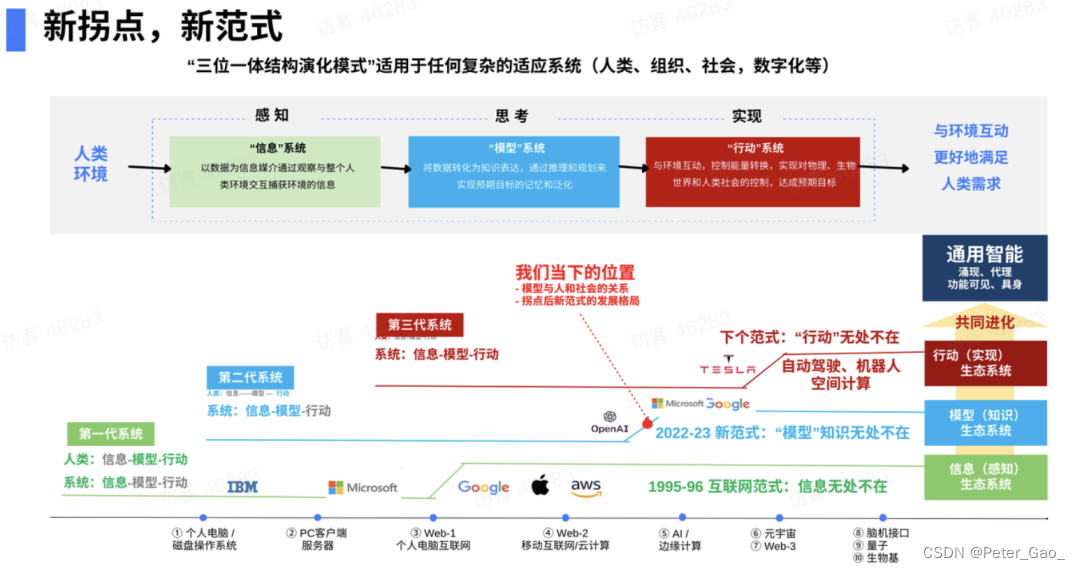

首先,怎么理解AI带来的社会新范式?这张图能把ChatGPT和OpenAI所带来的一切讲清楚。之后,基于第一性原理,你自然会推演出所在赛道的机会和挑战。

这张图是“三位一体结构演化模式”包括:

“信息”系统(subsystem of information),从环境当中获得信息;

“模型”系统(subsystem of model),对信息做一种表达,进行推理和规划;

“行动”系统(subsystem of action),我们最终和环境做交互,达到人类想达到的目的。

解读:

陆奇博士讲的新拐点、新范式是整篇文章最核心的精髓,小伙伴们看懂这一段,胜过其他万语千言!下面的内容大家要看仔细了,全是干货!

腾讯新闻原文:

今天大部分数字化产品和公司,包括Google、微软、阿里、字节,本质是信息搬运公司。一定要记住,我们所做的一切,一切的一切,包括在座的大部分企业都在搬运信息。Nothing more than that,You just move bytes(仅此而已,你只是移动字节)。但它已经足够好,改变了世界。

原因是获取信息的边际成本开始变成固定成本。

任何改变社会、改变产业的,永远是结构性改变。这个结构性改变往往是一类大型成本,现在从边际成本变成固定成本。

举个例子,当年一张地图3美元。今天我要地图,Google平均一年付10亿美元做一张地图,但每个用户使用地图,基本成本是0。也就是说,获取信息成本变0的时候,它一定改变了所有产业。

Google为什么伟大?它把边际成本变成固定成本。Google固定成本很高,但它有个简单商业模式叫广告,它能成为世界上盈利最强且改变世界的公司之一,这是拐点关键。

解读:

陆奇博士这里讲的新拐点:“获取信息的边际成本变成固定成本!”我们可以简单理解为:AI让我们获取信息变的极其容易,导致信息本身不值钱了,但流量是有价值的!当年谷歌、百度提供免费搜索服务聚合流量,靠卖广告赚的更多!今天AI爆发也是一样,人类历史上所有知识都在ChatGPT的“脑子里”,想知道什么不需要搜索,直接问它就可以了。

腾讯新闻原文:

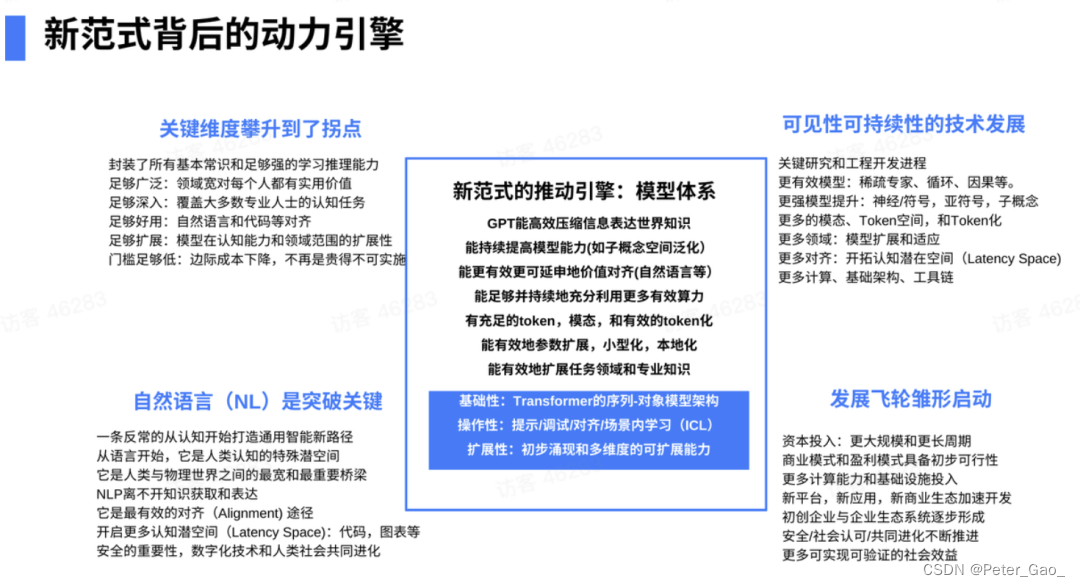

2022-2023年的拐点是什么?AI、ChatGPT!

它势不可挡,原因是什么?模型的成本从边际走向固定,因为有件事叫大语言模型。

模型的成本开始从边际走向固定,大模型是技术核心、产业化的基础。OpenAI搭好了ChatGPT这个大模型,他的发展速度爬升就很快。为什么大模型如此重要、这个拐点这么重要?因为模型和人有内在关系。我们每个人都是模型的组合。人有三种模型:

认知模型,人可以看、听、思考、规划;

任务模型,人能爬楼梯、搬椅子剥鸡蛋;

领域模型,有些人是医生,有些人是律师,有些人是码农。

我们对社会所有贡献都是这三种模型的组合。

简单想一想,如果你没有多大见解,你的模型能力大模型都有,或者大模型会逐步学会你所有的能力,那会怎样?

——未来,唯一有价值的是你有多大见解!

解读:

AI再强大目前还只是“缸中大脑”,人的价值短期内是无法被AI取代的。陆奇博士讲的“唯一有价值的是你有多大见解”我认为包含两个层面:

1,你对AI的认知和见解;

2,你对客观世界的认知和见解;

简单说,你得花时间了解AI、学习AI、使用AI,知道它有什么能力,能帮你解决什么问题。其次,你得善于观察世界和洞察人心,知道茫茫人海芸芸众生的底层需求是什么。然后,把二者结合起来,商机就出现了!

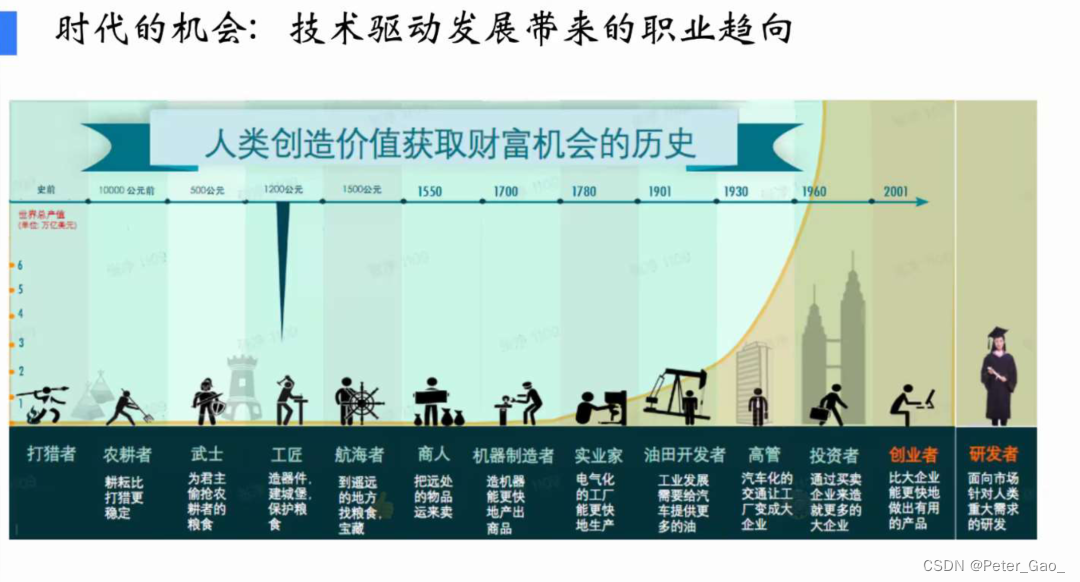

腾讯新闻原文:

人类社会是技术驱动的。随着机械化、电气化、电子化,人的体力劳动下降。信息化时代以来,人以脑力劳动为主,经济从商品经济转向服务经济——码农、设计师、分析师成为我们时代的典型职业。

这次大模型拐点会让所有从事服务行业的人和蓝领基本都受影响,因为他们只是模型,除非有独到见解,否则你今天所从事的服务大模型都能替代。下一时代典型的职业,我们认为是创业者和科学家。

所以,这次AI变革影响每个人。它影响整个社会。

解读:

陆奇博士认为下一时代的典型职业是创业者和科学家。本人深以为然,我认为,AI时代善于使用ChatGPT等工具的人会变成新时代的“超级个体”——未来人人都是钢铁侠,AI就是我们的“贾维斯”!在AI辅助之下,人与人之间的差距将变得越来越小,每个人都是“全知全能”。比如,使用AIGC工具创作内容、为地球另一端的人或企业解决问题(类似加强版的班加罗尔码农为硅谷IT企业提供技术服务外包)。相对更高的经济收入和相对更低的生活成本可以让他们拥有更好的生活质量,窃以为这也是用AI技术推动共同富裕和乡村振兴吧?

腾讯新闻原文:

哪些公司能走到下个拐点?我认为特斯拉有很高概率,它的自动驾驶、机器人现在很厉害。微软今天跟着OpenAI爬坡,但怎么站住下个拐点还有变数。和Open AI的合约达成微软何去何从?

接下来讲一下我们看到的三个拐点:

① 今天信息已经无处不在了,接下来15-20年,模型就是知识,将无处不在。

② 在未来,自动化、自主化的动作可以无处不在。

③ 人和数字化的技术共同进化。Sam最近经常讲,它必须要共同进化,才能达到通用智能(AGI)。通用智能四大要素是:涌现(emergence)+代理(agency)+功能可见性(affordence)+具象(embodiment)。

总结来说,我们从根本性的三位一体结构分析未来,从过去的历史拐点能清晰看到今天所面临的拐点,本质是模型成本从边际走向固定,将有一家甚至多家伟大公司诞生。毫无疑问,OpenAI处于领先。

虽然讲得有点早,但我个人认为,OpenAI未来肯定比Google大。只不过是大1倍、5倍还是10倍。

解读:

陆奇博士作为Sam的利益相关者,肯定是要唱红OpenAI了,唱衰Google和微软这个也完全能够理解了。谁叫Google等被印度人掌管后,把三哥那套拉帮结伙搞办公室政治的玩法带入公司,弄的乌烟瘴气,导致有本事的人斗不过有后台的人,团队内耗严重,人心思变、生产力降低。结果就是:Google几千人比OpenAI提前布局那么多年搞AI,就连Transformer的论文都是Google发表的。现在干不过ChatGPT不到300人的团队,Bard被GPT打的满地找牙,难堪得很!看起来是技术差距,其实还是人的因素、管理和愿景不同,结果就云泥之别了!相比之下,国内的环境是更好还是更差呢?相信大家都有自己的看法。

腾讯新闻原文:

下面我从技术角度讲OpenAI,它是怎么开创大模型时代的?

为什么讲OpenAI,不讲Google、微软。讲真心话,因为我知道,微软好几千人也做这个,但不如OpenAI。一开始比尔·盖茨根本不相信OpenAI,大概6个月前他还不相信。4个月前看到GPT-4的demo(产品原型),目瞪口呆。他写了文章说:It’s a shock,this thing is amazing(这太令人震惊了,这东西太神奇了)。谷歌内部也目瞪口呆。

OpenAI一路走下来的关键技术:

GPT-1是第一次使用预训练方法来实现高效语言理解的训练;

GPT-2主要采用了迁移学习技术,能在多种任务中高效应用预训练信息,并进一步提高语言理解能力;

DALL·E是走到另外一个模态;

GPT-3主要注重泛化能力,few-shot(小样本)的泛化;

GPT-3.5 instruction following(指令遵循)和tuning(微调)是最大突破;

GPT-4 已经开始实现工程化。

2023年3月的Plugin是生态化。

OpenAI的融资结构为什么这么设计?和Sam早期目标和对未来的判断分不开。他知道要融很多钱,但股权设计有一个很大挑战——容易把回报和控制混在一起——所以他要设计一个结构,让它不受任何股东的制约。于是,OpenAI的投资者没有控制权,他们的协议是一种债的结构。如果赚完2万亿,接下来是non-profit(不再盈利了),一切回归社会。这个时代需要新的结构。

解读:

陆奇博士在这里讲了OpenAI的技术发展史,我在这里给社区小伙伴分享一下OpenAI的治理结构,给要创业的同学一些启发和参考:OpenAI设计了非常独特的股权架构,充分体现了以公益为初衷的商业运作,和在商业化成功后回归公益的愿景。这种设计不是一蹴而就的,根据OpenAI发展阶段,简单概括为以下4步:

阶段一,2015年人工智能奇才Sam·Altman,与埃隆·马斯克等人宣布出资10亿美元,创立了非营利性研究机构OpenAI。

阶段二,2019年OpenAI的架构进行了调整,调整后变身为两家机构:营利性机构OpenAI LP和最初的非营利机构OpenAI, Inc。

目前我们提到OpenAI,通常指的是被称为OpenAI LP的一家有限合伙企业,在组织形态上采用的是有限合伙,这是一家盈利公司。

非营利机构OpenAI, Inc是其负责投资管理的普通合伙人(GP),这是一家在美国特拉华州注册的有限责任公司。也就是说,OpenAI LP由OpenAI, Inc控制。

阶段三,从2019年开始,微软与OpenAI建立了战略合作伙伴关系,分不少于三次,目前共投入OpenAI 130亿美元,成为OpenAI最大的有限合伙人。OpenAI LP从成立之初参与投资的VC们,也成为了有限合伙人。

阶段四,在OpenAI未来盈利后,与一般企业通过上市让投资人获得回报的做法不同,OpenAI选择了一种新的股权投资协议模式:以投资回报速度代替投资回报水平。

盈利后的OpenAI将分节奏,逐步回报投资人:

优先保证OpenAI的首批投资者收回初始资本;

微软投资完成、OpenAI LP首批投资人收回初始投资后,微软有权获得OpenAI LP 75%利润;

微软收回130亿美元投资、从OpenAI LP获得920亿美元利润后,它分享利润的比例从75%降到49%;

OpenAI LP产生的利润达到1500亿美元后,微软和其他风险投资者的股份将无偿转让给OpenAI LP的普通合伙人:非营利机构OpenAI, Inc

从以上四个阶段可以看到,本质上OpenAI是把公司借给微软,借多久取决于OpenAI赚钱的速度。

直接以投资回报速度代替投资回报水平, 这种做法是建立在OpenAI最终回归公益的愿景必然实现的强烈信念,以及管理团队能够驾驭OpenAI走向成功的充分信任基础上。

在这样的信念之下,OpenAI吸引了很多顶尖的AI研究人员,承诺绝对有竞争力的薪水和绝对的商业自由。他们毅然离开原来的科技公司和学术机构,加入OpenAI,希望专心思考人类的终极问题。这样新颖的组织结构,和略显陈腐和带着浓郁咖喱味道的Google相比,你认为哪个更有竞争力?

腾讯新闻原文

Ilya Sutskever(OpenAI联合创始人兼首席科学家)坚信两件事。

第一是模型架构。它要足够深,只要到了一定深度,bigness is betterness(大就是好)。只要有算力,只要有数据,越大越好。他们一开始是LSTM(long short term memory),后来看到Transformer就用Transformer。

第二个OpenAI相信的是,任何范式、改变一切的范式永远有个引擎,这个引擎能不断前进、不断产生价值。

最终的核心是GPT,也就是预训练之后的Transformer,它可以把信息高度压缩。Ilya有个信念:如果你能高效压缩信息,你一定已经得到知识,不然你没法压缩信息。所以,你把信息高效压缩的话,you got to have some knowledge(你得有一些知识)。

Ilya坚信GPT已经有一个世界模型在里面。虽然你做的事是predict next word(预测下一个关键词),这只不过是优化手段,它已经表达了世界的信息,而且它能持续地提高模型能力,尤其是目前研究比较多的在子概念空间当中做泛化。知识图谱真的不行。如果哪个同学做知识图谱,我认真跟你讲,你不要用知识图谱。我自己也做知识图谱20多年,just don’t do that。Just pretty bad。It does not work at all。You should use Transformer。(不要那样做。很糟糕。它根本不起作用。你应该使用Transformer。)

更重要的是用增强学习,加上人的反馈,与人的价值对齐。因为GPT已经做了4年多,知识已经封装在里面了,过去真的是用不起来,也很难用。

做大模型是很难的,很大难度是infra(基础设施)。我在微软的时候,我们每个服务器都不用网卡,都放了FPGA。网络的IO的带宽速度都是无限带宽技术(Infiniband),服务器和服务器之间是直接访问内存。为什么?因为Transformer是密度模型,它不光是算力问题,对带宽要求极高,你就想GPT-4需要24000张到25000张卡训练,试想世界上多少人能做这种系统。

以上是引擎,拐点是怎么到的?ChatGPT能在历史上第一次两个月1亿活跃用户,挡都挡不住,为什么?

① 它封装了世界上所有知识。

② 它有足够强的学习和推理能力,GPT-3能力在高中生和大学生之间,GPT-4不光是进斯坦福,而且是斯坦福排名很靠前的人。

③ 它的领域足够宽,知识足够深,又足够好用。自然语言最大的突破是好用。扩展性也足够好。当然还是很贵,像2万多张卡,训练几个月这么大的工程。不过也没贵到那么离谱——Google可以做,微软可以做,中国几个大公司能做,创业公司融钱也能做。

加在一起,范式的临界点到了。拐点已经到来。

解读:

陆奇博士在这里给做AI技术的小伙伴提了个醒:放弃知识图谱、拥抱Transformer!做为一个搞了20年知识图谱的专家,发出这样的结论,我相信他的专业判断。或许Transformer真的就像当初谷歌发布论文里说的一样【Attention is all we need】。回顾OpenAI成功,我认为关键是他们能做到与时俱进,没有门户之见,什么好用就用什么,然后敢于投入大量资源试错!成功的结果和它高远的愿景、创新组织架构、吸引的精英人才以及足够开放包容的研究和工程氛围有直接关系!

腾讯新闻原文:

OpenAI未来2-3年要做的——模型更稀疏一点,更多的模态,更多的token空间,更多的模型稳定性,更多的潜在空间(例如Latent Space对齐),更多的计算,更多的基础架构工具。2-3年基本排满。也就是说,我们大概知道需要什么去把这个引擎继续做大。

不过这个飞轮启动,主要是资本大量进来。美国2023年1月到3月,挡也挡不住,钱全进去了,每个月都在比上个月增长。中国基本也一样,商业模式、盈利模式有初步规模,基础设施、平台应用、生态在加速开发,初创公司、大型企业都在进入。

当然社会的安全、监管,一大堆问题——现在这些是OpenAI最头痛的——Sam在美国花大量精力让社会认可这个技术。现在OpenAI核心做的是,把推进速度变慢,每推进新版本,都有足够时间让用户给他们足够反馈,找到潜在风险点,有足够时间弥补。但加在一起,增长飞轮的雏形基本上起来了。

解读:

ChatGPT现在主动降低新模型的发展速度看起来似乎有点像博尔特跑百米及王蒙划速滑的时候,在绝对领先的前提下,主动降速回头看对手的意思。

但其实,这是代表了一种绝对自信:OpenAI曾经对外公开表示,如果世界上任何团队证明有能力达到接近1/10的AGI技术能力,OpenAI将停下自己的研发全力支持对手!这就是陆奇博士提到的飞轮效应:现在的ChatGPT已经有上亿活跃用户每天使用,越多人使用AI进化就越好,能力越强!能力越强用的人就越多,如此形成一个正螺旋的飞轮效应。这让对手如何竞争?恐怕连尾灯都看不到!

腾讯新闻原文:

未来的AI模型世界会怎么发展?首先是将有更多大模型出来。更多更完整的模态和更完整的世界知识在这里。你有大量的知识、更多的模态,学习能力、泛化能力和泛化机制一定会加强。

此外,会有更多的对齐工作要做。OpenAI目前会关注什么呢?今天对齐基本上是做到,有一部分人能接受但你也得罪很多人,很多人每天骂GPT。他们想要做到是足够宽的一个对齐,希望有个像美国宪章这样一个结果,虽然ChatGPT不是大家都能够认可,但它足够平稳、综合,大部分人能接受,这是对齐工程。自然语言也好,代码也好,数学公式也好,表单也好,有大量对齐工作要做。

还有更多的模态对齐。这里先讲human scale的模态,它主要是对人的描述,以人的语言为主,它的模态目前是语言和图形,以后有更多的模态会接入。这是大模型层面。

解读:

ChatGPT现在最主要的压力来自人们对GPT-4展现出的准AGI能力的恐慌,担心可能会导致很多人失业、以及AI幻觉(即GPT一本正经的胡说八道)等可能对现有社会秩序带来负面影响。这些外都可能会给OpenAI的发展带来很多麻烦。所以,慢一点,甚至暂时停下来,把模型对齐工作做好,让周遭的软环境搞好一点再出发,是审慎明智的抉择。

腾讯新闻原文:

在大模型之上建立的模型更多了。我判断主要是有两类模型和他们的组合。

第一是事情的模型,人类每一类需求都有领域/工作模型,其中有结构模型、流程模型、需求模型和任务模型,尤其是记忆和先验。

第二,人的模型,包括认知/任务模型,它是个体的,其中有专业模型,有认知模型、运动模型和人的记忆先验。人基本是这几类模型的组合,律师也好,医生也好,大量领域会有大量模型往前走。

人的模型和事的模型有本质区别,这是我过去1-2个月个人收获较多的。

今天有很多模型,比方说数字孪生,很难用。因为物理世界一直在变,这个模型僵硬、不变,就用不起来。尤其是用知识图谱建的模型,我做了几十年,超级难算,函数结构差得一塌糊涂。所以人的模型有好处,专业性强,但有很大缺点。

ChatGPT代表的模型跟人的模型相辅相成,长期可以融在一起。我们看到的未来是更多模型的生态,新的领域、新的专业、新的结构、新的场景、新的适应能力,形成闭环,不断加强认知和推理能力。当然,最终还是要所谓叫grounding,跟感知要ground,和接入行动的能力,形成真正的智能。

某种意义上20-30年后,这个模型世界跟生物世界有很多类似的地方。大模型我觉得像基因,有不同的种类,然后进化。我们目前能看到未来核心技术模型世界,它是用这个方法来向前驱动。

我们基本对这个时代的范式有了结构性的理解。那么接下来,我们如何拥抱这个时代?

解读:

这里讲到的人的模型和事的模型主要是什么呢?所谓人的模型,就是把人的相关行为需求等信息标准化成数据喂给AI建立模型,当数据足够多、足够精准,那么这个人的模型基本可以映射现实中真人的想法和需求。比如:最近比较火的乔布斯的AI模型,作者把乔布斯生平事迹等信息清洗、标注投喂给ChatGPT做了Finetun后,就可以让AI看起来好像乔布斯一样用他的口吻和偏好和人交流。而事的模型就比如现在流行的Mid Journey、Stable Diffusion等专门帮我们解决绘画这个特定需求的工具。人的模型 + 事的模型 + AI主动基于人的需求来自主设置任务付诸行动帮我们解决问题创造价值是AGI未来发展的重要方向!

腾讯新闻原文:

我个人过去10个月,每天看东西是挺多的,但最近实在受不了。就真的是跟不上。发展速度非常非常快。最近我们开始发行“大模型日报”,是我实在不行了,论文实在是跟不上,代码实在是跟不上——实在太多了

世界在变。我曾说1995-1996年有这种感觉,但现在比当时还要强。为什么?模型的成本从边际转向固定,知识创造就是模型和知识的获取,它结构性做演变了。

生产资本从两个层次全面提高。第一,所有动脑筋的工作,可以降低成本、提升产能。我们目前有一个基本假设,码农成本会降低,但对码农的需求会大量增加,码农不用担心。因为对软件的需求会大量增加,就是这个东西便宜了,都买嘛。软件永远可以解决更多问题,但有些行业未必。这是生产资本的广泛提高。

第二,生产资本深层提升。有一些行业的生产资本本质是模型驱动,比如医疗就是一个模型行业,一个好医生是一个好模型,一个好护士是一种好模型。医疗这种产业,本质是强模型驱动。现在模型提高了,科学也随之提高。在游戏核心产业,我们的产能将本质性、深度提高。产业的发展速度会加快,因为科学的发展速度加快了,开发的速度加快了,每个行业的心跳都会加快。因此,我们认为下个拐点会加速。用大模型做机器人、自动化、自动驾驶,挡也挡不住。

它对每个人都将产生深远和系统性影响。我们的假设是每个人很快将有副驾驶员,不光是1个,可能5个、6个。有些副驾驶员足够强,变成正驾驶员,他自动可以去帮你做事。更长期,我们每个人都有一个驾驶员团队服务。未来的人类组织是真人,加上他的副驾驶员和真驾驶员一起协同。

毫无疑问,每个行业也会有结构性影响,会系统性重组。这里有一个简单公式。今天动脑筋的人一天平均工资多少小时?减掉ChatGPT现在大概平均是15美元/小时,再过3年可能不到1美元,再过5年可能几十美分。然后就乘一下有多少数量。降本或者增效,让码农能变成super码农,医生变成super医生。

大家可以按这个公式算一算。如果你是华尔街的对冲基金,你可以做空一大堆行业。

举个简单例子,律师在美国平均1500美元/小时,我在网上已经看到每天有这种信息——如果你想离婚,不要找离婚律师,ChatGPT离婚很便宜啊!(全场笑)

开发人员、设计师、码农、研究人员都一样,有些是更多需求,有些是成本下降。尤其是核心产业,科学、教育、医疗,这是OpenAI长期最关注的3个行业,也是整个社会最根本的。

尤其是医疗。在中国,需求远远大于供给。而且,中国是大政府驱动的市场经济,政府可以扮演更大角色,因为固定成本政府可以承担。

最为重要的是教育。如果你是大学,你第一担心的是,考试怎么考?没法考了。他一问ChatGPT,什么都知道。更重要的是,以后怎么定义是好的大学生呢?假定说有个大学生什么都不懂,物理也不懂、化学也不懂,但他懂怎么问ChatGPT,他算不算一个好的大学生?机会与挑战并存。

总结一下,整个这个时代在高速地进行,速度越来越快。它是结构上决定的。势不可挡。

解读:

AI的爆发式进化发展,每天睁开眼第一件事就是打开新闻看看自己关注的AI企业、大咖、KOL又有哪些新技术、新工具、新模式发布...一不小心几个小时过去了,新消息也只看了一半。然后,打开网址、测试这些新产品、新技术,有些开源大模型还要自己下载部署、甚至Finetune调试,一天时间就在这样紧张而忙碌的状态下度过了。然后,感慨一下,这行发展太快了,真的跟不上节奏,累的死猪一样倒头就睡。明天又几乎是近似循环...

腾讯新闻原文:

现在,我给大家一个结构化思维框架。某种意义上你可以对号入座,知道我在这里,我怎么思考今天的机会点。

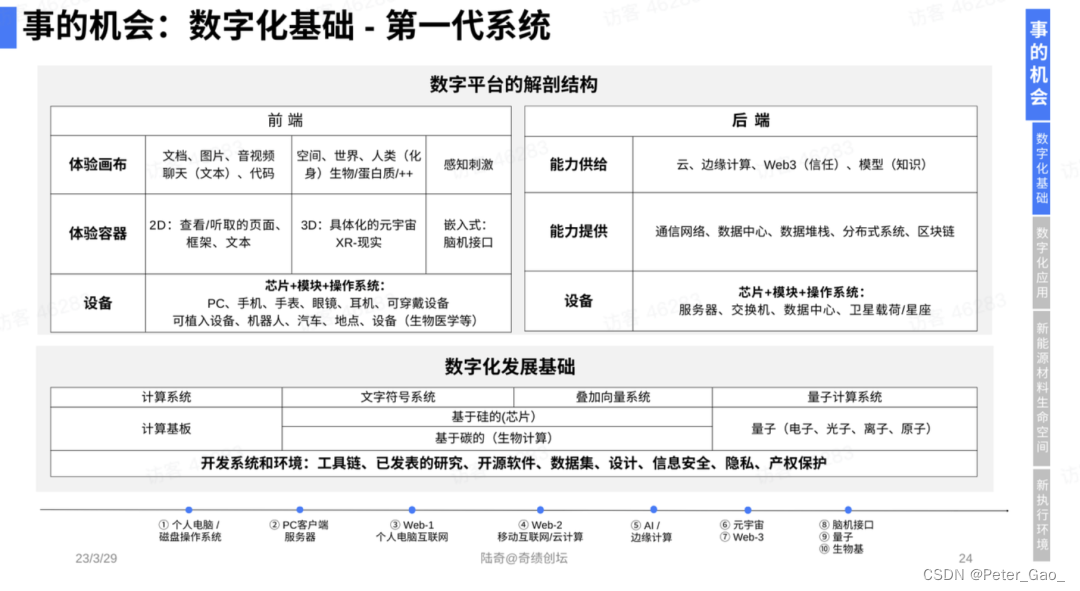

这张图是整个人类技术驱动的创业创新,所有事情的机会都在这张图上。

首先,底层是数字化的技术,因为数字化是人的延伸。数字化的基础里有平台,有发展基础,包括开源的代码、开源的设计、开源的数据;平台有前端、后端等。这里有大量机会。

第二,是用数字化的能力去解决人的需求。我们把数字化应用完整放在这张表上。

1)C端,是把所有的人分成人群,每种人群24小时,他花时间干什么?有通讯、社交、内容、游戏消费、旅游、健身……C端有一类特殊的人,这类人是改变世界的,是码农、设计师、研究员。他们创造未来。微软这么大的公司,是基于一个简单理念:微软我们就是要写更多软件、帮别人写更多软件,因为写软件是未来。

2)B端,企业需求也一样,降本增效。它要生产,有供应链、销售、客服……有了这些需求之后,数字化看得见的体验结构有6种:给你信息的,二维就够;给你三维交互体验,在游戏、元宇宙;人和人之间抽象的关系,包括信任关系、Web 3;人在物理世界环中自动驾驶、机器人等;人的内在的用碳机植入到里面,今天是脑机接口,以后有更多,以后是可以用硅基;最后是给你模型。

解读:

AI的发展让我们都有机会成为改变世界的人。这么多开源项目,只要我们肯学习、不懂就问ChatGPT,坚持下去就会有所成就。

所以创业公司基本上有三类:数字化基础,用数字化去解决人的需求,去改变物理世界。有了这个大的框架,我们可以系统性地来看对号入座:我在哪个位置?如果我在这个位置,需要关注哪些点?

首先讲数字化基础,它有一个稳定结构,不管再怎么发展,结构永远是这样。过去30多年,大部分系统或多或少我都碰过,这个结构确实相当稳定。

核心是前端和后端——前端是完整可延伸的体验,后端是完整可延伸的能力,有设备端,比方说电脑、手机、眼镜、汽车等等,设备端里面是芯片、模组加上操作系统。万亿美元的公司都在这一层。

其次是体验的容器,二维的容器,三维的容器,内在嵌入的容器。

容器之上,写代码都知道画布,画布可以是文档,可以是聊天,可以是代码,可以是空间,可以是世界,可以是数字人,也可以是碳基里的蛋白质等等。这是前端。

后端也一样,底层式设备,服务器、交换机、数据中心等等,也是芯片、模组、操作系统。

中间这一层非常重要,网络数据堆栈,分布式系统,区块链等等。

最上面是云,是能力的供给。能力供给像自然水源,打开就是算力,有存储和通讯能力。今天的模型时代,打开就是模型。

下面是数字化基础。符号计算,或者所谓的深度学习,叠加向量的浮点计算,硅基的,碳基的。

如果你是这里的创业者,机会点在哪里?

① 首先搬运信息,这个时代还有很多可以做。

如果你是做模型的,我现在判断什么都要重做一遍。大模型为先。很多设备也要重做,你要支持大模型,容器要重做,这些都有机会。云、中间的基础设施、底层的硬件,包括数字化发展核心的基础,尤其是开源的体系,这里是真正意义上是有大量机会。

解读:

研究开源大模型看起来未来很长时间可能做的都是重复造轮子的无用功,但这一步也是未来竞争壁垒的基础。假如所有创业者都去调用ChatGPT的API,都去搞Plugin,那初创团队怎么打的过那些传统互联网巨头呢?即便你搞出来一些新花样,对方比你更有钱、比你技术、运营、市场能力更强,可能最终只能沦为免费帮人家试错打样了。所以,搞AI技术的小伙伴别着急赚钱,大模型底层技术的积累真的需要耐得住寂寞,假以时日、厚积薄发,OpenAI不就是这样走过来的吗。国内相比海外创业氛围并不差,只要沉得下心,踏踏实实积累,终归会有所作为的!

③ 第三代系统,即已经开始做机器人、自动化、自主系统。孙正义今天all in。这个也能用大模型做。马斯克也看到这种机会。都是在第三代下一个拐点,创业公司完全可以把握的机会。

④ 同时并行的,我把它称作“第三代++系统”,是碳基的生物计算,这一类公司有大量的量子计算,有很多机会。元宇宙和Web 3今天点冷,但从历史长河角度来讲,只是时间问题,因为这些技术都能真正意义上带来未来的人类价值。

所以如果是这个创业项目,基础层机会就在这里。这是最好的生意。为什么?这个时代跟淘金时代很像。如果你那个时候去加州淘金,一大堆人会死掉,但是卖勺子的人、卖铲子的人永远可以赚钱。所谓的shove and pick business。

解读:

大模型是平台型机会。

按照我们几天的判断,以模型为先的平台,将比以信息为先的平台体量更大。平台有以下几个特征:

① 它是开箱即用;

② 要有一个足够简单和好的商业模式,平台是开发者可以活在上面,可以赚足够的钱、养活自己,不然不叫平台;

③ 他有自己杀手级应用。ChatGPT本身是个杀手应用,今天平台公司就是你在苹果生态上,你做得再好,只要做大苹果就把你没收了,因为它要用你底层的东西,所以你是平台。平台一般都有它的锚点,有很强的支撑点,长期OpenAI设备机会有很多——有可能这是历史上第一个10万亿美元的公司。

这是一场激烈的竞争平台之战,未来一个体量很大的公司。在这个领域竞争是无比激烈。The price is too big(代价实在太大),错过太可惜。再怎么也得试一试。

创新,尤其是创业公司落地,它永远是技术推动和需求拉动的组合。在落地的过程中,对需求理解的把控,掌握和满足需求的方法是一切当中最重要。长期一定是技术驱动为主,但在落地的时候对需求的拆解、分析、梳理,把控好需求,是一切的一切。

有一个机密大家今天都知道了——OpenAI是用GPT-4做GPT-5,每个码农都是放大能力的码农。它规模效应不一样,马太效应不一样,从此壁垒和竞争格局不一样,知识产权结果不一样,国际化的格局也不一样。中国显然有机会。

解读:

东西方这堵墙的存在对于国内AI创业者来说既是挑战也是机会。挑战是如何规避政策风险安稳发展,机会是国内外的潜在对手都被墙阻隔,短期无法窥探对面阵容。善于使用AI工具是一切竞争力的基础,这一点大家务必切记!

创业公司的内在结构是人和事的组合。人,一开始是创始人/创始团队;他有初心,内在驱动力、外在驱动力;他能独立思考,判断未来;他能行动导向,解决问题;他能需求导向,找到价值;最终通过沟通获得资源。接下来是产品市场匹配,这部分就是研发技术、研发产品、交付产品。商业模式是收到钱、更多增长、触达更多客户、融更多钱、一直触达到未来的价值。组织上,通过系统建设,开拓面向未来的人才、组织结构和文化价值观等等。这一切就是一家公司的总和。

我们对每位同学的建议是,不要轻举妄动,首先要思考。

① 不要浮夸,不能蹭热。我个人最反对蹭热,你要做大模型,想好到底做什么,大模型真正是怎么回事,跟你的创业方向在哪个或哪几个维度有本质关系。蹭热是最不好的行为,会浪费机会。

② 在这个阶段要勤于学习。新范式有多个维度,有蛮大复杂性,该看到的论文要看,尤其现在发展实在太快,非确定性很大。我的判断都有一定灰度,不能说看得很清楚,但大致是看到是这样的结果。学习花时间,我强烈推荐。

③ 想清楚之后要行动导向,要果断、有规划地采取行动。如果这一次变革对你所在的产业带来结构性影响,不进则退。你不往前走没退路的,今天的位置守不住。如果你所在的产业被直接影响到,你只能采取行动。

解读:

陆奇博士这些观点都是金玉良言,做为连续创业者和天使投资人,我要举双手赞成!大家一定来牢记,时刻检视自己

接下来我想讲几个维度——每个公司是一组能力的组合。

① 产品开发能力方面,如果你的公司以软件为主,毫无疑问一定对你有影响,长期影响大得不得了。尤其是如果你是做C端,用户体验的设计一定有影响,你今天就要认真考虑未来怎么办。

② 如果你的公司是自己研发技术,短期有局部和间接影响,它可以帮助你思考技术的设计。长期核心技术的研发也会受影响。今天芯片的设计是大量的工具,以后大模型一定会影响芯片研发。类似的,蛋白质是蛋白质结构设计。不管你做什么,未来的技术它都影响。短期不直接影响,长期可能有重大影响。

③ 满足需求能力,满足需求基本就要触达用户,供应链或运维一定受影响。软件的运维可以用GPT帮你做,硬件的供应链未必。长期来看有变革机会,因为上下游结构会变。你要判断你在这个产业的结构会不会变。

④ 商业价值的探索、触达用户、融资,这一切它可以帮你思考、迭代。

最后是关于人才和组织。

① 首先讲创始人。今天创始人技术能力强,好像很牛、很重要,未来真的不重要。技术ChatGPT以后都能帮你做。你作为创始人,越来越重要、越来越值钱的是愿力和心力。愿力是对于未来的独到的判断和信念,坚持、有强的韧劲。这是未来的创始人越来越重要的核心素养。

② 对初创团队,工具能帮助探索方向,加速想法的迭代、产品的迭代,甚至资源获取。

③ 对未来人才的培养,一方面学习工具,思考和探索机会,长期适当时候培养自己的prompt engineer(提示工程师)。

④ 最后讲到组织文化建设,要更深入思考,及早做准备,把握时代的机会。尤其是考虑有很多职能已经有副驾驶员,写代码也好,做设计也好,这之间怎么协同?

我们面临这样一个时代的机会。它既是机会,也是挑战。我们建议你就这个机会做全方位思考。

总结:

AI时代大潮,势不可挡。大家一定不要短视,AI是一个远胜工业革命和信息革命的断代式发展契机,我们要志存高远,不要急于短期套利,好好钻研技术、产品和内容,高筑墙、广积粮,厚积薄发!

一起加油,聚焦。

解读陆奇博士的“大模型世界观”_NaiveCode的博客-CSDN博客

陆奇最新演讲实录:我的大模型世界观